【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】v4.0.11

【复现路径】同时扩容了4个tikv节点,其中有2个节点在扩容数据平衡后leader慢慢降为0,IO非常高,扩容的服务器是机房搬迁之前缩容过的。

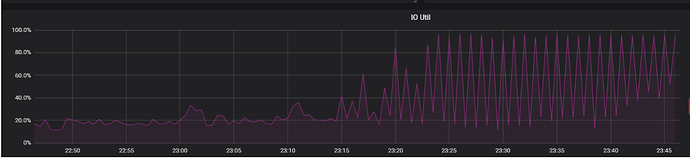

【遇到的问题:问题现象及影响】为什么扩容后的tikv节点有的leader慢慢变为0,IO非常高,达到99%,如图所示:

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

可以考虑调整 region-schedule-limit 和leader-schedule-limit 来控制调度速度,从而避免个别节点负载过高

如果你是ssd磁盘 不用看iounit指标

那个是hhd盘用的 ssd的写是并行的

看看 tikv 节点 的评分,4.x.x 的评分机制属于早期的,后期的版本有一些环境上的调整和完善

评分机制会影响region 的调度

先看下overview -tikv 的几个相关监控

1 个赞

看看placement-rules有没有特殊设置

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。