【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】v4.0.11 4tikv 3pd 16tikv

【复现路径】进行一个tikv节点缩容。

【遇到的问题:问题现象及影响】缩容到后面,leader和region都很少,但是这个时候的速度很慢,有办法处理吗?

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

看下其他tikv节点的空间使用率到80%了没,没到的话,pdctl调整这几个参数,可以加快迁移速度。

config SET leader-SCHEDULE-LIMIT 64

config SET replica-SCHEDULE-LIMIT 80

store LIMIT ALL 5

在进行 TiKV 节点缩容时,如果遇到速度慢的问题,可以通过调整一些关键参数来尝试改善情况。以下是一些参数及其推荐的调整方法,但请注意,具体的值需要根据您的实际情况进行调整:

- 调整 PD 调度配置:

- 可以使用

pd-ctl配置命令来修改调度参数。例如,增加region-schedule-limit可以加快 region 的调度速度:

pd-ctl config set region-schedule-limit 32

- 使用

pd-ctl工具进行 region 散列:

- 使用

scatter命令可以打散 region 的分布,从而加速 region 的迁移:

pd-ctl scatter-region --region-id <region_id>

- 手动迁移 leader:

- 如果特定节点的 leader 太多,可以使用

transfer-leader命令手动迁移 leader:

sh

pd-ctl transfer-leader --region-id <region_id> --target-id <store_id>

- 优化 TiKV 配置:

- 编辑 TiKV 的配置文件

tikv.toml,调整相关参数。例如,设置enable-compaction-filter为true可以减少不必要的 compaction:

toml复制

[storage]

enable-compaction-filter = true

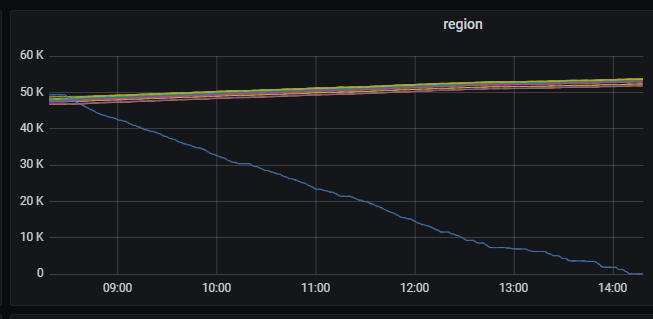

看下你的region监控呢 是不是和我差不多,最后几百个的时候有点慢

在最后剩下一点没有迁移了,应该跟这个没关系把,就像copy文件最后一点点会慢

可以调整schedule.leader-schedule-limit、schedule.region-schedule-limit等参数来增加同时进行leader和region调度的任务个数。

为啥将store LIMIT从默认的15降到5啊,我把这个参数调大了

官方 PD 调度指南 里其实有指南,可以按照对应的几个方面都排查一下

你是不是混布了?

加快速度就好了

最后很慢,应该跟调度参数关系不大,看下其他tikv节点的磁盘空间。

应该是其他故障了

如果是只剩个位数的 region 的时候很慢, 那就跟调度参数没关系了,可能这个 region 被占用了,比如上面有读写,如果非要强制操作的话 ,可以用 pd-ctl remove-peer ,一般来说等等就好了

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。