【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】

【复现路径】3台tikv服务器,其中一台cpu占用很高,其他2台占用很低,怎么优化下

【遇到的问题:3台tikv服务器,其中一台cpu占用很高,其他2台占用很低,怎么优化下

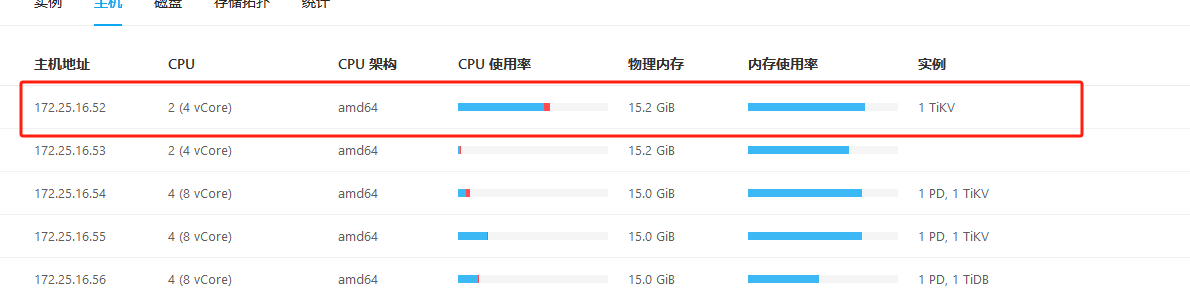

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

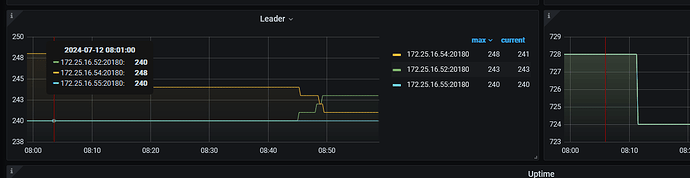

grafana看下3个tikv的leader分布

1.有没有混合部署。 2.regin leader 分布 3。有没有热点 4.查看cpu高的那个机器什么进程占用比较高。5.硬件的问题。等等…

就这么点 cpu ,随便用一下就不均衡了,去操作系统用 top 命令看看吧

1.检查负载高的TiKV服务器上运行的TiKV进程的CPU使用情况。

2. 如果服务器因为磁盘I/O压力大而导致CPU使用率高,考虑增加存储容量或优化存储配置。

3. 检查TiKV的配置文件,确保所有节点的配置参数一致。

4.考虑使用TiFlash来分担读取负载,特别是针对复杂的查询操作。

话说,技术手册不是说PD会根据tikv的负载自动调度么?

我也认为会自动调度,实际上 一个都100%了 其他才开始动

你这leader看着也算均衡啊。

那就是访问 leader 不均衡了?dashboard 的热力图有看到热点表的一些信息吗,试着手动再打散一下?

能不能直接调整tikv的优先率

pd的这个自动调度应该是考虑了磁盘占用率和region的读写量,但是cpu使用率没有考虑。另外你这个资源确实如虾总说的资源那么点,就2c。查哪个节点的region,这个节点的cpu就搞起来了。你这个优化意义也不大。

如果非得要优化的话,试试调一下region weight。降低一些这个高cpu的节点的region和leader数。

pd-ctl store weight store_id leader_weight region_weight

例子:

pdctl store weight 1 0.8 0.8

store_id 是指什么了

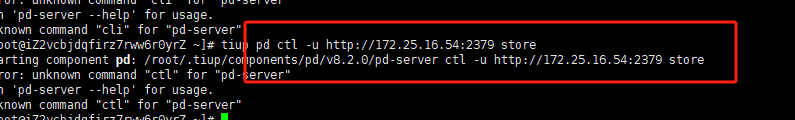

pdctl store 就看到了,所有的tikv信息就都列出来了。里面有个store_id

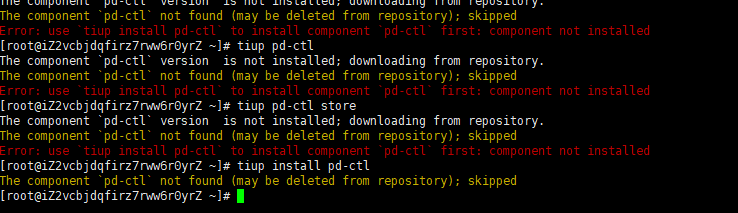

tiup的命令我不太熟悉

你试试这样行么:

tiup ctl pd -u http://127.0.0.1:2379 store

其中ip换成你的pd的ip

我觉得PD应该可以自动进行调整。