【 TiDB 使用环境】生产环境

【 TiDB 版本】5.4.3

生产环境现在又2个TiCDC 节点,目前发现流量大的时候sorter 特别的慢,想要扩容看看能不能解决该问题

请问TiCDC 集群扩容节点后,ticdc 的任务会自动打散到新扩容的节点吗

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

【 TiDB 使用环境】生产环境

【 TiDB 版本】5.4.3

生产环境现在又2个TiCDC 节点,目前发现流量大的时候sorter 特别的慢,想要扩容看看能不能解决该问题

请问TiCDC 集群扩容节点后,ticdc 的任务会自动打散到新扩容的节点吗

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

会自动均衡,而且非常平均

感谢大佬回答,扩容后不用重启ticdc 的任务是吗

不需要重启

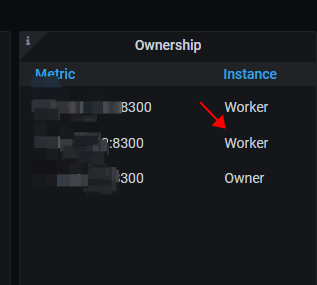

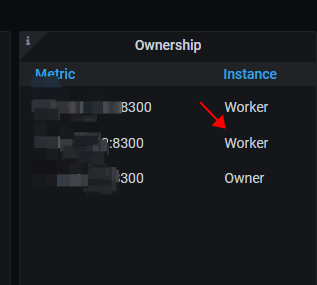

扩容扩上去了,现在又2个worker 节点,1个owner 节点,但是任务还是在之前的那个worker 节点上跑

大佬们在5.4.3 这个版本验证过TiCDC 扩容会自动均衡ticdc fead 任务这个逻辑吗 ![]()

@小龙虾爱大龙虾 @porpoiselxj 大佬们辛苦帮忙再看看

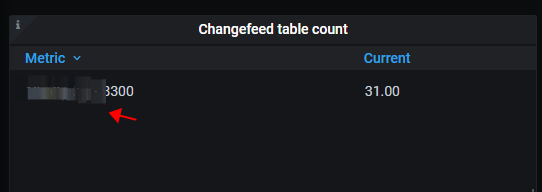

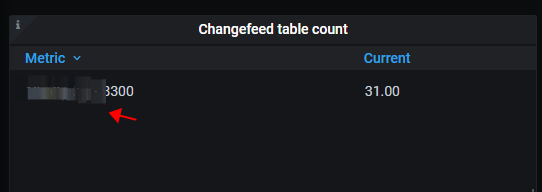

这个 ticdc 是按表、分区级别均衡的,比如说你任务有 60 张表要同步, 3个节点,可能每个节点就会分 20 个,前边说了,你可以看监控上,监控上可以看到分到的表的量,或者使用 cdc cli changefeed query -c <changefeed_name> 命令,查看任务的详细信息,也可以看到分到各节点的 table_id / parition_id。

大佬,我有看懂你写的意思

我上面也截了图,发现扩了一个worker 节点上去,任务还是在之前那个worker 节点上,并没有均衡到新的worker 节点

均衡是需要一段时间吗?

现在有2个worker 节点,只有1个worker 节点上有任务在跑是符合预期的吗

感觉是不太符合预期的,一般均衡的时间比较快,相关官方文档介绍:https://docs.pingcap.com/zh/tidb/stable/ticdc-architecture#changefeed-和-task

grafana 截图时时间选择的是最新时间吗,你现在集群状态没有问题吗,新扩容进的日志有什么东西吗

你可以用 cdc cli 查询下状态看下

grafana 的截图是最新的,用cdc cli 看了下任务 有报

“code”: “CDC:ErrOwnerUnknown”,

“message”: “[CDC:ErrReachMaxTry]reach maximum try: 1m0s, error: [CDC:ErrPDBatchLoadRegions]pd batch load regions failed: receive Regions with no peer: [CDC:ErrPDBatchLoadRegions]pd batch load regions failed: receive Regions with no peer” 这个错误

不知道是不是5.4.3 版本的bug ![]()

你这都超时了 ![]() 感觉环境有点问题

感觉环境有点问题

先看看同步任务是否正常吧,如果正常,明天再查吧

![]() 会不会是之前的任务没有跑完,所以没有均分?

会不会是之前的任务没有跑完,所以没有均分?

大佬是什么意思呢? 之前的啥任务没跑完呢? cdc worker 任务均衡具体是什么逻辑呢? 看文档也没看到这个相关的

我理解的是和TiDB server一样,如果一个owner节点的tidb执行没完成的时候,不会分到其他节点上执行。

找到一个类似的帖子 ![]() 重启过么?

重启过么?