【 TiDB 使用环境】生产环境

【 TiDB 版本】

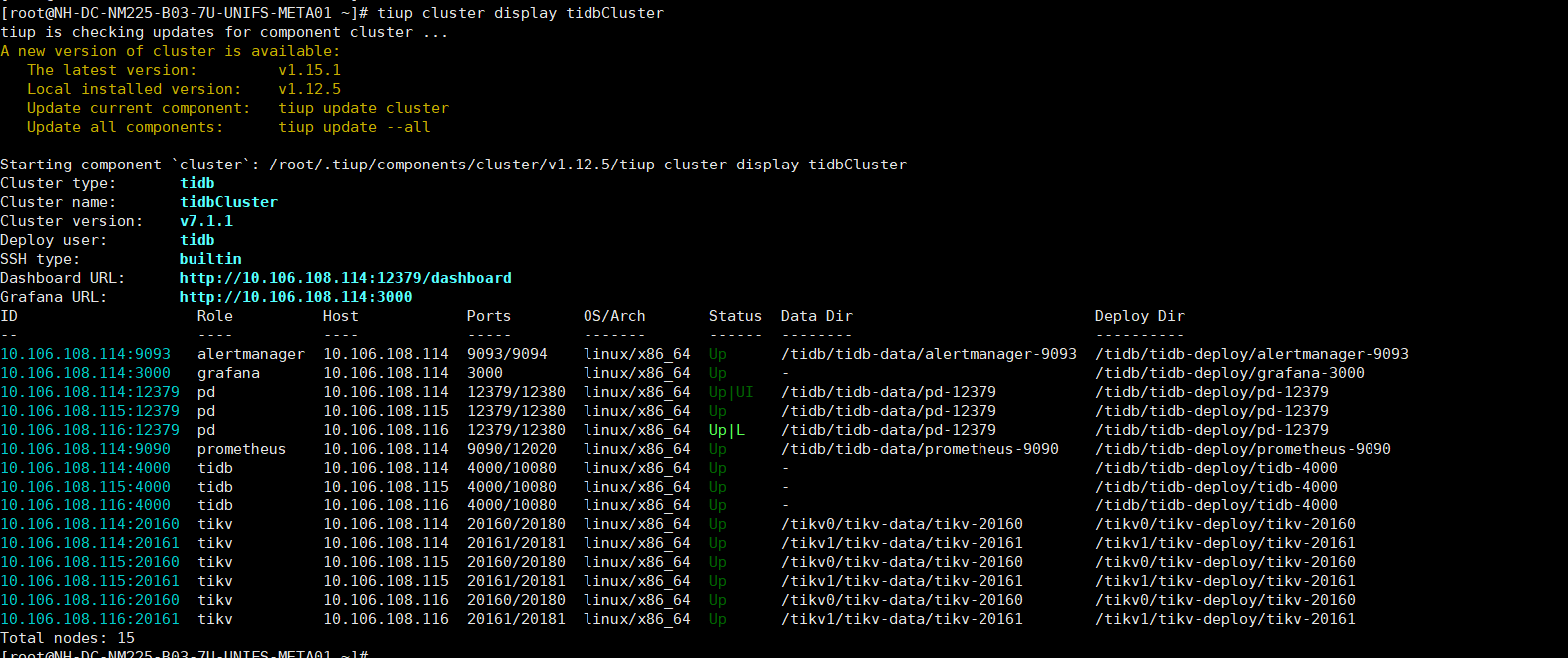

Starting component cluster: /root/.tiup/components/cluster/v1.12.5/tiup-cluster display tidbCluster

Cluster type: tidb

Cluster name: tidbCluster

Cluster version: v7.1.1

【复现路径】tikv作为juicefs的元数据库使用,然后我集成并mount之后,新建了三个文件夹,test20w,test20w2, test20w3,三个文件夹,然后分别在三个文件夹新建20w个文件,之后执行tikv的txn的scan操作,对三个文件夹下的文件进行扫描。发现最后执行新建20w文件命令的文件夹用时最久。如果之后有另外一个文件夹执行了新建大量文件的命令,那么之前的文件夹的scan命令就会正常

【遇到的问题:问题现象及影响】

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

Starting component cluster: /root/.tiup/components/cluster/v1.12.5/tiup-cluster display tidbCluster

Cluster type: tidb

Cluster name: tidbCluster

Cluster version: v7.1.1