【 TiDB 使用环境】测试

【 TiDB 版本】6.5.0 linux

【复现路径】缩容tikv节点,恢复缩容前的完全备份,恢复报错connection error

【遇到的问题:问题现象及影响】

<---------------------------…> 33.80%Full Restore <--------------------------.…> 33.80%Full Restore <--------------------------|…> 33.80%Full Restore <-----------------------------------------------------------------------------> 100.00%[2024/04/24 14:59:39.179 +08:00] [INFO] [collector.go:69] [“Full Restore failed summary”] [total-ranges=0] [ranges-succeed=0] [ranges-failed=0] [split-region=1.56078ms] [restore-ranges=73]

Error: connection error: desc = “transport: error while dialing: dial tcp 10.10.21.103:20161: connect: connection refused”

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

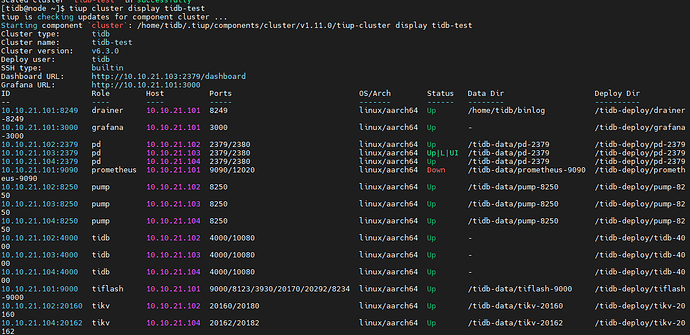

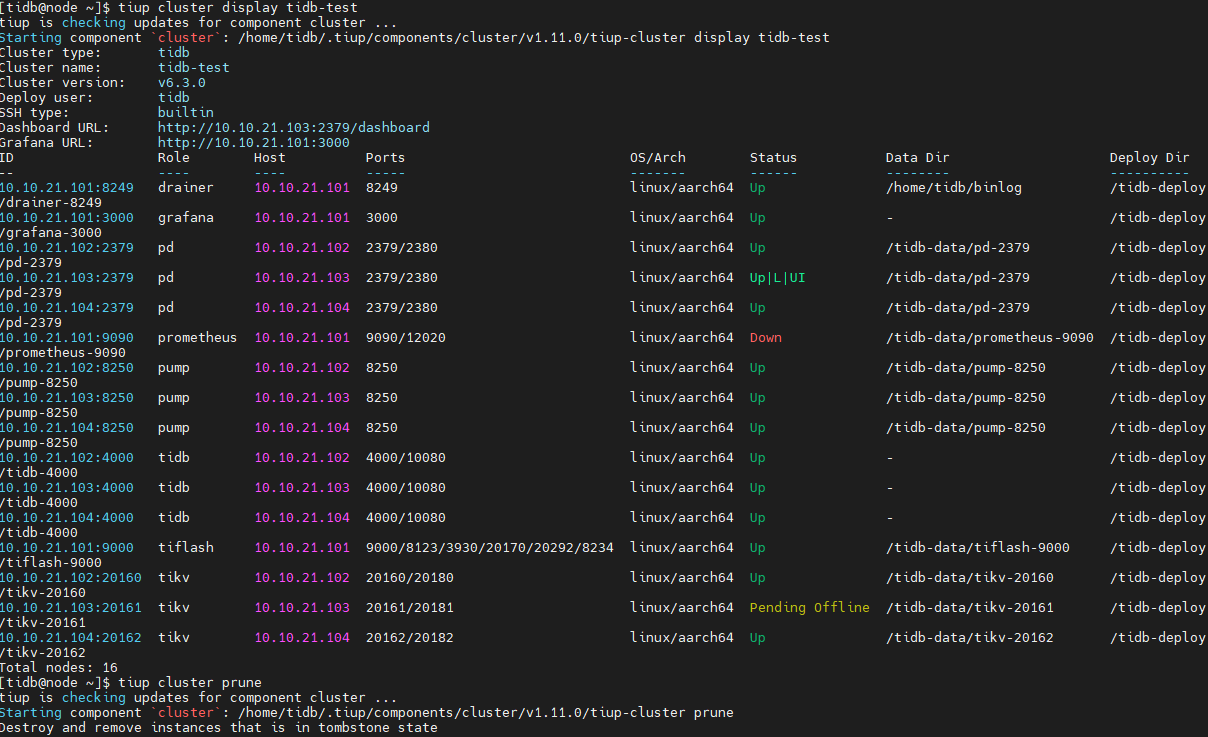

缩容后集群信息

用tiup cluster scale-in tidb-test --node 10.10.21.103:20161命令做的缩容,缩容成功后节点一直是Pending Offline状态,

后来用 --force命令才将节点彻底去掉