【 TiDB 使用环境】生产环境

【 TiDB 版本】5.7.25-TiDB-v5.2.4

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

tidb部署节点为:阿里云服务器部署的,2个tidb节点、3个kitv节点、一个tiflash。

突然间其中一个tikv节点读流量瞬间飙升300M,最近几天出现了好几次,不重启机器的话,一直维持在300M。但是我们排查没有相关业务大sql。表统计信息也都是大于80%的,请指点下排查思路。

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

这个是典型的热点读问题,可以在dashboard中的topsql查看该时间段是哪些sql消耗资源多

关键问题就是,没看到有相关问题的sql,查询都在10秒内,内存都不超过1个G。

madcoder

(Ti D Ber Wz5 Ox0w1)

4

那就直接在机器上 iotop看看 是那个进程占用高,

看看业务是不是集中到了节点,形成热点了。

要打散热点

DBAER

(66666)

8

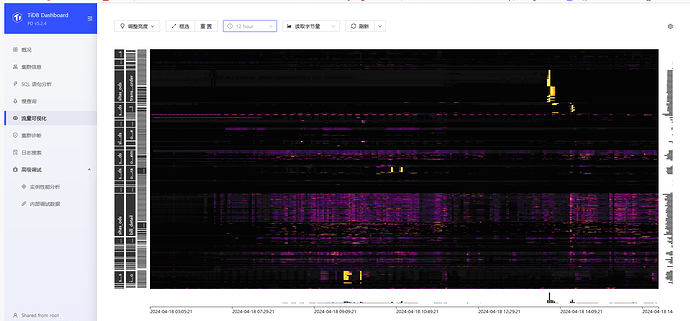

也可以看一下这个视图

select * from information_schema.TIDB_HOT_REGIONS

tikv的CPU和云盘读写BPS飙升,说明有大量的数据正在被访问,要解决问题就先弄清楚是谁来访问这些数据,所以排查

思路可以有下面几个方向:

- 先去Dashboard面板看一下topSQL、慢查询、SQL语句分析、热力图等,从整体确认下集群的运行状况。

- 在tikv节点使用资源升高期间,确认业务访问访问情况,查看QPS和延迟,确认业务访问量、访问链接数、负载等是否有变化

- tikv长时间维持高访问,如果是SQL访问的,说明一定会有慢SQL出现,可以通过Dashboard或者慢查询日志尝试寻找对于的慢SQL,然后分析之。

- 如果业务负载没有变化、也没有慢SQL,就开始重点排查下tikv的Grafana监控面板、分析是否为集群内部的调度机制触发的问题,重点分析tikv的GC运行、RocksDB Compaction 等操作。

- 排查底层云主机的基础环境问题。

楼主可以先试试这几个分析思路排查。

2 个赞

上面图,上下俩个黄色的点,应该就是最热点吧,我先看看这几个表吧

路在何chu

(Ti D Ber Ass Gn Qs R)

13

这个应该是热点表的大部分region正好在这个tikv节点,你自己可以统计一下