【 TiDB 使用环境】生产环境

【 TiDB 版本】 v6.1.1

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

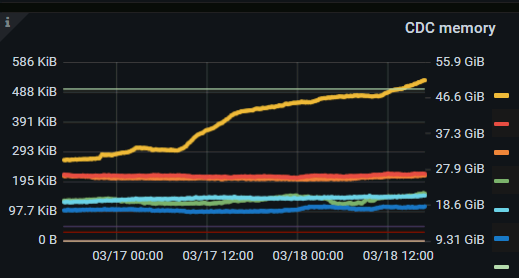

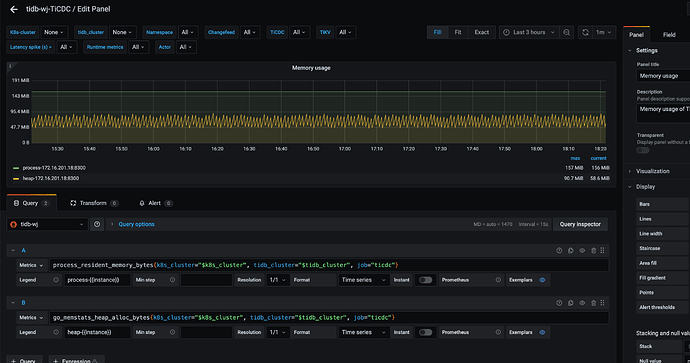

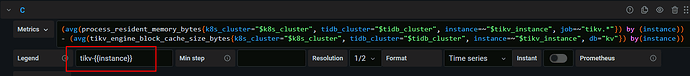

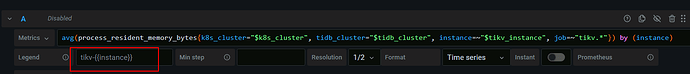

1、tikv节点使用的内存持续增加,参照 文档( TiKV主要内存结构和OOM排查总结 - TiDB 社区技术月刊 | TiDB Books )进行排查,发现是 Tikv的CDC memory占用了50GB内存,且持续增长

内存相关配置:

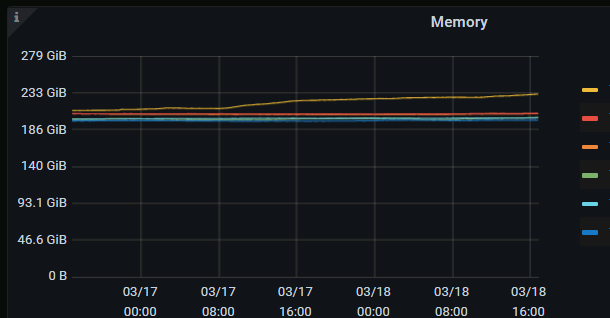

服务器内存:256.9 GiB

storage.block-cache.capacity :180GiB

cdc.sink-memory-quota: 512MB

2、当前集群无cdc任务,因此缩容了cdc节点 ,但cdc memory这一部分的内容仍未释放,且还在持续增长

请问:

1、缩容cdc节点后,内存仍然持续增长,该怎么释放内存

2、为什么只是安装了cdc组件,但是并没有创建ticdc任务,内存还是会持续增长

3、cdc.sink-memory-quota: 512MB 该配置似乎没有生效

【资源配置】

服务器内存:

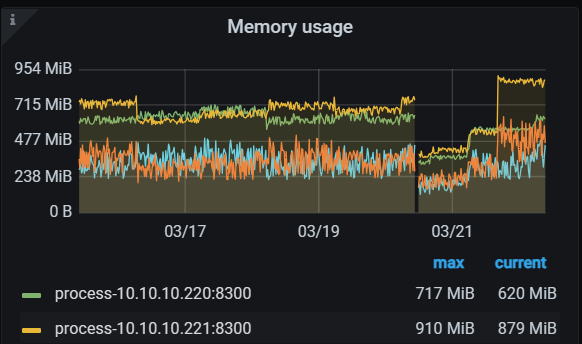

cdc memory 内存趋势: