【 TiDB 使用环境】测试

【 TiDB 版本】7.5.0 operator 1.5.0

【复现路径】 将 TiDB 迁移至 Kubernetes | PingCAP 文档中心 按照这篇文档已完成前置条件

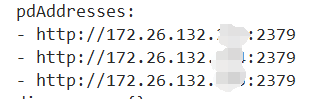

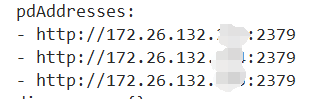

【遇到的问题:问题现象及影响】配置pdAddresses没有用,依旧在本地配置pd,也没有远程连上pd

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

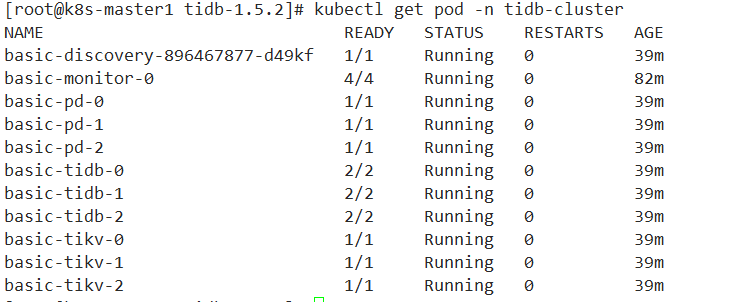

【附件:截图/日志/监控】

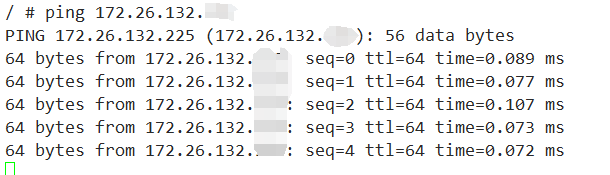

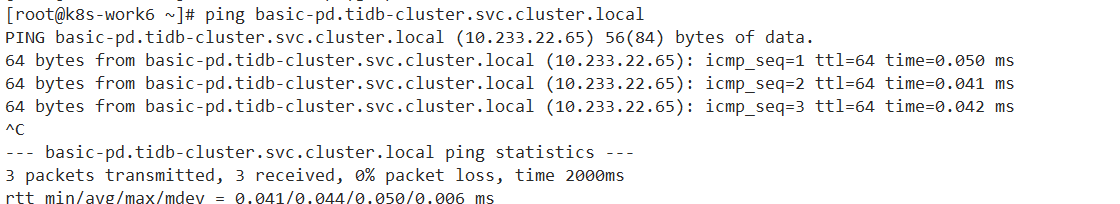

tidb集群可以解析pod网络

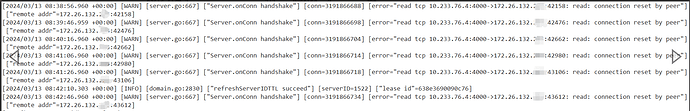

发现的报错

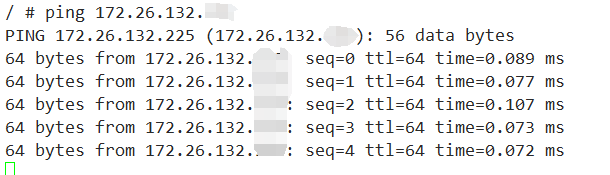

进入tidb容器能ping通

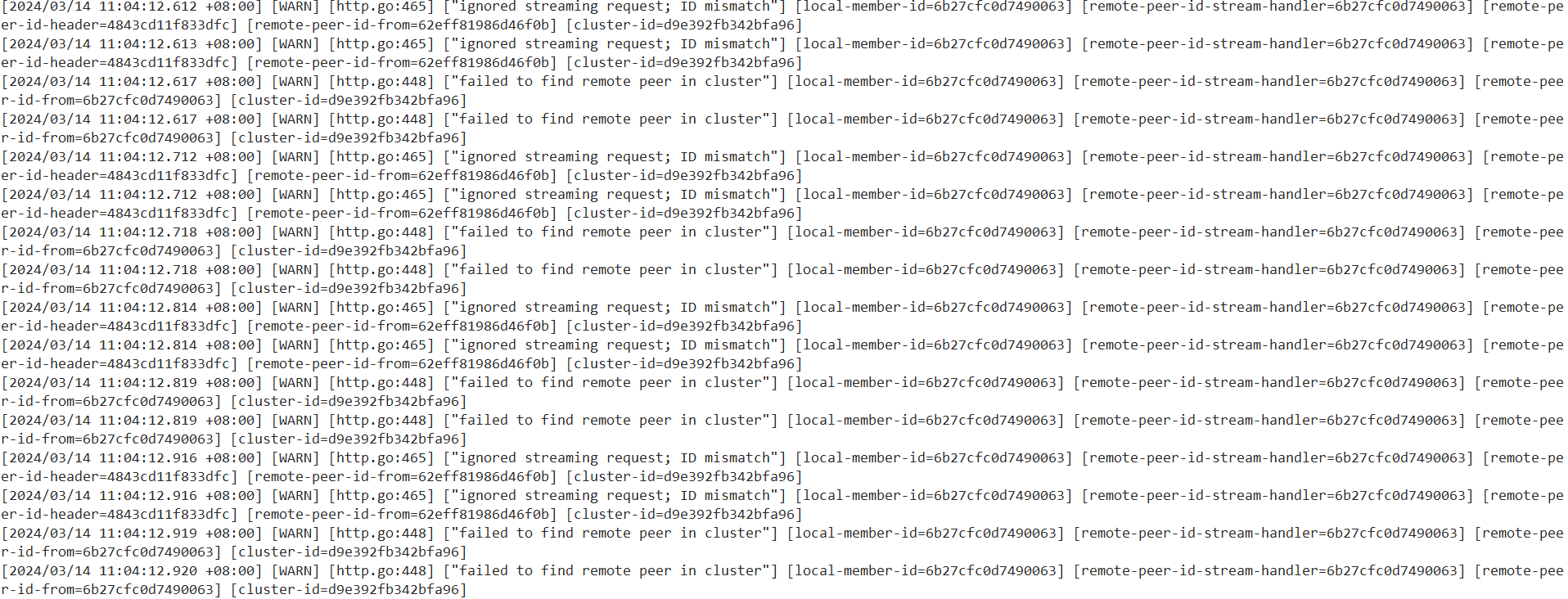

k8s上pd-1节点日志

你的问题我没太理解,但是那个文档我看着还行啊,就是相当于扩容了一些节点在k8s中,然后缩容tiup里面的节点,数据自然就流到了k8s中了。

是这样的没错,但是我在进行配置之后,依旧是两个独立的集群,并没有合并成一个集群

首先保证所有的pod和tiup部署的网络是通的。

然后按介绍操作后,通过

pd-ctl member应该能看到6个pd节点。k8s 3个,tiup3个

这一步对了就可以切换pd的leader到k8s中的。

看store,应该也有2个集群的store,再一个一个的下线tiup中的就行了。

你现在是哪个环节不对?

进入到pd的pod,ps看看,看看pd的启动命令。

并且看下pd的配置文件。

有没有tiup的节点ip

报错 connection reset by peer 说明这个连接是没被正常关闭的,这时 tidb 尝试正常从 client 读请求的时候发现连接已经被对方关了。

要么忽略无视,要么检查外部链接和网络。

redgame

(Ti D Ber Pa Amoi Ul)

14

我们是导入导出,但是反着来的,k8s这种,哎。。。

米有啊,无用pd-ctl查看store还是只有三个

主要是看看k8s里面,pd-server的启动命令里有没有带上参数 -join

如果没带上,那就是k8s的pdAddress配置没生效,就从这边排查,如果带上了,就再从别的地方排查。