这里还得看服务器型号,CPU单元个数,我看社区写的配置其实numa_node除了0就是1 ![]()

我们买的是双2cpu的Intel 6448H处理器,单个cpu就不用考虑配置numa了

建议关闭了

需要实际测试一下,还得看CPU,尤其是国产地

numa主要单台机器多实例限制资源的,压性能还是建议不要混部

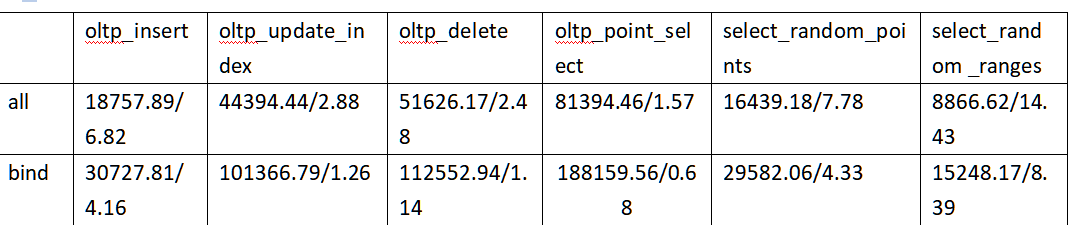

需要绑核的,

首先看你的服务器是不是双路及以上的并且BIOS中开启了numa设置。如果不是,就可以忽略NUMA这个问题了;

如果是,那一定要将要运行的程序CPU 和 内存的绑定确定在同一个numa节点内,保证CPU能够访问离他最近的内存。之前我测试过,跨numa访问和同一个numa节点内访问相比,跨numa访问的延时基本是numa内访问的两倍(intel 6230 CPU时代)达到200+ns;

另外,还有一点要特别注意,从我参加工作开始,在db场景的服务器都会禁用numa;为什么明明numa会降低内存延时,但实际使用要禁用呢。是因为早些年,CPU 核心数和内存都不够大,单独使用某一个numa node 会出现内存不够进而OOM 或跨numa节点访问,带来严重的性能表现不稳定。但是现在CPU核心数和内存容量大幅增加,intel NVME 7T 都是很正常的事情了,在一台机器上跑多个数据库实例就很常见了,这种时候开启NUMA 就会有非常好的性能优势。

比如在一台两路配置的服务器上安装了2块NVME 的机器上,每个tikv 使用一块NVME,总计跑两个TiKV实例,就非常适合开启NUMA,每个tikv 占一个NUMA节点了。

期待一下