【 TiDB 使用环境】测试

【 TiDB 版本】6.5.0

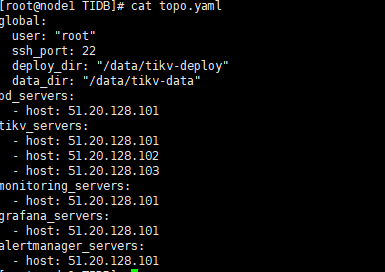

【复现路径】./go-ycsb run tikv -P workloads/workloadc -p tikv.pd=“51.20.128.101:2379” -p tikv.type=“raw” -p recordcount=1000000 -p operationcount=10000000 -p threadcount=200

【遇到的问题:问题现象及影响】

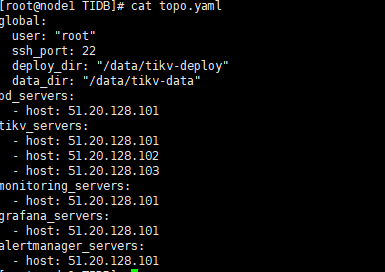

【资源配置】裸机1PD3TIKV集群

【附件:截图/日志/监控】

网络 25GE 磁盘nvme 基本不可能达到瓶颈

应该如何调整使得CPU占用率升高

当前现象是调整readpool.unified.max-thread-count 设置为 10 可以性能提高 但是CPU占用率还是低

dba远航

(Ti D Ber M Lo7 Bqhk)

2

CPU使用率不高是好现象,为什么非让它升高?增加并发是可以升高的

压测是测试集群极限和弱点,cpu、内存、网络、磁盘读写都有可能造成性能瓶颈

小龙虾爱大龙虾

(Minghao Ren)

6

你有多少颗CPU呢,看下TiKV面板的cpu线程池监控,有没有满的

目前来看就是增加并发量(尝试增加线程数) 依旧是上不去,当前想把压力拉满上去看看性能指标

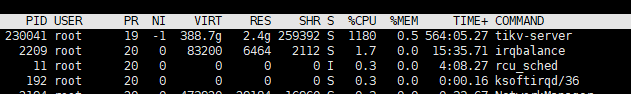

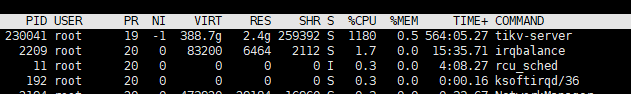

两颗cpu共96核数 所以这点CPU占用远远不够压测

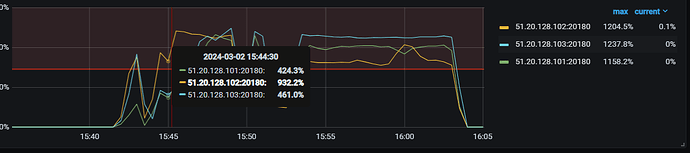

无法上传图片呢,看起来就是Unified read pool 峰值能在1300% 调整readpool.unified.max-thread-count 设置为 10 后 峰值稳定在700左右,性能上升3倍,但是CPU占用率依旧在整体的20%

changpeng75

(Ti D Ber Aw K Xsgx O)

13

那铁定吃不满的,单块NVME这个数据量,TiKV节点的基础功能消耗的CPU有限,除非是做计算下推。

96核心的 TiKV节点的基础功能消耗的CPU有限具体指的是哪些基础功能呢,瓶颈在哪个模块处理。这个IOPS 离NVME单盘8K读写的理论IOPS还差的很多吧

changpeng75

(Ti D Ber Aw K Xsgx O)

18

TiKV是MemTable转储落盘,所以是顺序写而非随机写,要看MBPS而非IOPS。其实要看瓶颈是不是在硬盘很简单,上两块硬盘,看看CPU占用有没有提升就可以了。

1 个赞