【 TiDB 使用环境】生产环境

【 TiDB 版本】 7.5

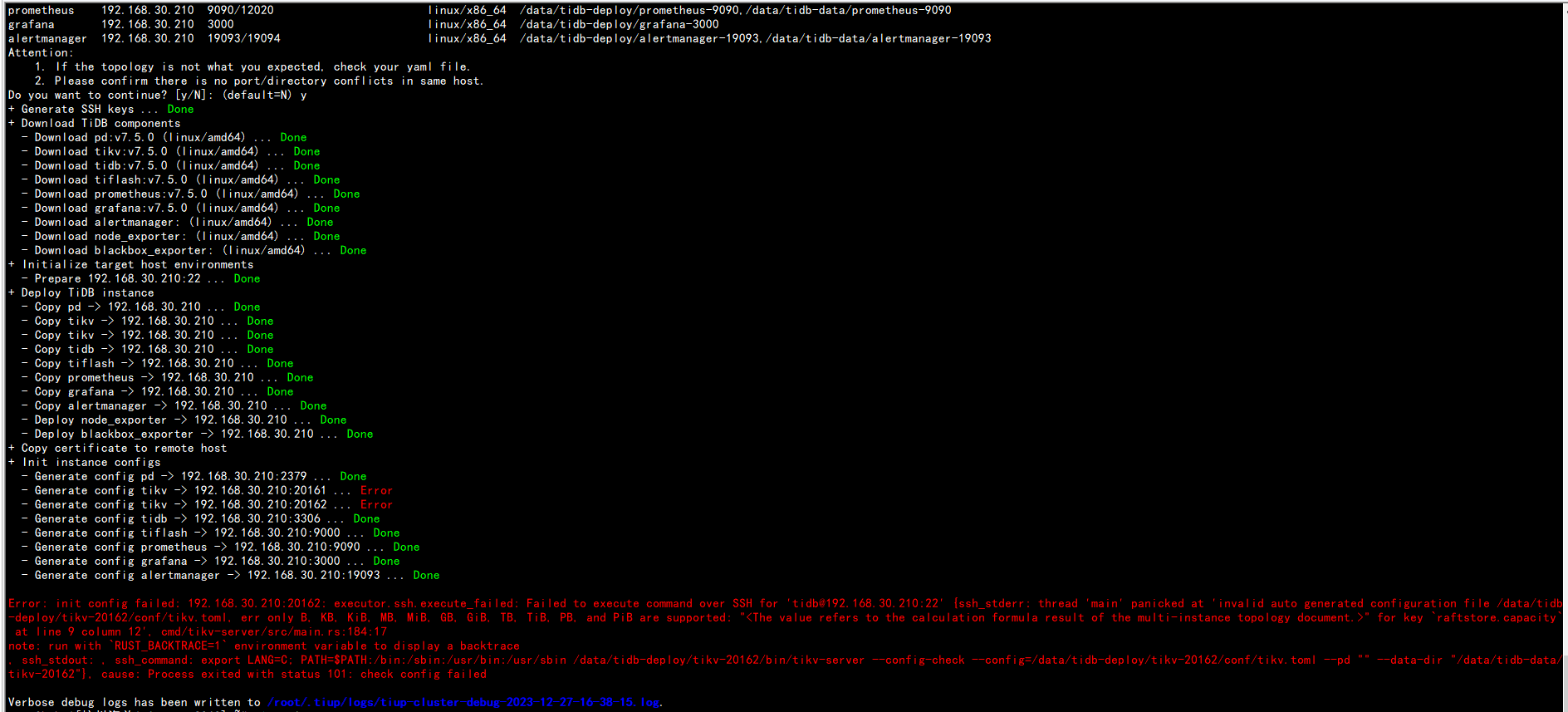

【复现路径】安装tiup,配置topology.yaml, 执行部署命令tiup cluster deploy tidb v7.5.0 ./topology.yaml --user root

topology.yaml:

# Global variables are applied to all deployments and used as the default value of

# the deployments if a specific deployment value is missing.

global:

user: “tidb”

ssh_port: 22

deploy_dir: “/data/tidb-deploy”

data_dir: “/data/tidb-data”

server_configs:

tikv:

readpool.unified.max-thread-count:

readpool.storage.use-unified-pool: false

readpool.coprocessor.use-unified-pool: true

storage.block-cache.capacity: “”

raftstore.capacity: “”

pd:

replication.location-labels: [“host”]

pd_servers:

- host: 192.168.30.210

tidb_servers:

- host: 192.168.30.210

port: 3306

status_port: 10081

numa_node: “0”

tikv_servers:

- host: 192.168.30.210

port: 20161

status_port: 20181

numa_node: “0”

config:

server.labels: { host: “192.168.30.210”} - host: 192.168.30.210

port: 20162

status_port: 20182

numa_node: “1”

config:

server.labels: { host: “192.168.30.210”}

tiflash_servers:

- host: 192.168.30.210

data_dir: /data/tidb-data/tiflash-9000

deploy_dir: /data/tidb-deploy/tiflash-9000

monitoring_servers:

- host: 192.168.30.210

grafana_servers:

- host: 192.168.30.210

alertmanager_servers:

- host: 192.168.30.210

web_port: 19093

cluster_port: 19094

【资源配置】未安装成功