月明星稀

2023 年12 月 25 日 05:59

1

Still waitting for 47 store leaders to transfer...

Still waitting for 39 store leaders to transfer...

Still waitting for 39 store leaders to transfer...

Still waitting for 39 store leaders to transfer...

Still waitting for 39 store leaders to transfer...

Restarting instance 1.1.1.1.58:2000

Error: failed to restart: 1.1.1.1.58 tikv-2000.service, please check the instance’s log(/usr/local/server/tikv-2000/log) for more detail.: timed out waiting for port 2000 to be started after 2m0s

[2023/12/25 13:55:21.904 +08:00] [INFO] [apply.rs:2204] [“exec ConfChangeV2”] [epoch=“conf_ver: 12982 version: 17”] [kind=Simple] [peer_id=9895] [region_id=9888]

reload失败,但看日志最终应该是成功的,会是什么原因呢

Kongdom

2023 年12 月 25 日 06:06

2

display 看一下集群状态呢?

日志是 /usr/local/server/tikv-2000/log 的日志么?

1 个赞

月明星稀

2023 年12 月 25 日 06:08

3

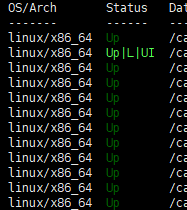

是的/usr/local/server/tikv-2000/log/tikv.log,集群状态都是up

zhanggame1

2023 年12 月 25 日 06:09

6

redload应该成功了,只是提示你驱逐leader没完全做完

Kongdom

2023 年12 月 25 日 06:09

7

那就没有问题,我遇到过这种情况,就是启动特别慢,超过了超时时间没有启动成功,前端会报错超时,但后台还是在继续启动的,只要最终集群状态是up就没问题。

1 个赞

月明星稀

2023 年12 月 25 日 06:26

9

遇到这台机器,重试的几次,都是比较慢导致失败,应该怎么看到底是什么原因慢

可以指定 --transfer-timeout 为一个更大的值,或者–force

月明星稀

2023 年12 月 25 日 06:45

11

Error: failed to get leader count 1.1.1.40: metric tikv_raftstore_region_count{type=“leader”} not found

月明星稀

2023 年12 月 25 日 07:29

13

集群内如果有一台机器宕机之类的,是不是很容易出现region leader 出问题,pd 起不来,日志如下:

[2023/12/25 14:47:12.122 +08:00] [ERROR] [client.go:172] [“region sync with leader meet error”] [error=“[PD:grpc:ErrGRPCRecv]rpc error: code = Canceled desc = context canceled: rpc error: code = Canceled desc = context canceled”]

小龙虾爱大龙虾

2023 年12 月 25 日 08:00

14

驱逐leader太慢,超时了,可以加个timeout参数

Error: failed to restart: 1.1.1.1.58 tikv-2000.service,

这个就是报错的原因。确认一下对应节点的日志内容,看看有无异常信息

tidb菜鸟一只

2023 年12 月 26 日 01:01

18

Kongdom

2023 年12 月 26 日 01:32

19

这个得看几个节点几副本吧,低于半数节点宕机,只遇到过一次pd无法启动的情况。

1 个赞

dba远航

2023 年12 月 27 日 00:25

20

RELOAD超时,但结果是成功的,只是说明RELOAD期间有超时现象,但最终执行成功了