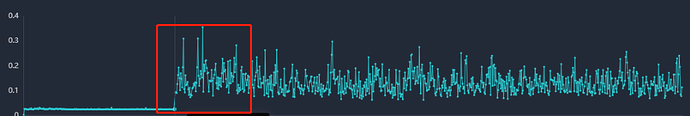

tikv运行一段时间后,读写时间突然变差,同机大概需要150ms左右,执行tikv restart后,响应时间变好,恢复到10ms左右,大神们帮忙提供一下排查思路,变差时间点开始打印一下日志。。

日志:

[2023/11/29 03:48:07.487 +08:00] [INFO] [apply.rs:1612] [“execute admin command”] [command=“cmd_type: ChangePeerV2 change_peer_v2 { changes { change_type: AddLearnerNode peer { id: 1110 store_id: 4 role: Learner } } }”] [index=505260] [term=7] [peer_id=1105] [region_id=1102]

[2023/11/29 03:48:07.487 +08:00] [INFO] [apply.rs:2204] [“exec ConfChangeV2”] [epoch=“conf_ver: 71 version: 3”] [kind=Simple] [peer_id=1105] [region_id=1102]

[2023/11/29 03:48:07.487 +08:00] [INFO] [apply.rs:2385] [“conf change successfully”] [“current region”=“id: 1102 start_key: 780000006D2F6563FF612D746573742F6DFF6F6E69746F725F67FF6C6F62616C2F3132FF302E3233322E3937FF2E3132315F737461FF7475730000000000FA end_key: 78000000732F6563FF612D746573742F6DFF6F6E69746F725F67FF6C6F62616C2F3132FF302E3233322E3937FF2E3132315F737461FF7475730000000000FA region_epoch { conf_ver: 72 version: 3 } peers { id: 1103 store_id: 5 } peers { id: 1104 store_id: 9 } peers { id: 1105 store_id: 6 } peers { id: 1110 store_id: 4 role: Learner }”] [“original region”=“id: 1102 start_key: 780000006D2F6563FF612D746573742F6DFF6F6E69746F725F67FF6C6F62616C2F3132FF302E3233322E3937FF2E3132315F737461FF7475730000000000FA end_key: 78000000732F6563FF612D746573742F6DFF6F6E69746F725F67FF6C6F62616C2F3132FF302E3233322E3937FF2E3132315F737461FF7475730000000000FA region_epoch { conf_ver: 71 version: 3 } peers { id: 1103 store_id: 5 } peers { id: 1104 store_id: 9 } peers { id: 1105 store_id: 6 }”] [changes=“[change_type: AddLearnerNode peer { id: 1110 store_id: 4 role: Learner }]”] [peer_id=1105] [region_id=1102]

[2023/11/29 03:48:07.488 +08:00] [INFO] [raft.rs:2646] [“switched to configuration”] [config=“Configuration { voters: Configuration { incoming: Configuration { voters: {1104, 1105, 1103} }, outgoing: Configuration { voters: {} } }, learners: {1110}, learners_next: {}, auto_leave: false }”] [raft_id=1105] [region_id=1102]

[2023/11/29 03:48:09.299 +08:00] [INFO] [apply.rs:1612] [“execute admin command”] [command=“cmd_type: ChangePeerV2 change_peer_v2 { changes { peer { id: 1110 store_id: 4 } } changes { change_type: AddLearnerNode peer { id: 1103 store_id: 5 role: Learner } } }”] [index=505267] [term=7] [peer_id=1105] [region_id=1102]