【 TiDB 使用环境】生产环境

【 TiDB 版本】

4013

【复现路径】做过哪些操作出现的问题

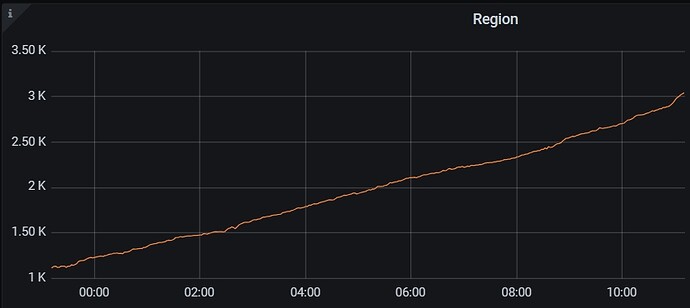

扩容节点region平衡太慢

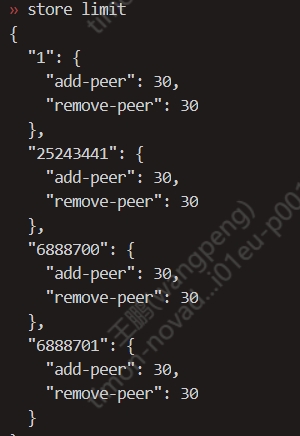

之前设置的15,现在改成了30,能不能继续调大,太大有啥风险

调的太大会对现有业务产生影响,io压力会大一点

我们这边业务都是晚上,白天没啥业务,那就是调大应该没啥事了

结合自己机器IO能力,留出足够部分业务使用,其它可以留出做平衡

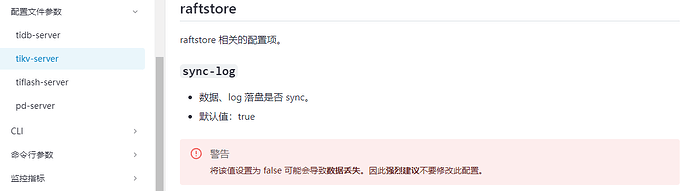

设置太大可能导致IO占用过多,影响正常写入,TiKV相应时间增加,影响前台业务,

观察IO,调整一个合适值

该参数用于限制每个Store(即TiKV实例)在存储数据时的最大容量,设置过大会可能对存储资源和写入性能会有影响

调太大也没啥用了。调到100时,io已经打满了

嗯,store limit设置和你的硬件资源有关系,不是随便设置的

之前我发的贴,参考下

根据业务,调试到一个合适值

逐步调高把,主要影响IO

Store Limit 是 PD 在 3.0 版本引入的特性,旨在能够更加细粒度地控制调度的速度,针对不同调度场景进行调优。

Store Limit 相关的参数可以通过 pd-ctl 进行设置。

https://docs.pingcap.com/zh/tidb/stable/configure-store-limit

动态调整

当 store-limit-version 设置为 v2 时,Store Limit v2 生效。在此模式下,Operator 调度限制将根据 TiKV Snapshot 执行情况进行动态调整。当 TiKV 积压的任务较少时,PD 会增加其调度任务。相反,PD 会减少对该节点的调度任务。此时,你无需关注如何设置 store limit 以加快调度进度。

在该模式下,TiKV 执行速度成为迁移进度的主要瓶颈。你可以通过 TiKV Details > Snapshot > Snapshot Speed 面板判断当前调度速度是否达到 TiKV 限流设置。通过调整 TiKV Snapshot Limit (snap-io-max-bytes-per-sec) 来增加或减少该节点的调度速度。

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。