【 TiDB 使用环境】生产环境

系统日志message里有oom:

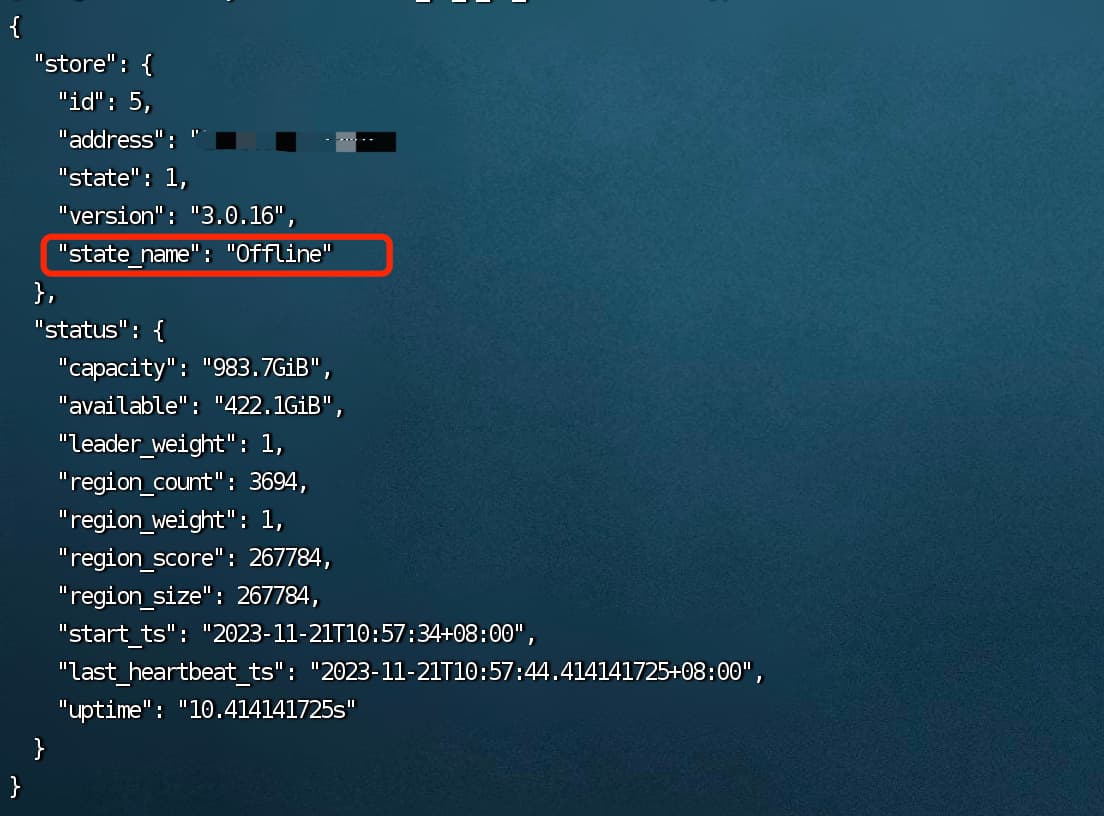

后强制下线此TiKV节点,目前状态为offline

业务日志里有java.sql.SOLException: TiKV server is busy报错

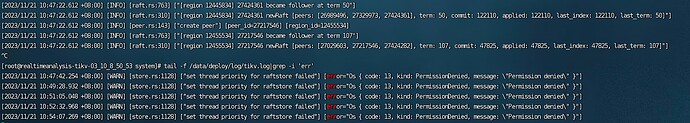

查看PD日志:

请问改如何强制下线这个tikv,或怎么修复这个集群(除了升级)

PD里不是说了嘛,没有足够空间去把下线节点的副本复制到其他节点,结合你的OOM,k

–force 可以强制清除这种不可通信的节点

随缘天空

2023 年11 月 21 日 05:59

8

错误信息显示可能是由于磁盘空间不足或节点配置不合理导致的。你打开dashboard监控面板,看下各节点磁盘空间的剩余情况

这是3版本 没有dashboard 我看磁盘了是够的

你这个TiKV节点的Capacity size总容量是983GB,

那你其他的三个节点要消化掉这561GB数据吧

Grafana上看下TIKV的面板吧 Cluster和Errors面板有啥异常没

tidb菜鸟一只

2023 年11 月 21 日 07:16

18

那你或者扩容当前的3个活着的tikv节点的磁盘空间,或者扩容一个tikv节点,不然你坏掉的这个tikv上的region没有地方迁移,没法下线

Kongdom

2023 年11 月 21 日 07:31

20

如果集群还是正常状态,这个offline的tikv节点是不是可以强制缩容?不过3.0的文档中没有关于强制缩容的方案,不知道直接执行步骤3是否可以。

访问 TiDB 数据库的归档文档。

不过,看报错信息,应该是在迁移数据,最好还是不要强制缩容了,先扩硬盘空间,看看能不能正常缩容下线吧。

store may not turn into Tombstone, there are no extra up node has enough space to accommodate the extra replica