那之前没啥业务流量还 5M/s,可能是什么操作呢

会不会是REGION在重新平衡?

确认一下集群是否有热点问题,确认数据调度情况,在pd的面板可以看

https://asktug.com/uploads/default/original/4X/3/d/e/3de06789f1983b378d6bb7c2b0f441ce6d0276c5.jpeg 监控中 region 的调度蛮小的,没看出啥异常,大佬能看出啥吗

我也是猜测存在这种可能性,具体是有命令可以查看的,是哪个命令有些忘记了,学习视频上有

dmall_rdp_voucher-PD - Grafana (2023_11_17 10_30_55).html (2.8 MB)

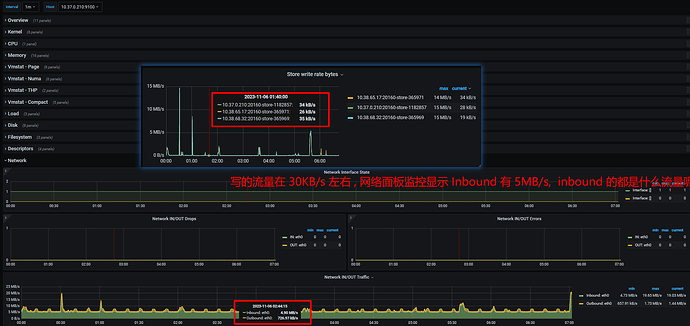

pd 面板监控下载下来了,重要的指标都有,看【 hot write】【Store Write rate bytes】 6 点前写入量基本在 30kB/s 左右,但网络监控那块有 5M/s 的 input 流量,差距太大了

是 raft 心跳的流量吧

有可能是region在调度

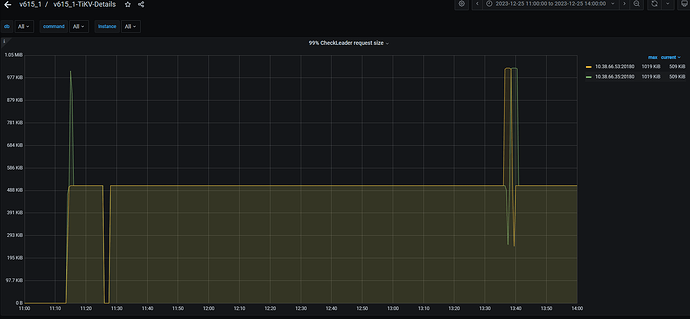

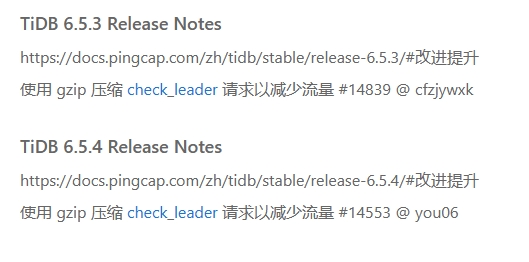

大佬们,终于定位到原因了,是 check leader 的流量,6.5.3 之前版本在网络传输前没有压缩,6.5.3 之后修复了。升级到 6.5.6 效果非常明显。还有一点就是静默 region 这个功能对流量的影响也非常大。

2 个赞

有始有终,特别棒。 ![]()

是咋定位分析到的

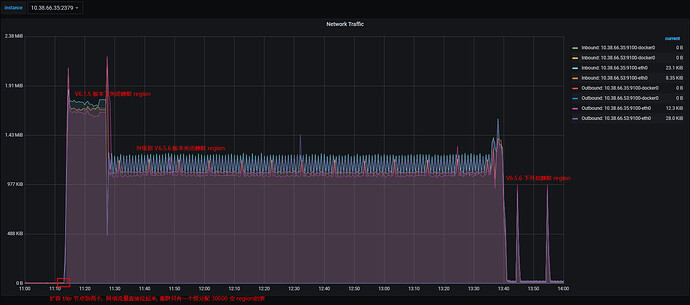

笨办法,复现这个问题

- 新建一个单 tikv 节点的集群,流量没异常

- 建一个 30000 的空 region 表,流量还没异常

- 扩容到两个 tikv 节点,流量异常了

- 逐个过监控项,看 3 的时间点哪个监控项有异常,就看到tikvDetail-ResolvedTs 面板比较吻合(同事给力)

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。