老司机1024

(.1024老司机)

1

【 TiDB 使用环境】生产环境

【 TiDB 版本】主集群v6.1.1, 从集群v7.1.2

【复现路径】

【遇到的问题:问题现象及影响】

- 将v6.1.1集群通过br命令全量导出/导入至v7.1.1集群中, 并创建ticdc任务, 新建任务过程中, 忽略无主键表, 任务运行状态为normal, 并无报错信息

- 观察业务表, 增量同步相当缓慢, 卡在一个时间点半小时或几十分钟

- 使用br v6.1.1导出全量数据, 使用br v7.1.2导入全量数据至从集群中, 创建增量任务使用ticdc/cdc v6.1.1, 查看当前同步时间的业务表并未在ticdc创建任务时忽略

- br开始全量导出前, 关闭GC, 创建增量任务后也未打开GC, cdc时间戳使用br备份完成后回显的backupts

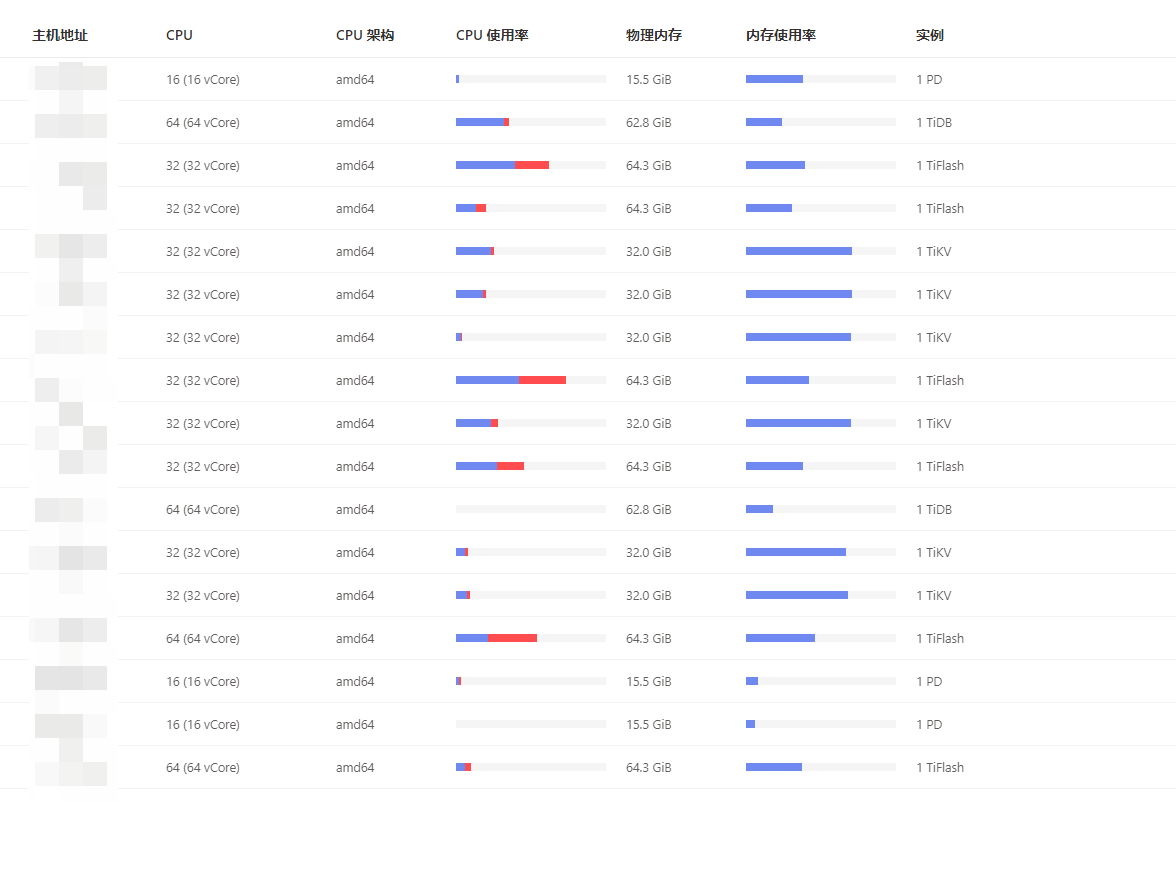

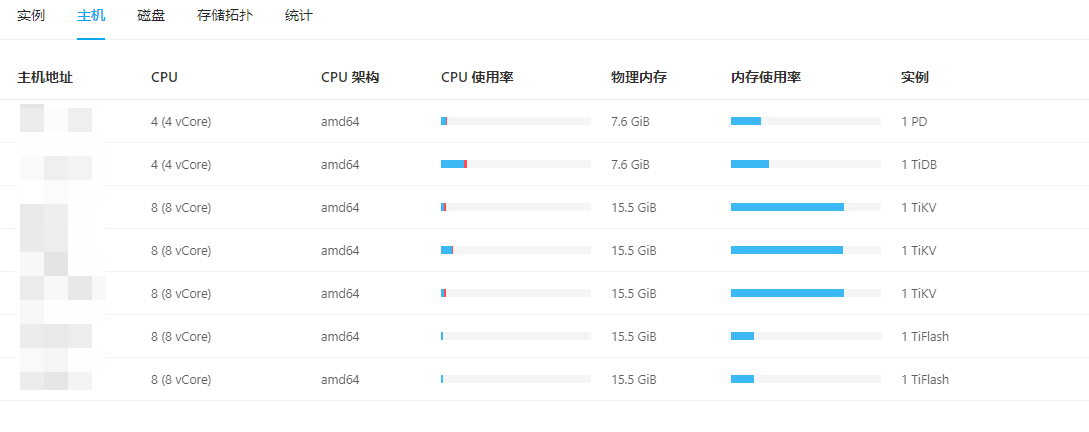

【资源配置】

【附件:截图/日志/监控】

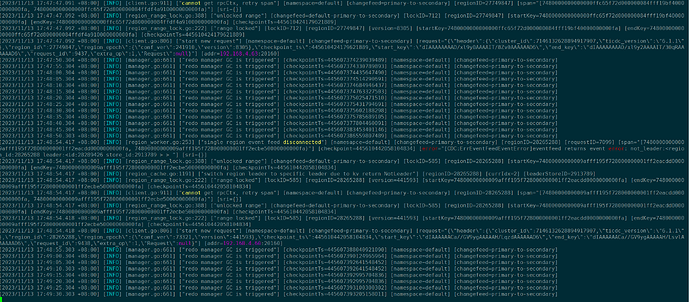

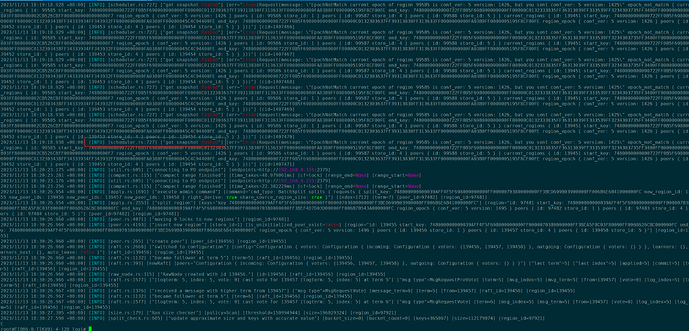

ticdc日志截图:

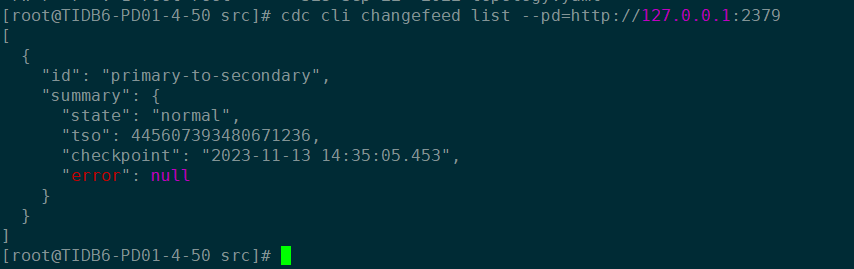

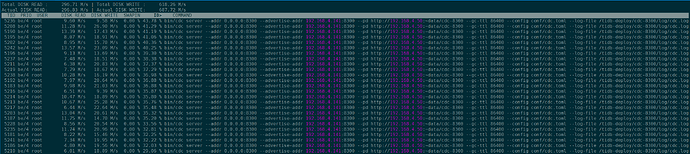

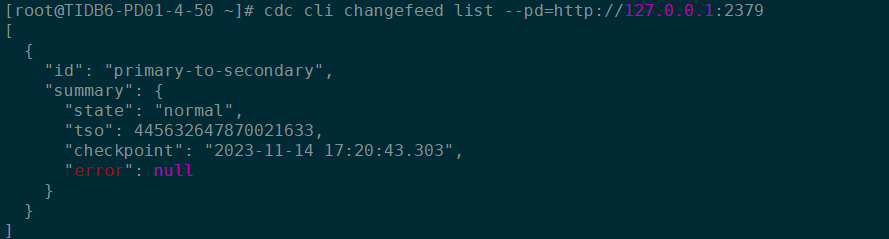

ticdc任务状态截图:

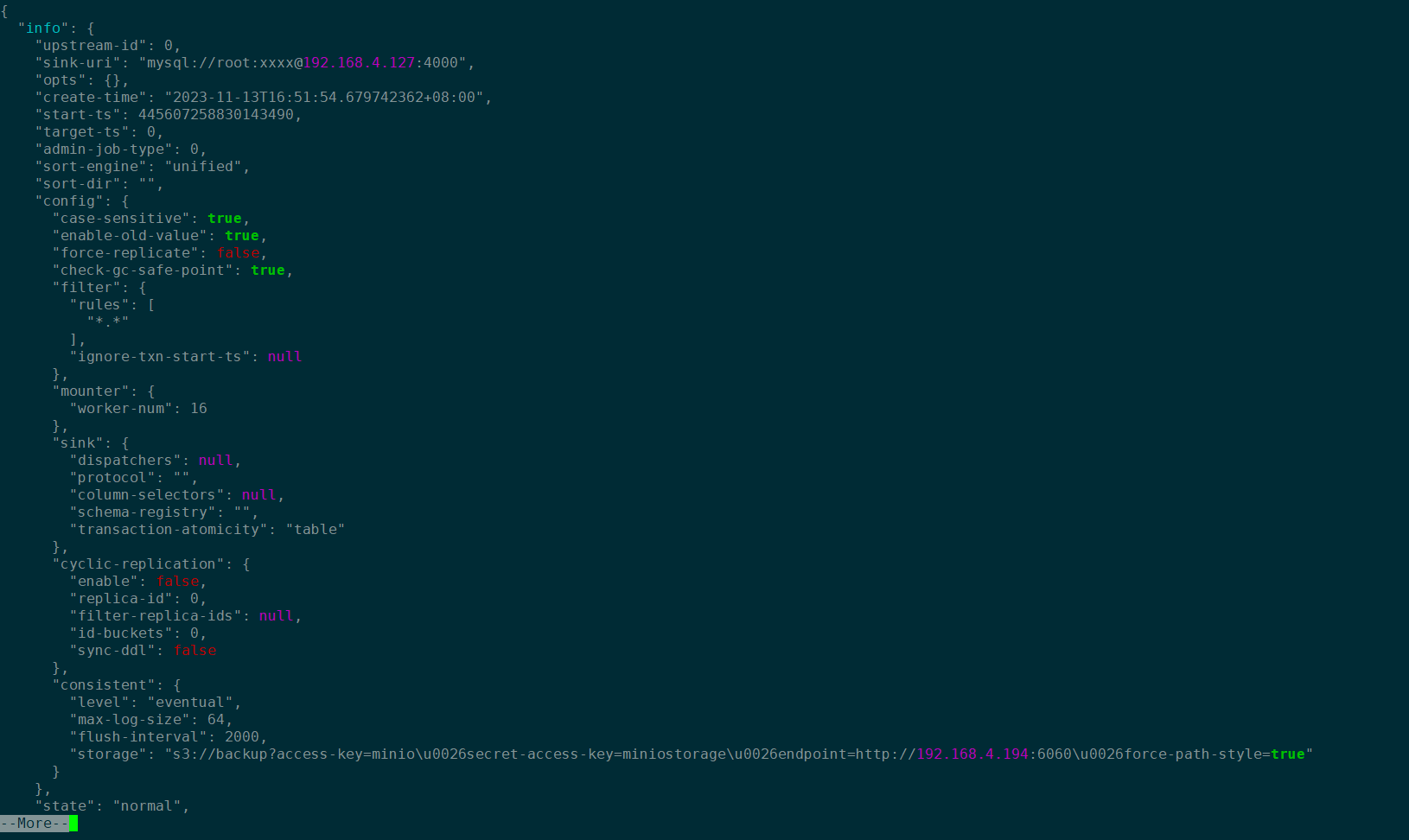

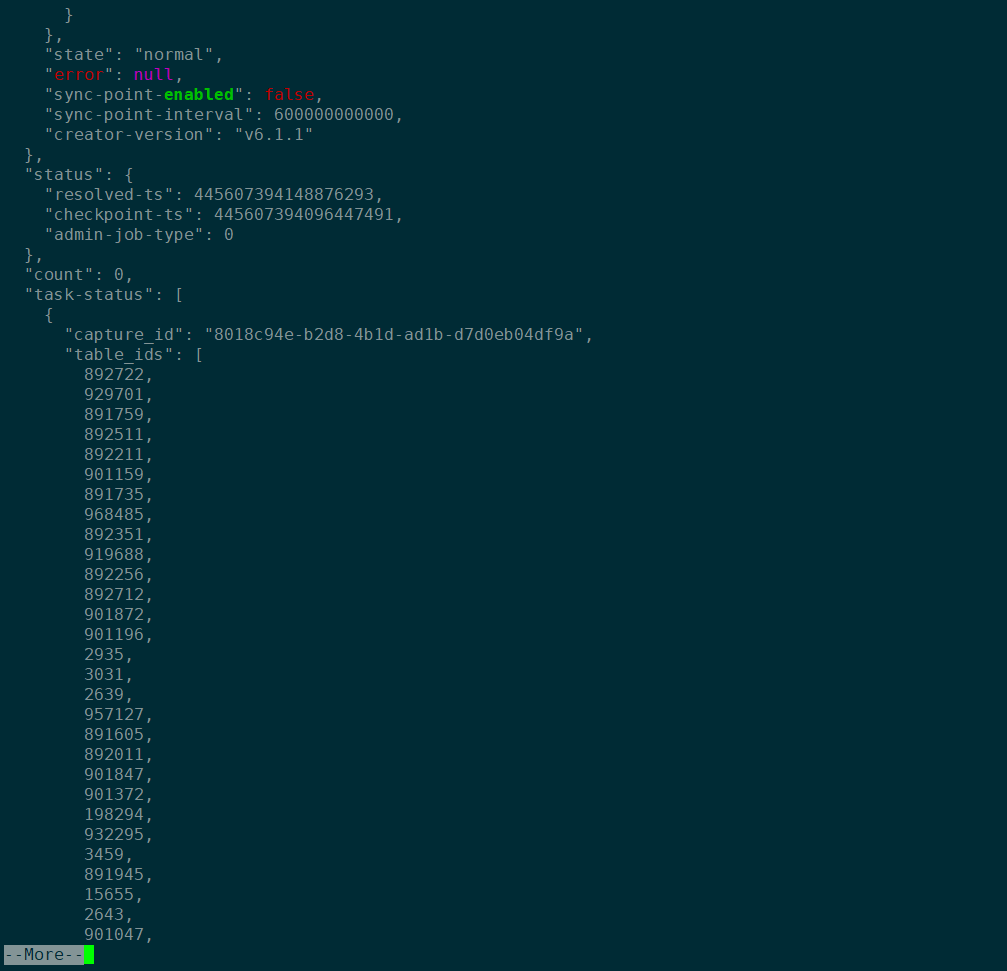

ticdc任务详情截图:

老司机1024

(.1024老司机)

2

是否是因为我导入导出的时候使用br, ticdc同步的表对br不支持/不兼容导致的卡顿

使用mysql命令行重新导入/导出?

Br恢复的数据肯定不能通过cdc同步的,但是br之后恢复的数据再新增数据时支持cdc的,也不会因为时br过来的数据就导致cdc卡顿,你可以看看你的上下游资源利用率,看看是否有异常

老司机1024

(.1024老司机)

6

上游是TiDB v6.1.1 下游是TiDB v7.1.2

老司机1024

(.1024老司机)

7

刚才检查了下上下游集群, 看到ticdc满载, 已经增加配置, 稍后我再观察下

使用 TiCDC 在两个 TiDB 集群间同步数据时,如果上下游的延迟超过 100 ms:

- 对于 v6.5.2 之前的版本,推荐将 TiCDC 部署在下游 TiDB 集群所在的区域 (IDC, region)

- 经过优化后,对于 v6.5.2 及之后的版本,推荐将 TiCDC 部署在上游集群所在的区域 (IDC, region)

老司机1024

(.1024老司机)

9

感谢回复, 我们目前的场景是将主集群6.1.1升级至7.1.2, 为了保证业务不中断, 先用br+ticdc同步出来新版本集群, 后找特定时间进行割接

老司机1024

(.1024老司机)

10

两套集群都在同一个内网中, 并未跨az和region

老司机1024

(.1024老司机)

11

昨天增加了TiCDC的节点配置, 当前是16C32G, 硬盘为SSD, 能看到TiCDC的磁盘一直在写入数据, 但是下游集群仍然同步缓慢, 请教各位能否给予其他排查思路, 感谢

andone

(Ti D Ber Lq Q Mt Rp V)

14