【 TiDB 使用环境】生产环境

【 TiDB 版本】V6.1.7

【遇到的问题:问题现象及影响】 TIKV损坏了一个节点后,新注册了一个新节点,这个过程会涉及到REGION数据的问题,是否从视图或者调用PD接口能拿到当前灰度的进度信息【百分比】,和当前的恢复速度【MB】

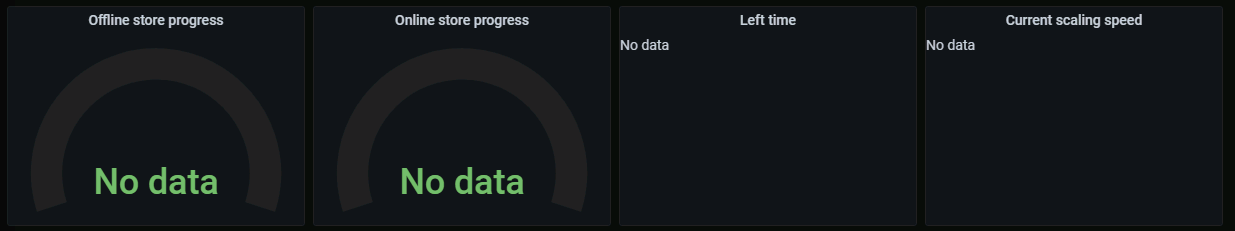

Grafana里面,TiKV面板下面有region和leader的监控,这两张图可以估算region迁移的进度。

恢复速度可以参考PD面板下的operator监控

1 个赞

如果tikv硬盘一样大,最终会三个tikv regions和leader差不多一样多 ,速度不好估计

没有确切的数据,可以根据磁盘大小估算

grafana里面看下leader和region的均衡程度就行,leader均衡了已经不影响应用,region均衡了可用度恢复了就

1 个赞

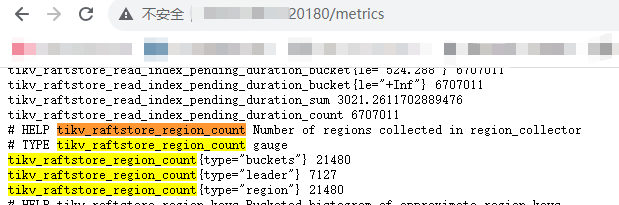

TiKV-Details监控中我看有个REGION个数监控,计算公式是:sum(tikv_raftstore_region_count{k8s_cluster=“$k8s_cluster”, tidb_cluster=“$tidb_cluster”, instance=~“$instance”, type=“region”}) by (instance), tikv_raftstore_region_count这个监控项从哪里获取的呢

1 个赞

METRICS_SCHEMA库中:select * from tikv_region_count where type=‘leader’ and instance=‘10.xxxx’;通过这种方式计算就能知道灰度进度了吧

从 Prometheus的targets里面找tikv的targets,按地址访问一下,一搜索就有了。

如果这些你都没装就开始整合,难度太大了。

看来tikv_raftstore_region_count的数据既能从metrics中获取,也能从tikv_region_count中获取 ![]()