在路上123

2023 年10 月 16 日 01:14

1

一、问题错误描述

tiup is checking updates for component tidb-lightning ...

Starting component `tidb-lightning`: /home/tidb/.tiup/components/tidb-lightning/v7.1.1/tidb-lightning -config tidb-lightning.toml

Verbose debug logs will be written to tidb-lightning.log

tidb lightning encountered error: cannot read schema 'prod_dw_sjzt' from remote: Get "http://xxxxxxxx:10080/schema/prod_dw_sjzt": dial tcp xxxxxxxx:10080: connect: connection refused

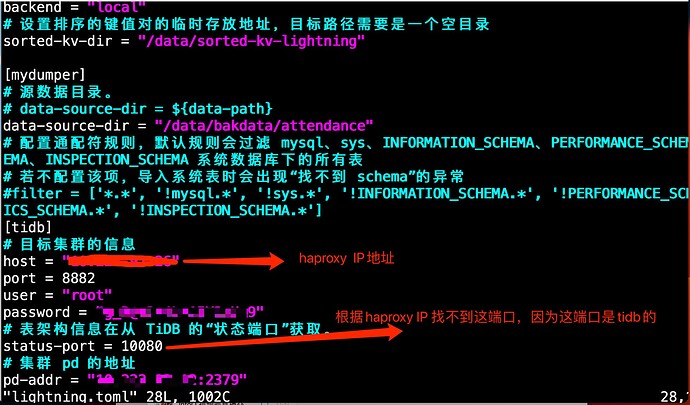

2、tidb-lightning.toml配置如下

二、原因

三、问题

连接被拒绝:错误信息中的 “connection refused” 表示连接被拒绝。

10080端口通吗? haproxy有没有代理tidb的10080端口?

解决:

检查连接配置:提供的连接地址和端口是正确的,可以用 telnet 来测试连接目标地址和端口是否可达。

检查网络连接:网络连接稳定,并且没有任何防火墙或网络配置问题。

检查目标服务器状态。

可以逐级排查,先直连看下,然后在连接haproxy

使用 PROXY 协议时,需要在 tidb-server 的配置文件中设置 [proxy-protocol.networks]

zhanggame1

2023 年10 月 16 日 01:40

8

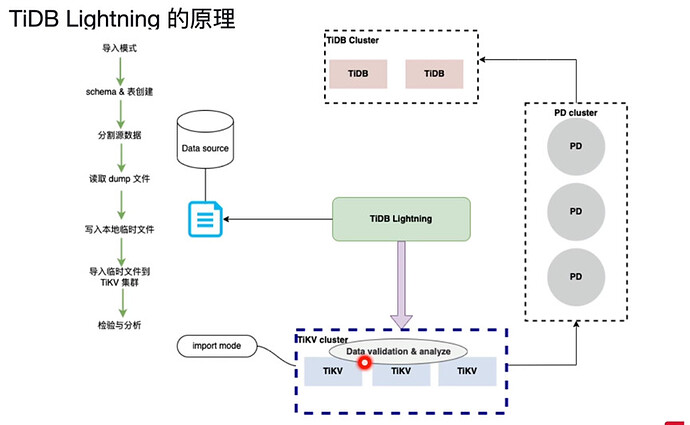

从lighting原理图来说,导入要访问tidb pd 和tikv三个组件 ,haproxy显然都没代理了

1 个赞

有猫万事足

2023 年10 月 18 日 07:32

11

再开一个haproxy实例,把10080端口代理过来就好了。

把原本的文件复制一个。配置文件命名为haproxy10080.cnf

里面内容如下:

global # 全局配置。

log 127.0.0.1 local2 # 定义全局的 syslog 服务器,最多可以定义两个。

chroot /var/lib/haproxy # 更改当前目录并为启动进程设置超级用户权限,从而提高安全性。

pidfile /var/run/haproxy.pid # 将 HAProxy 进程的 PID 写入 pidfile。

maxconn 4096 # 单个 HAProxy 进程可接受的最大并发连接数,等价于命令行参数 "-n"。

nbthread 8 # 最大线程数。线程数的上限与 CPU 数量相同。

user haproxy # 同 UID 参数。

group haproxy # 同 GID 参数,建议使用专用用户组。

daemon # 让 HAProxy 以守护进程的方式工作于后台,等同于命令行参数“-D”的功能。当然,也可以在命令行中用“-db”参数将其禁用。

stats socket /var/lib/haproxy/stats # 统计信息保存位置。

defaults # 默认配置。

log global # 日志继承全局配置段的设置。

retries 2 # 向上游服务器尝试连接的最大次数,超过此值便认为后端服务器不可用。

timeout connect 2s # HAProxy 与后端服务器连接超时时间。如果在同一个局域网内,可设置成较短的时间。

timeout client 30000s # 客户端与 HAProxy 连接后,数据传输完毕,即非活动连接的超时时间。

timeout server 30000s # 服务器端非活动连接的超时时间。

listen admin_stats # frontend 和 backend 的组合体,此监控组的名称可按需进行自定义。

bind 0.0.0.0:8001 # 监听端口。(这里要改和另一个实例的管理端口分开)

mode http # 监控运行的模式,此处为 `http` 模式。

option httplog # 开始启用记录 HTTP 请求的日志功能。

maxconn 10 # 最大并发连接数。

stats refresh 30s # 每隔 30 秒自动刷新监控页面。

stats uri /haproxy # 监控页面的 URL。

stats realm HAProxy # 监控页面的提示信息。

stats auth admin:pingcap123 # 监控页面的用户和密码,可设置多个用户名。

stats hide-version # 隐藏监控页面上的 HAProxy 版本信息。

stats admin if TRUE # 手工启用或禁用后端服务器(HAProxy 1.4.9 及之后版本开始支持)。

listen tidb-cluster # 配置 database 负载均衡。

bind <haproxy ip>:10080 # 浮动 IP 和 监听端口。(改这里绑定端口还是10080)

mode tcp # HAProxy 要使用第 4 层的传输层。

balance leastconn # 连接数最少的服务器优先接收连接。`leastconn` 建议用于长会话服务,例如 LDAP、SQL、TSE 等,而不是短会话协议,如 HTTP。该算法是动态的,对于启动慢的服务器,服务器权重会在运行中作调整。

server tidb-1 <tidb1-ip>:10080 check inter 2000 rise 2 fall 3 # 检测 10080端口,检测频率为每 2000 毫秒一次。如果 2 次检测为成功,则认为服务器可用;如果 3 次检测为失败,则认为服务器不可用。

server tidb-2 <tidb2-ip>:10080 check inter 2000 rise 2 fall 3

haproxy -f haproxy10080.cnf

有猫万事足

2023 年10 月 18 日 14:02

12

我自己试了下,在一个haproxy开两个端口,里面代理后面2个不同的端口,也是可以的。

global # 全局配置。

log 127.0.0.1 local2 # 定义全局的 syslog 服务器,最多可以定义两个。

chroot /var/lib/haproxy # 更改当前目录并为启动进程设置超级用户权限,从而提高安全性。

pidfile /var/run/haproxy.pid # 将 HAProxy 进程的 PID 写入 pidfile。

maxconn 4096 # 单个 HAProxy 进程可接受的最大并发连接数,等价于命令行参数 "-n"。

nbthread 8 # 最大线程数。线程数的上限与 CPU 数量相同。

user haproxy # 同 UID 参数。

group haproxy # 同 GID 参数,建议使用专用用户组。

daemon # 让 HAProxy 以守护进程的方式工作于后台,等同于命令行参数“-D”的功能。当然,也可以在命令行中用“-db”参数将其禁用。

stats socket /var/lib/haproxy/stats # 统计信息保存位置。

defaults # 默认配置。

log global # 日志继承全局配置段的设置。

retries 2 # 向上游服务器尝试连接的最大次数,超过此值便认为后端服务器不可用。

timeout connect 2s # HAProxy 与后端服务器连接超时时间。如果在同一个局域网内,可设置成较短的时间。

timeout client 30000s # 客户端与 HAProxy 连接后,数据传输完毕,即非活动连接的超时时间。

timeout server 30000s # 服务器端非活动连接的超时时间。

listen admin_stats # frontend 和 backend 的组合体,此监控组的名称可按需进行自定义。

bind 0.0.0.0:8000 # 监听端口。

mode http # 监控运行的模式,此处为 `http` 模式。

option httplog # 开始启用记录 HTTP 请求的日志功能。

maxconn 10 # 最大并发连接数。

stats refresh 30s # 每隔 30 秒自动刷新监控页面。

stats uri /haproxy # 监控页面的 URL。

stats realm HAProxy # 监控页面的提示信息。

stats auth admin:pingcap123 # 监控页面的用户和密码,可设置多个用户名。

stats hide-version # 隐藏监控页面上的 HAProxy 版本信息。

stats admin if TRUE # 手工启用或禁用后端服务器(HAProxy 1.4.9 及之后版本开始支持)。

listen tidb-cluster # 配置 database 负载均衡。

bind <haproxy ip>:3306 # 浮动 IP 和 监听端口。

mode tcp # HAProxy 要使用第 4 层的传输层。

balance leastconn # 连接数最少的服务器优先接收连接。`leastconn` 建议用于长会话服务,例如 LDAP、SQL、TSE 等,而不是短会话协议,如 HTTP。该算法是动态的,对于启动慢的服务器,服务器权重会在运行中作调整。

server tidb-1 <tidb1-ip>:4000 check inter 2000 rise 2 fall 3 # 检测 4000端口,检测频率为每 2000 毫秒一次。如果 2 次检测为成功,则认为服务器可用;如果 3 次检测为失败,则认为服务器不可用。

server tidb-2 <tidb2-ip>:4000 check inter 2000 rise 2 fall 3

listen tidb-cluster-status # 配置 database 负载均衡。

bind <haproxy ip>:10080 # 浮动 IP 和 监听端口。

mode tcp # HAProxy 要使用第 4 层的传输层。

balance leastconn # 连接数最少的服务器优先接收连接。`leastconn` 建议用于长会话服务,例如 LDAP、SQL、TSE 等,而不是短会话协议,如 HTTP。该算法是动态的,对于启动慢的服务器,服务器权重会在运行中作调整。

server tidb-1 <tidb1-ip>:10080 check inter 2000 rise 2 fall 3 # 检测 10080端口,检测频率为每 2000 毫秒一次。如果 2 次检测为成功,则认为服务器可用;如果 3 次检测为失败,则认为服务器不可用。

server tidb-2 <tidb2-ip>:10080 check inter 2000 rise 2 fall 3

这个配置就是haproxy会开放3306代理后面tidb的4000端口,同时开10080代理后面tidb的10080端口。

然后重新加载配置尽可能不丢包的方法,可以看下面这个连接。

system

2023 年12 月 17 日 14:02

13

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。