【 TiDB 使用环境】生产环境 /测试/ Poc进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

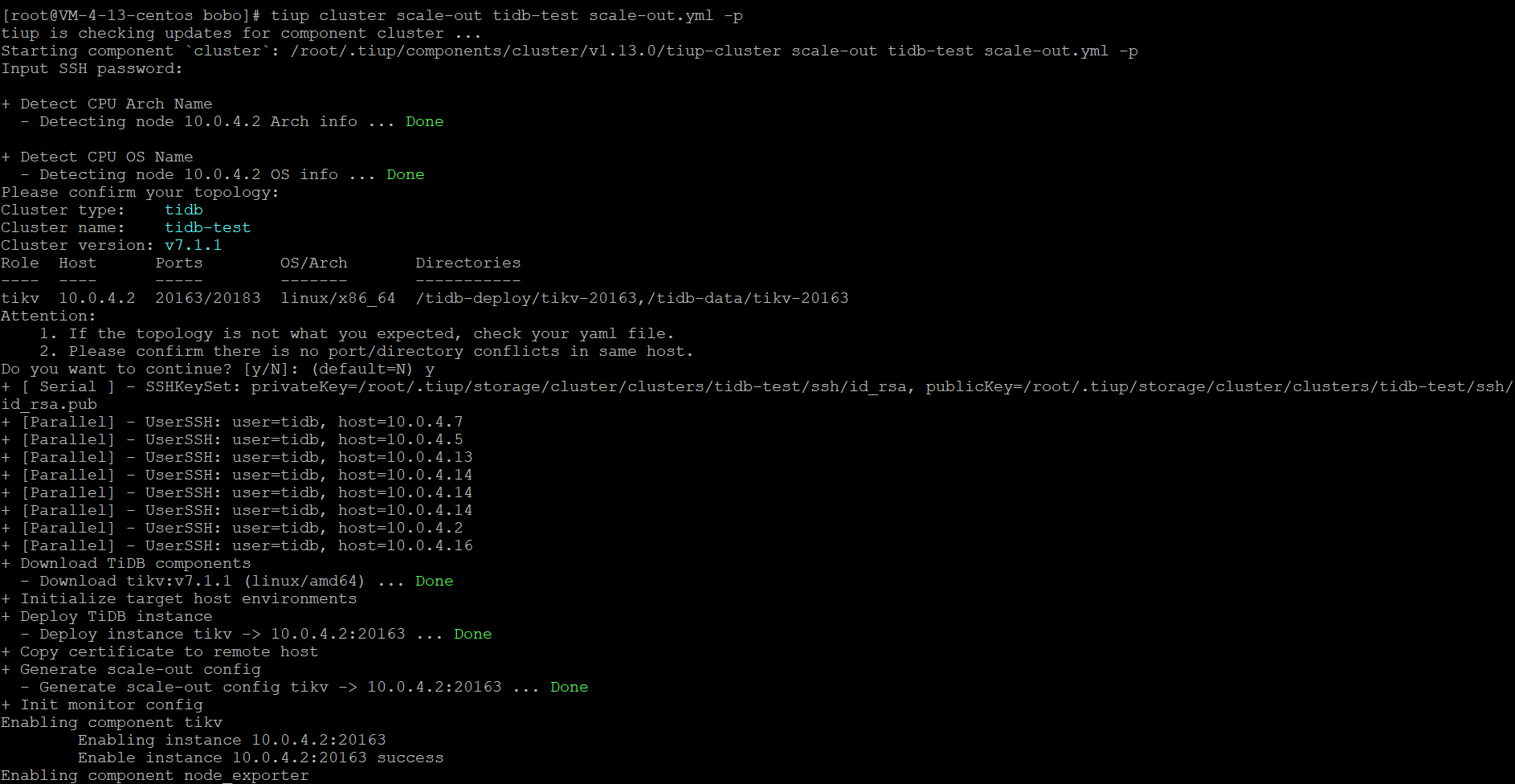

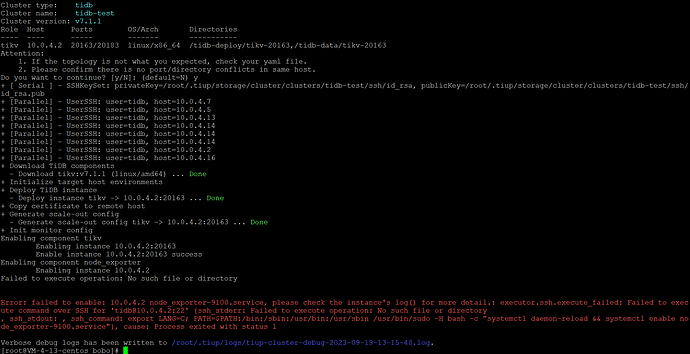

报错信息如下:

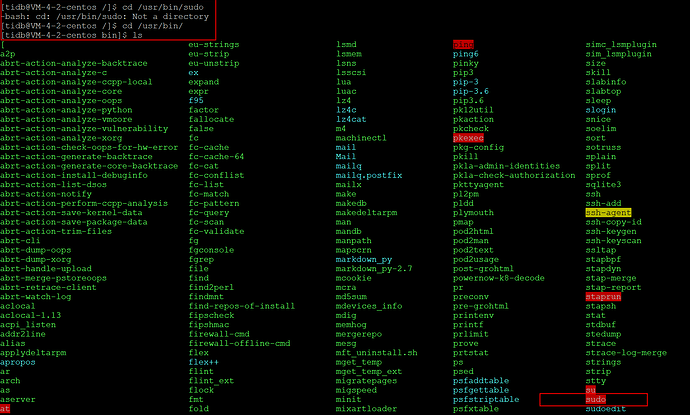

系统有如下目录的:/bin:/sbin:/usr/bin:/usr/sbin /usr/bin/sudo

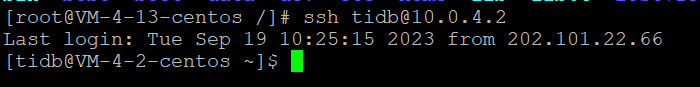

免密登录测试截图:

10.0.4.2上的目录截图:

报错截图:

新服务器密码和老的是否一致,你直接手动去ssh tidb@10.0.4.2 能登陆吗?

报错显示 SSH 连接 不上, 看下密码,访问设置

SSH连接是可以的,也设置了免密登录。但不知道是为啥会报这个错

目前报的这个错误,是指的没有该文件或目录!对应的文件权限也分配的,还是报这个错。看起来不是密码的问题!

Jasper

2023 年9 月 19 日 06:58

9

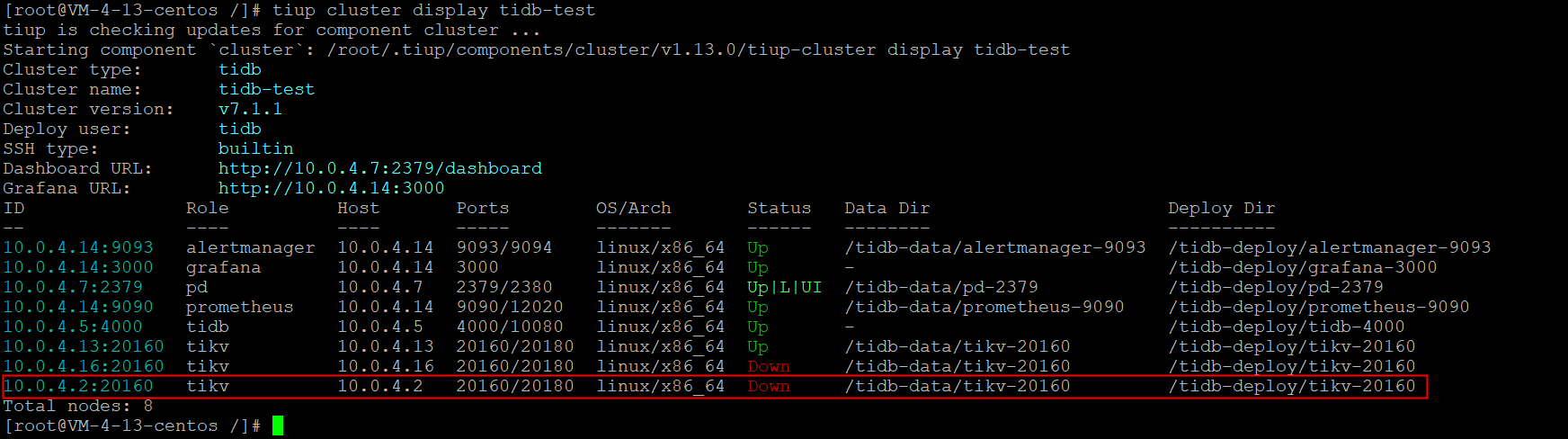

你 tiup cluster display 看下当前的集群状态是正常的吗?

集群状态是正常的,机器是之前缩容后重装了系统,然后重新扩容,是这个情况。

集群状态截图:

我模拟了宕机,把两个节点下了,然后想重新系统后,再模拟扩容,就出了这种问题。

你在pd-ctl看下 是不是有同一个ip同一个端口的2个store

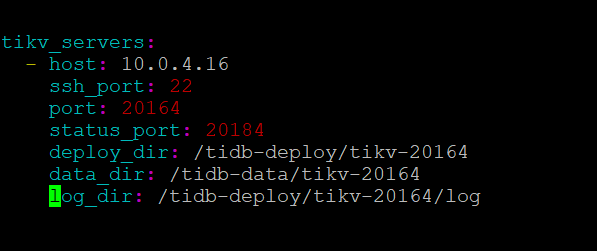

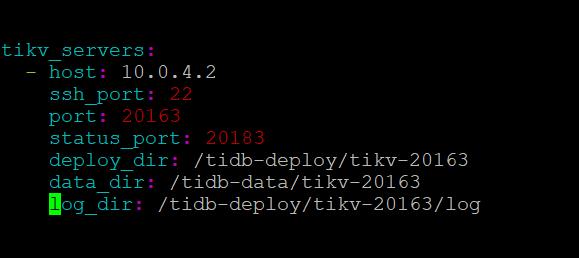

这个错误是必现的,我用了集群中的10.0.4.16服务器,重装系统后,重扩容,也是报的这个错。

*10.0.4.2节点上没有安装或启动node_exporter-9100.service,这是一个用于收集和暴露硬件和内核相关指标的Prometheus导出器。

检查10.0.4.2节点上是否已经下载并解压了node_exporter-9100.service的二进制文件并且是否有执行权限。

检查scale-out.yml文件中是否有指定10.0.4.2节点的node_exporter-9100.service的部署目录和端口号,例如:

monitored:

node_exporter_port: 9100

blackbox_exporter_port: 9115

deploy_dir: /tidb-deploy/monitored-9100

data_dir: /tidb-data/monitored-9100

log_dir: /tidb-deploy/monitored-9100/log

重新执行扩容命令,或者手动在10.0.4.2节点上启动node_exporter-9100.service

sudo systemctl daemon-reload && sudo systemctl enable node_exporter-9100.service && sudo systemctl start node_exporter-9100.service

1 个赞

Jasper

2023 年9 月 19 日 08:06

18

你模拟宕机,但是对应的tikv-server 没有缩容掉呀,如果是测试环境的话,你可以先把对应的tikv scale-in 缩容掉,然后再扩容进来就正常了

看起来是没有缩容干净 node_exporter-9100肯定还有残留

Jasper

2023 年9 月 19 日 08:17

20

这不是没缩容干净,从上面那个图来看是根本没缩容呀。。。