【 TiDB 使用环境】生产环境 /测试/ Poc

【遇到的问题:问题现象及影响】需要把集群V4.0.0的所有库迁移到V7.1.1集群中,需要注意哪些问题,以及做哪些前置检查。两个集群在不同的机器上

现有集群情况:

V4.0.0: 3个tidb节点,9个tikv节点,3个pd节点,2个TiFlash节点

V7.1.1:2个tidb节点,3个tikv节点,3个pd节点,无TiFlash节点

可以看一下这个文档:https://docs.pingcap.com/zh/tidb/stable/migrate-from-tidb-to-tidb#从-tidb-集群迁移数据至另一-tidb-集群

支持升级,也支持迁移

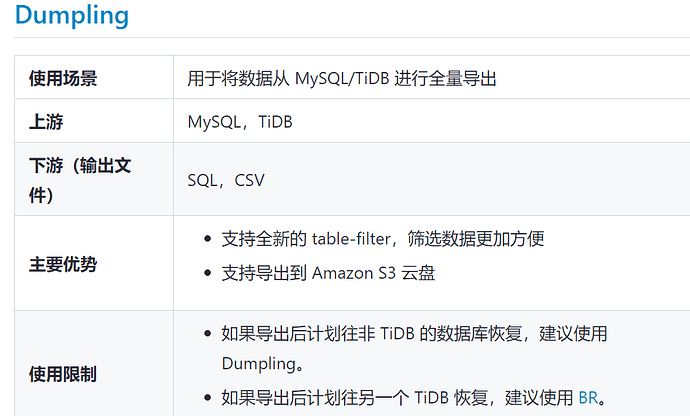

应该只能用dumpling+lightning然后cdc或者binlog同步吧

应该用BR+TICDC,我想了解的是需要注意什么,因为现在两个集群的版本和节点数有差异

看过了,我想了解的是注意事项,现在集群的版本和节点数有差异

我想问的是迁移注意事项以及迁移前的检查工作是什么

BR不行的,跨这么大版本

可以停机的话,就直接搞逻辑方式导出导入吧

先看看数据量,数据量不大dumpling就行,也挺快的

dumpling支持上下游都是tidb的

导入用lightning

br不太行,4.0到7.1,跨太多版本了,可以看下br的兼容性

https://docs.pingcap.com/zh/tidb/stable/backup-and-restore-overview#版本间兼容性

dumpling下载全量数据:

1.内存配置要高,防止下载过程中OOM;

2.dump failed: Error 1105: statement count 5001 exceeds the transaction limitation, autocommit = true,下载过程中有该报错,调整stmt-count-limit长度。

Lightning导入全量数据:

1.内存配置要高,防止上传过程中OOM;

2.Error 1071: Specified key was too long; max key length is 3072 bytes"],上传过程中有该报错,tidb-server配置中添加max-index-length = 3072*4,重新reload新集群;

binlog增量同步:

1.drainer 组件启动时会将binlog历史日志内所有DDL操作在内存中遍历一次,消耗内存较大,经测试6.4T集群drainer 启动使用需230G内存,在内存中遍历1个小时。

跨大版本的话,最好是逻辑备份的方式,这样比较好