【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】v5.4.0 2tidb 3pd 3tikv 2ha

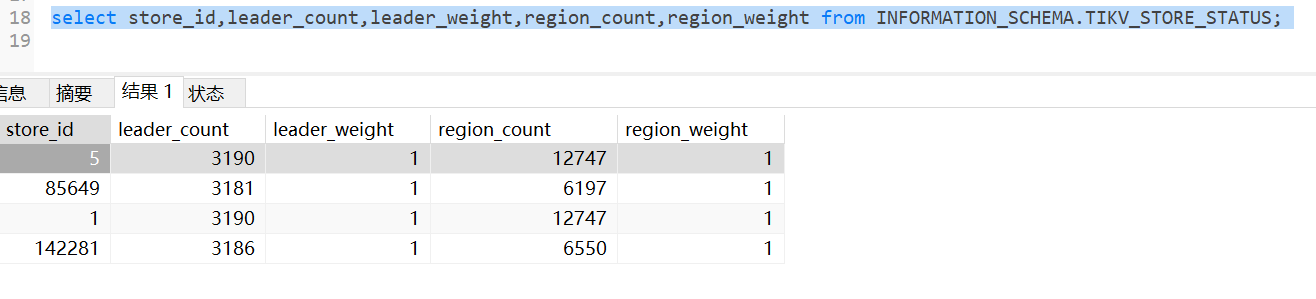

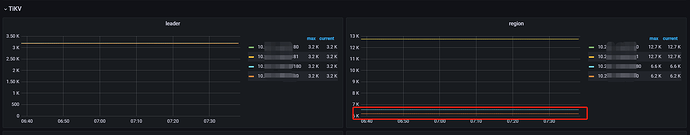

【复现路径】由于IO故障,8月16日扩容了一个tikv后缩容了一个tikv,leader和region_count都平衡了,9月8日后扩容了一个tikv,leader平了,但是region_count是两两平衡,旧的两个tikv是平衡的,新添加的region_count是平衡的,如图所示:

【遇到的问题:问题现象及影响】

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

硬盘容量都一样吗

新增加的存储1.5T,原来的3tikv的存储空间1000G左右。

理论上tikv上region数量和硬盘容量有关,硬盘大的region也就多些

看文件系统利用率

9月8日新增的tikv数据盘使用率7%,8月16日新增的tikv数据盘使用率14%,旧的两台tikv数据盘使用率为22%和25%。

看看各个节点的评分呢?分布应该是依据评分进行的

请问下各节点的评分需要怎么看

这个问题做了测试,在3节点3副本的集群上面添加一个tikv节点,添加上去后leader和region都是0,并没有进行数据平衡,当我把原来3个节点中的一个tikv缩容后,数据就开始往新的节点平衡,并且是把缩容的数据平衡到新添加的节点上面来的,所以后面添加的tikv节点都会平衡这次缩容的节点数据,当添加多个节点后就平分最后那个缩容的节点数据,所以导致和原始数据不平衡。

版本有点低了。

其实最后都是要看 balance-region-scheduler, balance-leader-scheduler

而5.4pd看上去还无法配置这2个调度器。所以也没有什么好的办法来控制。pdctl手工都做不了。

https://docs.pingcap.com/zh/tidb/v5.4/pd-control#scheduler-show--add--remove--pause--resume--config

不清楚你是哪个版本和服务器间的区别,我这扩容后每个节点的数量都是一致,你这有点儿奇怪