【 TiDB 使用环境】生产环境

【 TiDB 版本】7.1.0

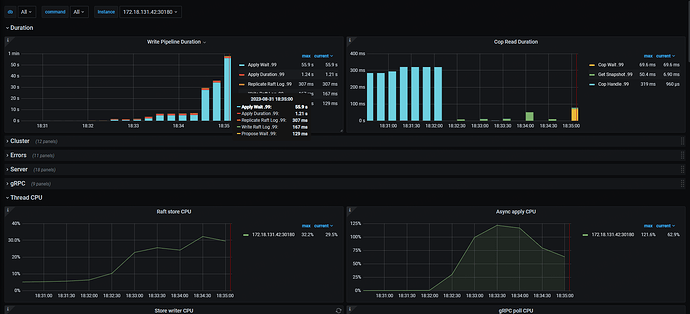

使用tispark走两阶段提交写入tikv, 出现leader drop, 排查发现tikv apply wait特别高, 但是appy 线程 cpu并不高,如下图, 请问下可能是什么原因导致apply wait特别高

线程池设置如下:

raftstore.apply-pool-size=5

raftstore.store-pool-size=4

参考文档:https://docs.pingcap.com/zh/tidb/stable/latency-breakdown#异步写入

建议排查下集群所有tikv 节点的写入是否正常:

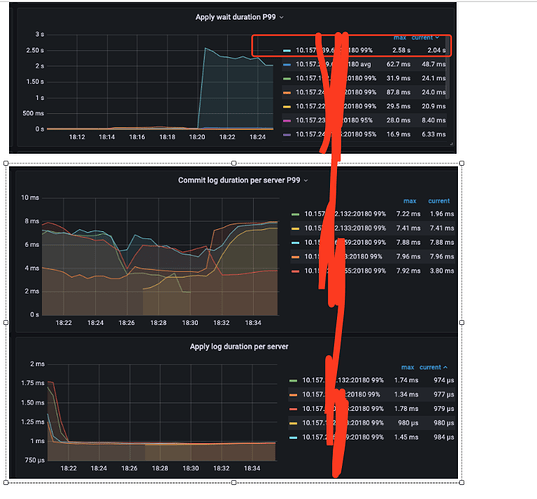

- Apply wait duration:apply 的等待时间的直方图

- Apply wait duration per server:每个 TiKV 实例上每个 apply 的等待时间的直方图

https://docs.pingcap.com/zh/tidb/stable/grafana-tikv-dashboard#raft-propose

然后排查以下两点:

参考文档:https://docs.pingcap.com/zh/tidb/stable/tidb-troubleshooting-map#45-tikv-写入慢

2 个赞

这些我都排查过了,raftstore和apply线程池都正常,单个apply线程也看了没问题,怀疑是apply wait不是在等待线程池,而是等待其它的(限流或者锁?),请问有没有相关排查思路

没有更多的资料,没办法判断了,只能靠你自己了

有没有TiKV 节点的磁盘写入速度较慢的现象呢,查查磁盘的 IOPS。

找到原因了么,楼主能否分享下,我们遇到这个问题,都准备换服务器了

服务器的配置是?另外你这表是不是列比较少?其它kv节点load怎样?有没有region热点?我现在也遇到一样的问题

raft延迟

嗯,可以照此试试~

有点像,可以借鉴~~

可以看下磁盘的写入和读取速度是否存在问题

是否服务器上有其他服务,我们曾经遇到过是其他服务导致服务器资源被占用