普罗米修斯

1

【 TiDB 使用环境】生产环境

【 TiDB 版本】v3.0.3

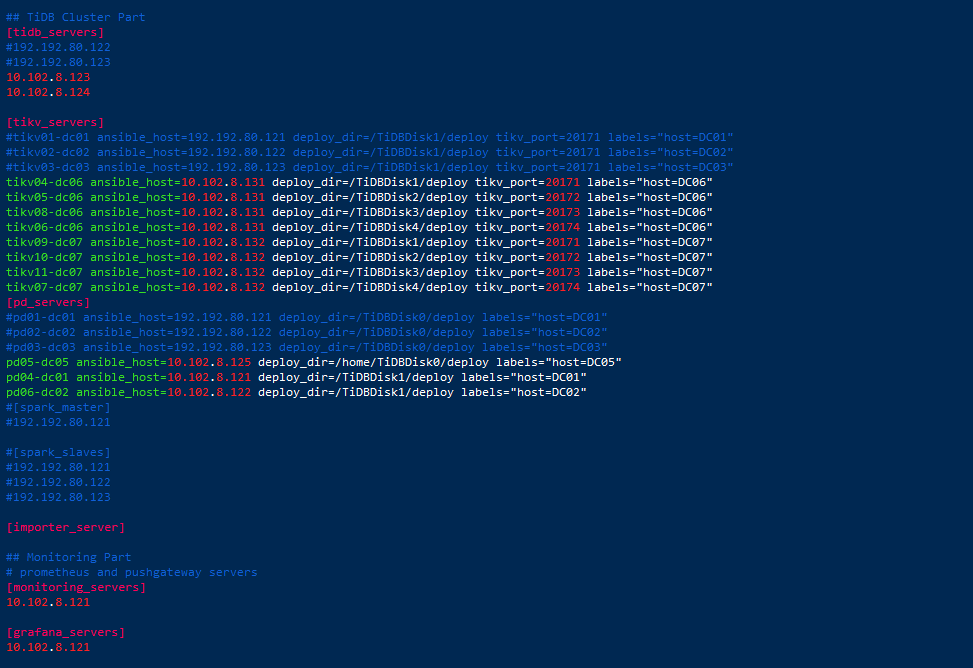

【遇到的问题】下线两个tikv下线了2天,现在两个tikv分别卡到40、51个store无法下线

【资源配置】

2个tidb-server、3个pd-server、8个tikv-server

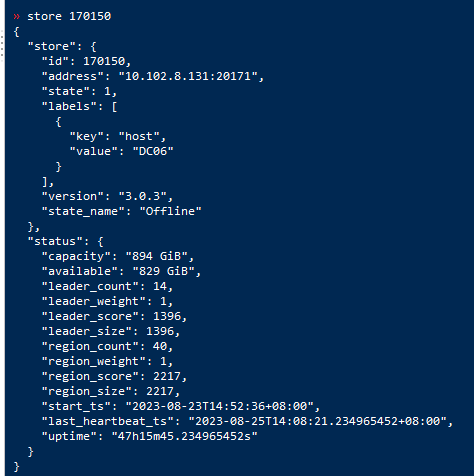

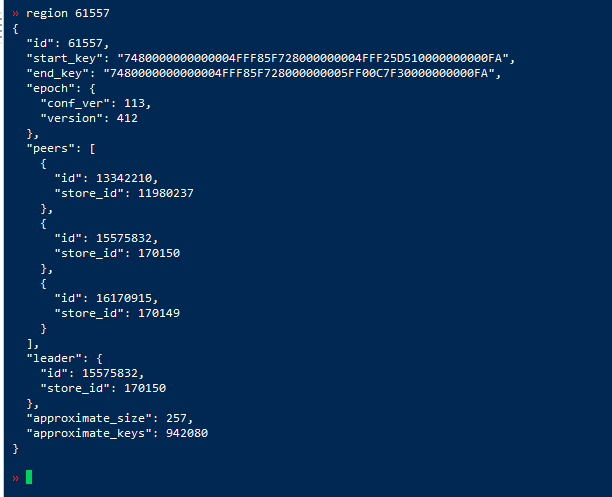

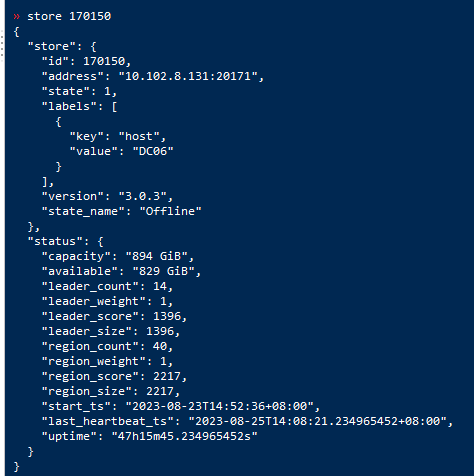

无法下线的两个tikv节点(170150、170152)

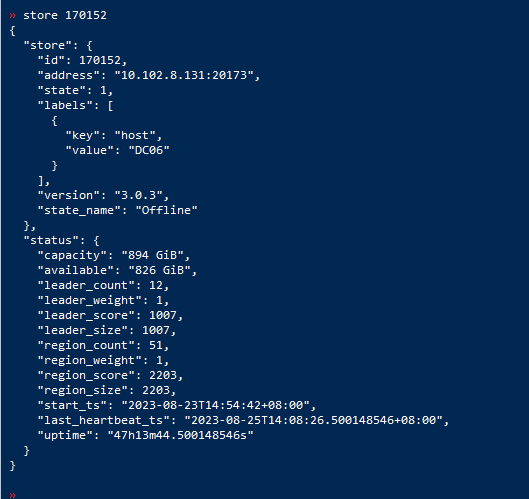

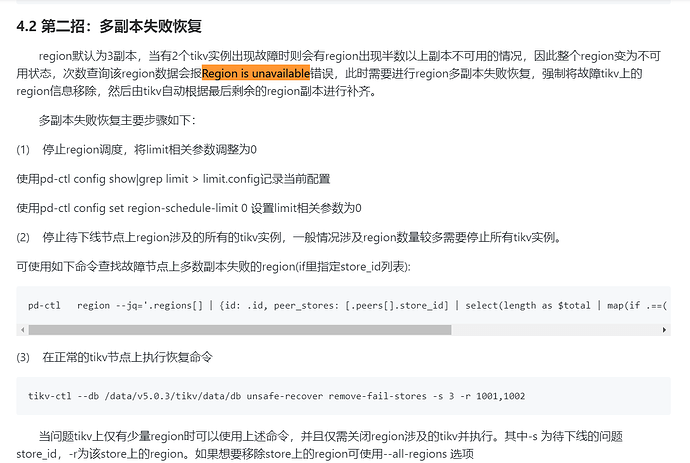

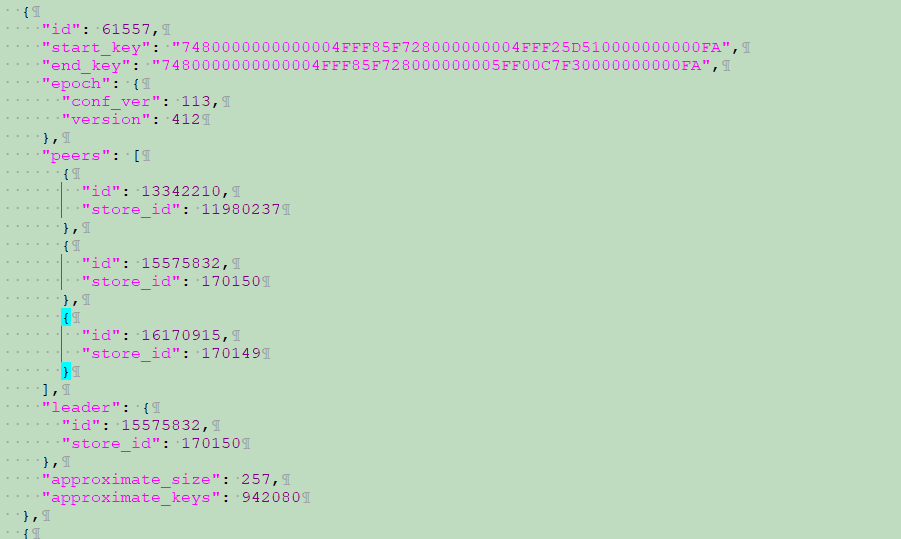

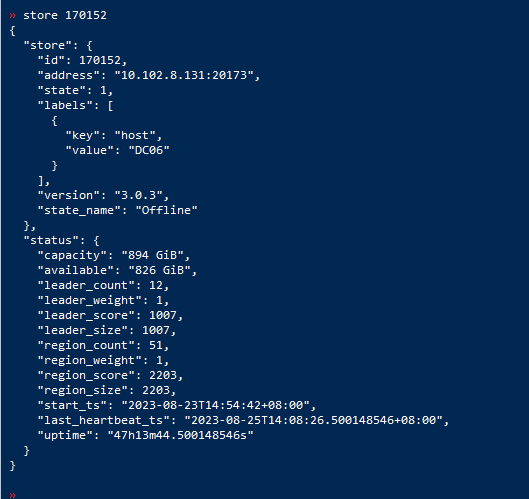

我将region-schedule-limit、max-pending-peer-count 调大后等待仍是无法下线,我计划将下线的tikv(170150 170152)中的region转移出去促使他们下线,找了一个下线tikv中的region做了如下操作:

operator remove 61557

operator add transfer-region 61557 170151 141001 141002

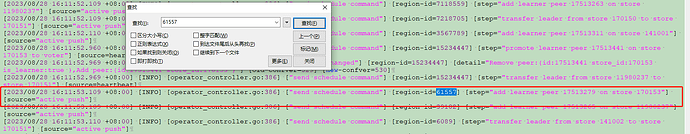

提示sucess,查看了下region没有被转移,筛选了下,发现operator操作在队列中很长时间;

再等待一段时间,这个operator操作在队列中消失,region 61557也没有被转移出去

普罗米修斯

4

集群还是用不了,还是[Err] 9005 - Region is unavailable,前两天社区建议将tikv下线尝试下,下线就卡住了

普罗米修斯

10

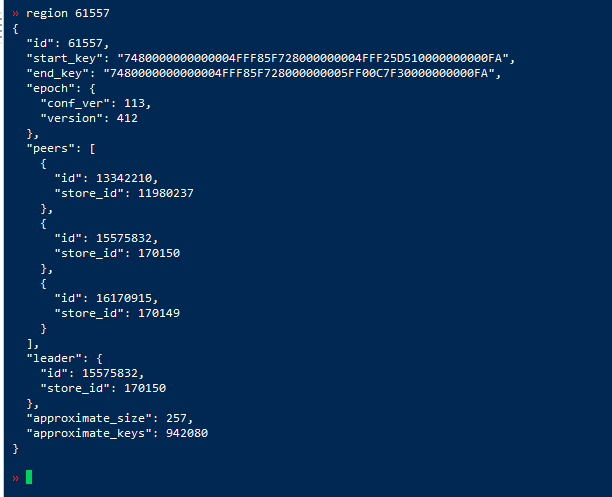

三板斧之前试过了 unsafe执行了很多遍 ,region数也不降下去了,这是下线tikv170150 170152的region。

170150.log (14.7 KB)

170152.log (15.6 KB)

手动operator 也不行,

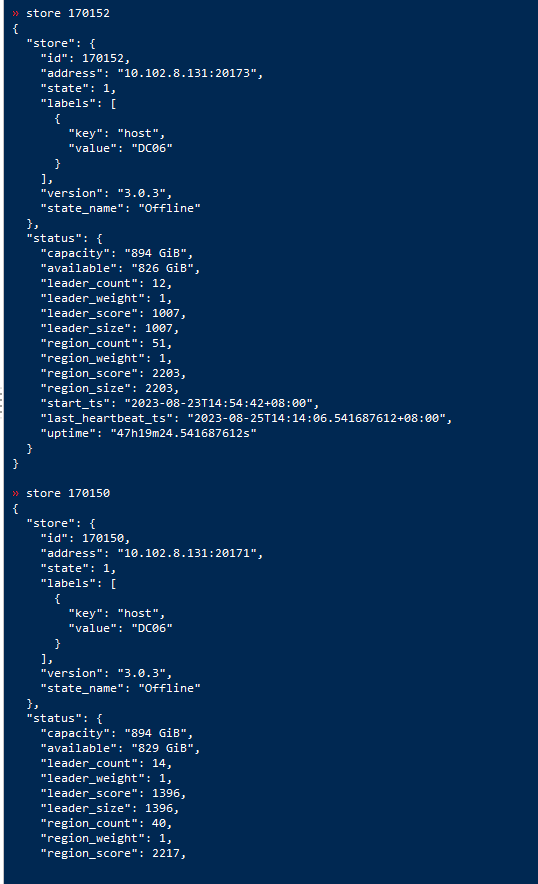

查看了下未迁移的region

一直在驱逐leader 执行一直在timeout ,

还有增加peer 都一直不成功

普罗米修斯

14

清除pd缓存 让region重新生成副本 修复索引

1 个赞

h5n1

(H5n1)

15

那个记录unsafe storeid的region呢

普罗米修斯

16

清除缓存后自动生成了 部分没有生成的就在所在store节点recreate 修复索引 删除重建索引

h5n1

(H5n1)

19

清PD 缓存 是把所有region的都处理了,还是只是剩的那几个

system

(system)

关闭

20

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。