【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】v5.4.0 2tidb 3pd 3kv 1ticdc

【复现路径】ticdc服务器的数据目录被弄坏了,估计数据都要被删除才能恢复这个存储的挂载,现在这个ticdc的状态是down,现在的问题是我还能通过缩容的方式来进行ticdc卸载吗?或者有没有更优的方式来处理这个ticdc组件。

【遇到的问题:问题现象及影响】

【资源配置】

【附件:截图/日志/监控】

1个cdc 只能缩容在扩容了,数据要看你自己的恢复了,下游容忍重复的话,可以到指定时间开始

如果两个集群在同步cdc,可以将cdc部署到另一个集群中,A集群中down掉的cdc已经在pd中信息状态是down,所以将B集群注册新的cdc到A集群的pd中不影响的

强制缩容,然后再扩容,最快的方法。

下游还没有开始同步数据

缩容在扩容即可

当然是缩容最简单了

可以缩容再扩容

因为没有操作过,不知道这种情况下能不能操作成功。

可以装个测试机先试试,并不复杂,单机部署就行

文件没有了删除可以加–force 参数

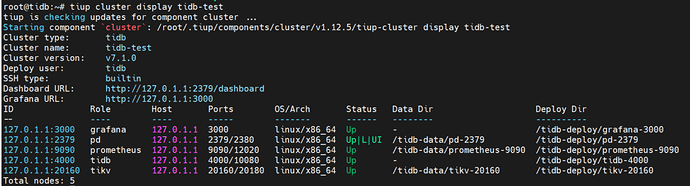

我在7.1.0上单机测了下:

先扩容加了个cdc节点

root@tidb:~# tiup cluster scale-out tidb-test scale-out-cdc.yml -u root -p

tiup is checking updates for component cluster ...

Starting component `cluster`: /root/.tiup/components/cluster/v1.12.5/tiup-cluster scale-out tidb-test scale-out-cdc.yml -u root -p

Input SSH password:

+ Detect CPU Arch Name

- Detecting node 127.0.1.1 Arch info ... Done

+ Detect CPU OS Name

- Detecting node 127.0.1.1 OS info ... Done

Please confirm your topology:

Cluster type: tidb

Cluster name: tidb-test

Cluster version: v7.1.0

Role Host Ports OS/Arch Directories

---- ---- ----- ------- -----------

cdc 127.0.1.1 8300 linux/x86_64 /tidb-deploy/cdc-8300,/tidb-data/cdc-8300

Attention:

1. If the topology is not what you expected, check your yaml file.

2. Please confirm there is no port/directory conflicts in same host.

Do you want to continue? [y/N]: (default=N) y

+ [ Serial ] - SSHKeySet: privateKey=/root/.tiup/storage/cluster/clusters/tidb-test/ssh/id_rsa, publicKey=/root/.tiup/storage/cluster/clusters/tidb-test/ssh/id_rsa.pub

+ [Parallel] - UserSSH: user=tidb, host=127.0.1.1

+ [Parallel] - UserSSH: user=tidb, host=127.0.1.1

+ [Parallel] - UserSSH: user=tidb, host=127.0.1.1

+ [Parallel] - UserSSH: user=tidb, host=127.0.1.1

+ [Parallel] - UserSSH: user=tidb, host=127.0.1.1

+ Download TiDB components

- Download cdc:v7.1.0 (linux/amd64) ... Done

+ Initialize target host environments

+ Deploy TiDB instance

- Deploy instance cdc -> 127.0.1.1:8300 ... Done

+ Copy certificate to remote host

+ Generate scale-out config

- Generate scale-out config cdc -> 127.0.1.1:8300 ... Done

+ Init monitor config

Enabling component cdc

Enabling instance 127.0.1.1:8300

Enable instance 127.0.1.1:8300 success

Enabling component node_exporter

Enabling instance 127.0.1.1

Enable 127.0.1.1 success

Enabling component blackbox_exporter

Enabling instance 127.0.1.1

Enable 127.0.1.1 success

+ [ Serial ] - Save meta

+ [ Serial ] - Start new instances

Starting component cdc

Starting instance 127.0.1.1:8300

Start instance 127.0.1.1:8300 success

Starting component node_exporter

Starting instance 127.0.1.1

Start 127.0.1.1 success

Starting component blackbox_exporter

Starting instance 127.0.1.1

Start 127.0.1.1 success

+ Refresh components conifgs

- Generate config pd -> 127.0.1.1:2379 ... Done

- Generate config tikv -> 127.0.1.1:20160 ... Done

- Generate config tidb -> 127.0.1.1:4000 ... Done

- Generate config cdc -> 127.0.1.1:8300 ... Done

- Generate config prometheus -> 127.0.1.1:9090 ... Done

- Generate config grafana -> 127.0.1.1:3000 ... Done

+ Reload prometheus and grafana

- Reload prometheus -> 127.0.1.1:9090 ... Done

- Reload grafana -> 127.0.1.1:3000 ... Done

+ [ Serial ] - UpdateTopology: cluster=tidb-test

Scaled cluster `tidb-test` out successfully

然后模拟cdc节点损坏,rm删除了cdc

rm -rf /tidb-deploy/cdc-8300

rm -rf /tidb-data/cdc-8300

重启了集群,看到cdc离线了

然后tiup cluster scale-in tidb-test --node 127.0.1.1:8300删除成功,不成功可以加–force 参数

NB!

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。