扬仔_tidb

2023 年8 月 1 日 10:04

1

【 TiDB 使用环境】生产环境5.3.0

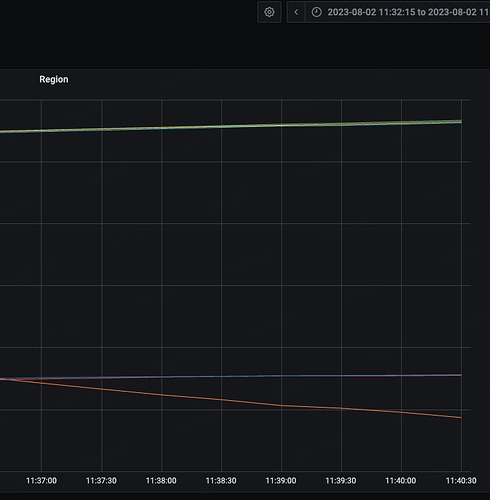

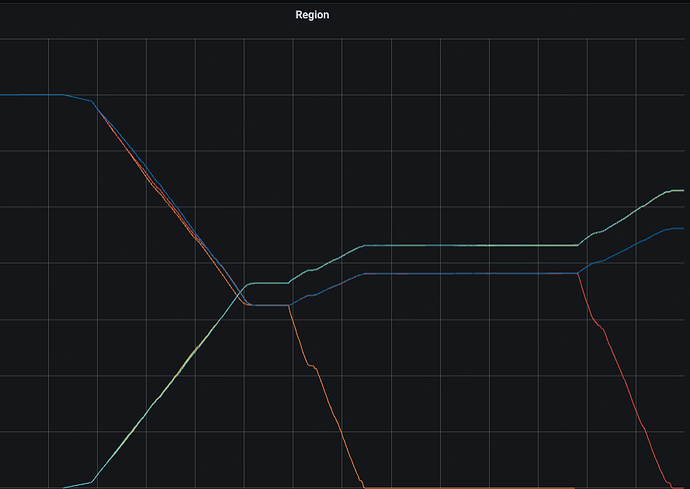

旧的tikv服务器磁盘有问题,打算平滑替换,于是加入新节点替换旧节点的方案

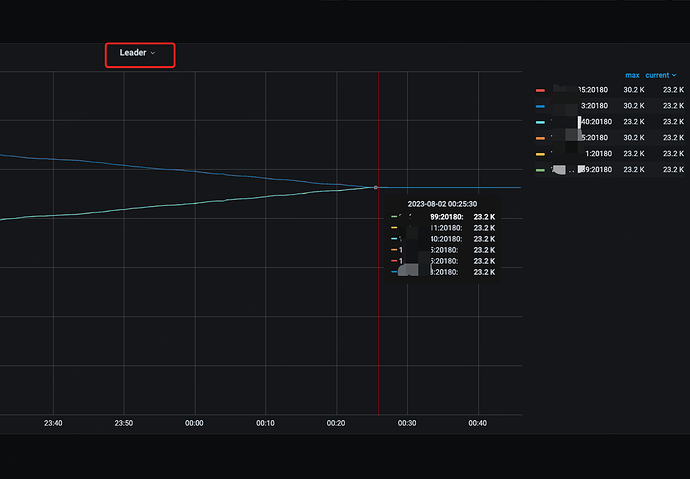

原tkv三个节点,每个节点有140万region,新扩容的节点是16c/32g配置,现在在平衡的过程中新节点cpu使用率才7%,旧tikv节点cpu使用率 50%

有没有什么参数可以加快region平衡的,集群晚上空闲可以调大,白天再调小这个参数

另外,在平衡的过程中如果集群性能下降太厉害,能暂停region迁移吗?

zhanggame1

2023 年8 月 1 日 10:11

2

select * from INFORMATION_SCHEMA.CLUSTER_CONFIG tKEY like ‘%schedule-limit%’

修改命令:schedule.leader-schedule-limit=8;schedule.region-schedule-limit=4096;

2 个赞

redgame

2023 年8 月 1 日 13:33

5

config set max-pending-peer-count 16

1 个赞

主要就是这三个

1 个赞

Kongdom

2023 年8 月 2 日 06:08

8

Kongdom

2023 年8 月 4 日 00:33

10

这是对的,之前3节点3副本,每个节点2t,总数据量是2t乘以3是6t,现在变成2节点3副本,总数据量不变,节点数减少,6t除以2就是每个节点3t了。

每个store节点都有一个打分Region score ,pd会根据这个Region score平衡各个节点的region