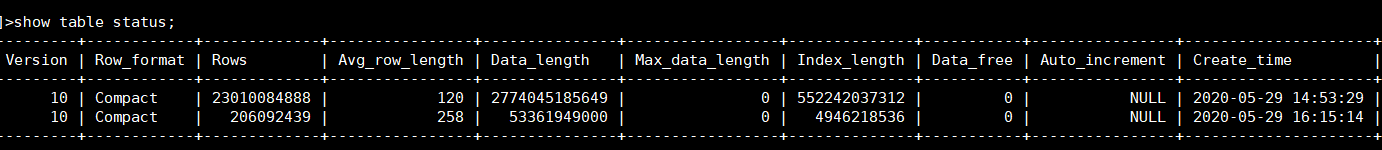

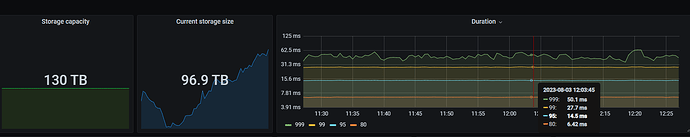

我们有数据量千亿左右的单表,做了3机房容灾,qps2万多P99100ms以内,也有集群数据量接近200TB的,qps1W以内P99不到30ms。

影响性能的因素太多了,数据量只是一个方面,就我能短时间内想起来的,影响性能的因素有:

- 服务器性能:硬盘iops、带宽,网络带宽、cpu,内存大小等

- 表的记录数,单条记录长度

- 访问表的方式,点查还是大范围查询,读写比例多少,qps多少,索引是否合理健全

- 集群节点间是否跨AZ通信,AZ之间网络延迟如何

- Store数据量是否超出预设ratio,导致调度占用过多资源等等

这个表数据之前一直维持在一千五百多亿,后来清理了一千多亿还剩200多亿了。

再截图一个手边的集群: