【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

【资源配置】进入到 TiDB Dashboard -集群信息 (Cluster Info) -主机(Hosts) 截图此页面

【附件:截图/日志/监控】

tidb一个表存多少数据,性能会明显下降?

资源充足的情况下,应该没有数量上限,我这边单表过5亿正常用~

问下,现在我们有一个大表40亿数据,插入数据比较慢,一秒好像最多只能插入10M的数据,这个是正常的吗? 或者有什么好的优化方案? 我是刚了解TIDB,还不太熟系。

多少个tikv节点,用的啥盘,有写热点吗?可以通过dashboard看一下插入语句慢在那个环节

好的,谢谢,运维部署的,我一会去查询下

dashboard监控可以发一下看看

看看grafana监控里的IO有没有打满~

10M的数据并不慢,一小时36G,一天快1T了,先看看磁盘使用率和cpu使用量了

恩,是的,我们的TIDB是自建的,配置都是默认的,现在用了5个kv节点。nvme的固态盘,这些有优化的空间吗? 比如说修改配置文件等?

这个要看机器配置和多少个kv节点了,其实就是数据被打散在各个kv节点上分布,最重要的是IO

这个不好测试出来

TiKV 中每个region 的大小是96MB(默认值),但是单个TiKV 管理的数据最好不超过4TB,因为这样会让TiKV和PD之间的心跳过多,导致性能下降。

请参考

2 个赞

看来要经常逛逛专栏了,之前没看到有这么好的文档。

好的,非常感谢

good

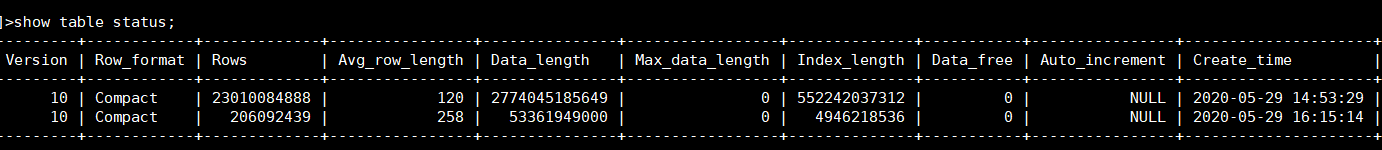

行数和表的大小应该都会影响,看了大家的回复及一个资料,说了40亿+数据,但没有说大概表有多大

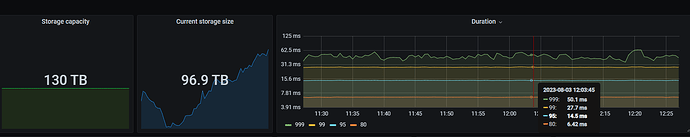

我们有数据量千亿左右的单表,做了3机房容灾,qps2万多P99100ms以内,也有集群数据量接近200TB的,qps1W以内P99不到30ms。

影响性能的因素太多了,数据量只是一个方面,就我能短时间内想起来的,影响性能的因素有:

- 服务器性能:硬盘iops、带宽,网络带宽、cpu,内存大小等

- 表的记录数,单条记录长度

- 访问表的方式,点查还是大范围查询,读写比例多少,qps多少,索引是否合理健全

- 集群节点间是否跨AZ通信,AZ之间网络延迟如何

- Store数据量是否超出预设ratio,导致调度占用过多资源等等

这个表数据之前一直维持在一千五百多亿,后来清理了一千多亿还剩200多亿了。

再截图一个手边的集群:

1 个赞

你们容灾是用tidb分布式架构实现的还是数据同步实现的

特别重要的同步到另一个集群或者在其他异构存储上还有数据,一般重要的3机房部署即可。

1 个赞