我们有需求是将部分tidb数据同步到es,考虑使用logstash,但不能同步物理删除的数据,因此考虑到使用TiCDC进行监听删除事件,按照官方文档,我过滤了insert和update事件,但发现不生效,启动同步任务的命令如下:

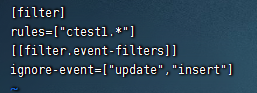

配置文件如下:

但是实践发现并不生效。

我们有需求是将部分tidb数据同步到es,考虑使用logstash,但不能同步物理删除的数据,因此考虑到使用TiCDC进行监听删除事件,按照官方文档,我过滤了insert和update事件,但发现不生效,启动同步任务的命令如下:

配置文件如下:

但是实践发现并不生效。

你是要把屏蔽delete还是剩下delete?屏蔽delete的话ignore-event=[“delete”]

我只需要delete,不关心update和insert。

Canal-JSON 协议本是为 MySQL 设计的,其中并不包含 TiDB 专有的 CommitTS 事务唯一标识等重要字段。为了解决这个问题,TiCDC 在 Canal-JSON 协议格式中附加了 TiDB 扩展字段。在 sink-uri 中设置 enable-tidb-extension 为 true

TiCDC Canal-JSON Protocol | PingCAP 文档中心

你这个回答跟问题无关吧

那应该就是这样啊,是这样写了,没数据产生?

就是没有生效啊,除了有delete事件,还有insert和update事件。

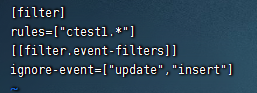

matcher = [“ctest1.*”]

matcher没写?这个写ignore-event上面一行

搞定了,Thanks.

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。