【 TiDB 使用环境】测试

【 TiDB 版本】6.5.2

【复现路径】

集群中原本部署了3个tikv,并绑定本地存储的pv,所以只能一个节点一个tikv

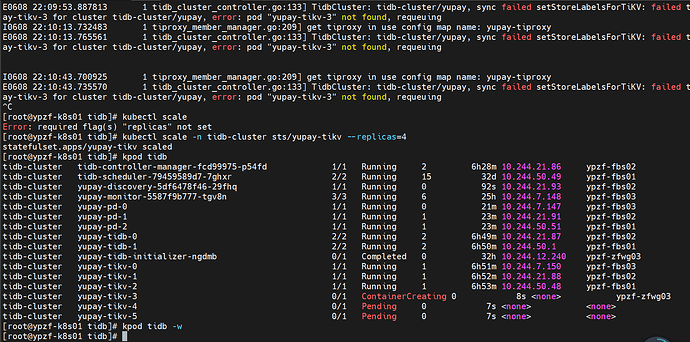

执行删除pod操作: kubectl delete pod -n tidb-cluster yupay-tikv-2

【遇到的问题:问题现象及影响】

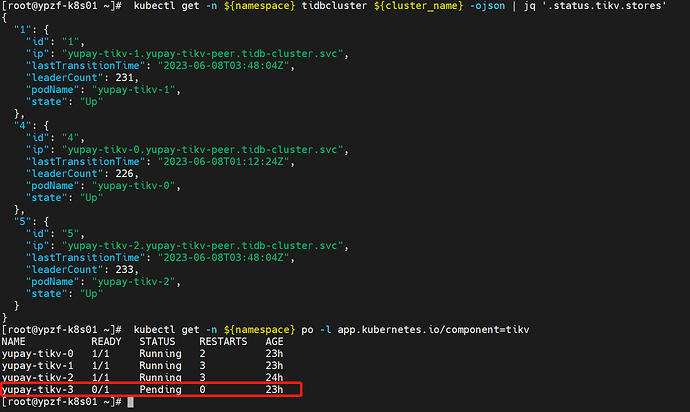

系统开始创建第4个kv,但因为没有我预先提供的pv,所以一直pending

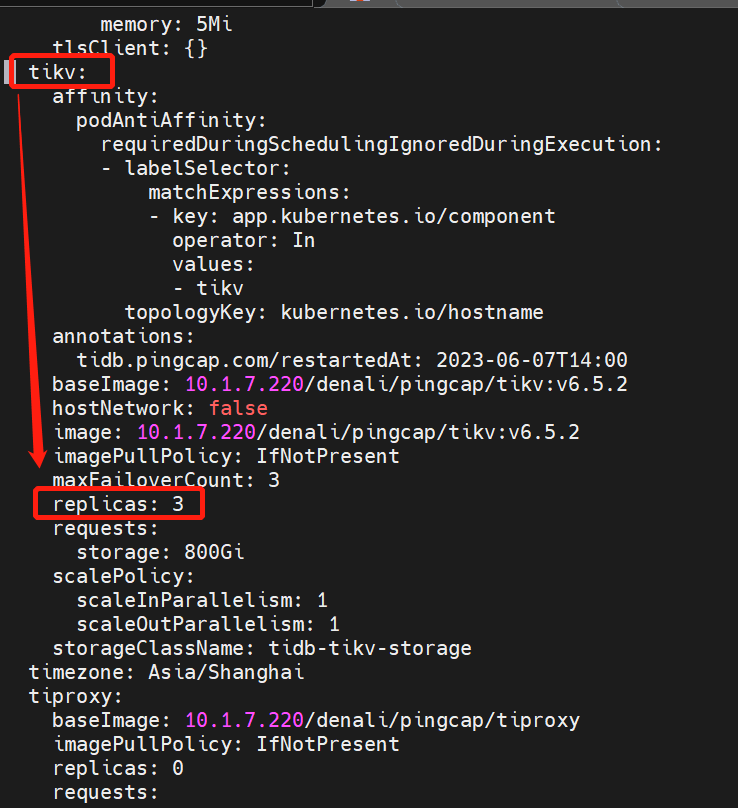

这时候我的tc配置 tikv.replicas: 3。不知道那里导致它扩容了

后来我尝试使用 kubectl scale sts/yupay-tikv replicas=3 让它变为3个。但不确定是否对集群是否影响(但现在sysbench tps 只有1200,不高)

如果我删了这个pod对应的pvc,又会自动创建出来

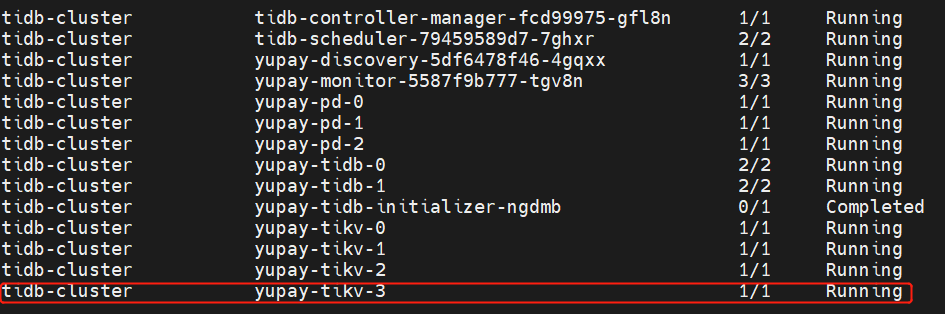

后来我增加了一个pv,让第4个tikv创建出来,然后修改replicas=3,还是不会退回去

最后我还是用 kubectl scale 把tikv数量调回3个

现在删了第4个pvc,不会再跑出新的tikv了

【资源配置】

master: 8核16G * 3台

数据节点:64核 192G内存,SSD 磁盘 * 3

【TiDB Operator 版本】:1.4.4

【K8s 版本】:1.21.5

【附件:截图/日志/监控】

配置pv后

tidb-cluster-temp.yaml (7.7 KB)

operator-更新配置.log (96.1 KB)

operator-直接缩减tikv.log (7.1 KB)

您好,根据 TiDB Operator 的官方文档,可以通过修改 TiKV 的副本数来增加或减少 TiKV 节点的数量。您可以使用以下命令来修改 TiKV 副本数:

kubectl patch tc <tidbcluster-name> -n <namespace> --type='json' -p='[{"op": "replace", "path": "/spec/tikv/replicas", "value": <new-replicas>}]'

其中 <tidbcluster-name> 是 TiDB 集群的名称,<namespace> 是 TiDB 集群所在的命名空间,<new-replicas> 是您想要设置的 TiKV 副本数。

如果您想要缩减 TiKV 节点的数量,可以将 <new-replicas> 设置为比当前副本数更小的值。请注意,缩减 TiKV 节点的数量可能会导致数据丢失或其他不可预测的问题,因此请谨慎操作。

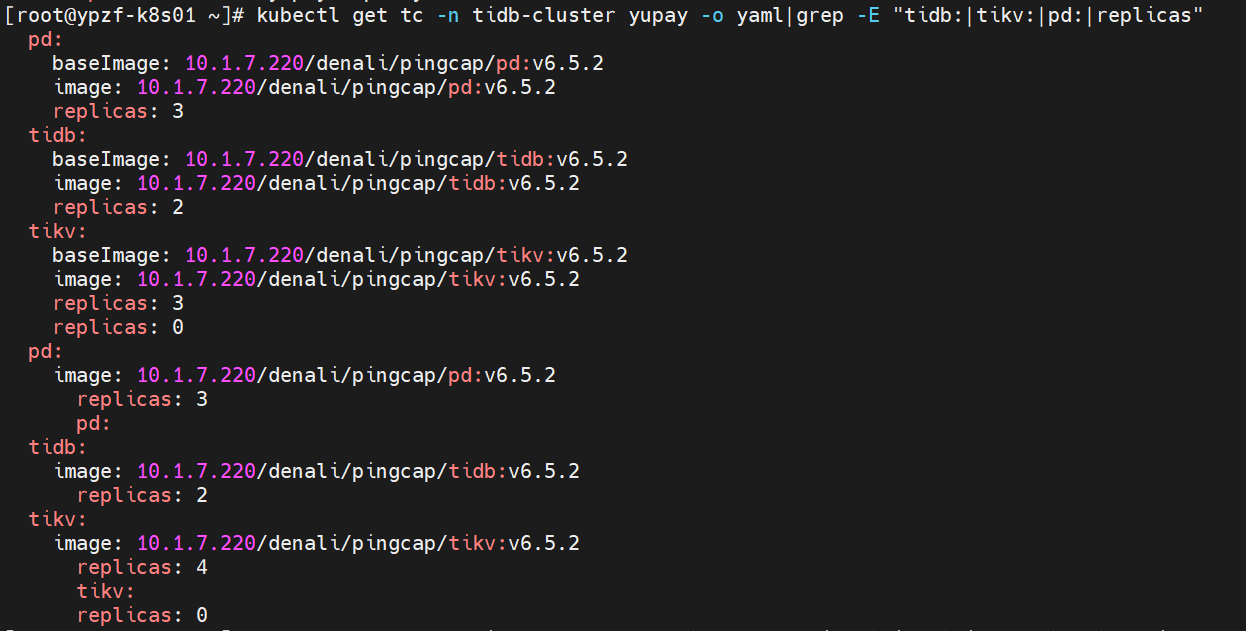

tikv目前 replicas 已经是3,但是 status 是 4. 我把 3 改为 3 没作用啊。

参考一下 https://docs.pingcap.com/zh/tidb-in-kubernetes/stable/use-auto-failover

另外使用的集群拓扑配置文件是从哪里的拷贝的? 官网的链接和 github example 里 maxFailoverCount 应该都改成 0 了 (默认 3),有遗漏的话可以提个 improvement issue

修改了 tc 配置,但是 tikv 无法自动 重启,于是手动给他扩容到4,结果蹦出了新的2个。。。

我要吐血了