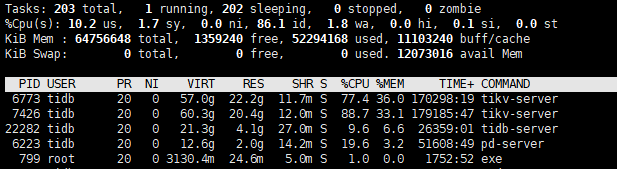

TIKV节点最近一直内存占用过高,一直不降,正常情况应该63%左右的内存占用,现在一直70%以上,什么原因呢?

默认设定是 单节点单服务的模式,你需要混合部署,要设定每个服务对这个节点的资源的占比,比较复杂

一般不推荐,运维也会更难

参考这里:

https://docs.pingcap.com/zh/tidb/stable/hybrid-deployment-topology

是默认配置吗,混合部署需要调整内存相关参数了,否则很容易OOM

混部要把 storage.block-cache.capacity设置小点,默认为机器内存的45%。

SHOW config WHERE NAME=‘storage.block-cache.capacity’

看一下是不是太大,像你65节点上1个pd,1个tidb,2个tikv,64G内存的话,建议1个tikv配个8G差不多了

这两个参数可以现在tikv内存使用

rocksdb.defaultcf.block-cache-size:

rocksdb.writecf.block-cache-size:

这个值部署的时候设置了10GB,目前这个值一直稳定10GB呢。

我设置了每个tikv 的storage.block-cache.capacity = 10GB

那光block-cache-size两个节点就各用了10G,我看你一个tikv进程也就占了18G左右的样子,那很正常吧,现在集群有啥异常吗?

剩余内存较少了,担心如果有大量的查询会造成节点重启。现在tikv节点的内存占用彪到22GB了

https://docs.pingcap.com/zh/tidb/stable/tune-tikv-memory-performance#tikv-内存参数性能调优

一般也就这样,你这种混合部署的话,建议numa再资源隔离一下

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。