【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】 5.4.2

【复现路径】 执行命令tiup cluster scale-in 缩容tikv后 发现问题

【遇到的问题:问题现象及影响】

发现各个tikv的leader不均匀有一个节点的tikvleader直接变成0了,region也分布恨不均匀

【资源配置】

【附件:截图/日志/监控】

【 TiDB 使用环境】生产环境 /测试/ Poc

【 TiDB 版本】 5.4.2

【复现路径】 执行命令tiup cluster scale-in 缩容tikv后 发现问题

【遇到的问题:问题现象及影响】

发现各个tikv的leader不均匀有一个节点的tikvleader直接变成0了,region也分布恨不均匀

【资源配置】

【附件:截图/日志/监控】

参考 SOP 吧

按照 SOP 的步骤,排查一下先,总结一下问题,如果还没办法解决,在继续追加一些资料在看看

都是按照官方文档操作的,已经过去2天了,这个tikv regin分布还是没有自动均衡

【SOP 系列 19】region 分布不均问题排查及解决不完全指南 这个页面404了

显示 糟糕!该页面不存在或者是一个不公开页面。

访问这个试试

你这个集群有点优秀,200多k的region数,真是NB,得多大的磁盘。

不均衡大概率是因为label的原因,比如说3副本,得在3台机器上。

ABC 3台机器的话,你A上2个tikv,那A上的2个tikv就平分1个副本,也就是A上的tikv1+tikv2=其他机器的region数。

先看一下各节点的打分情况吧,打分接近时,才可能百分百均衡

应该还是在调度参数上,排查流程按照上面的sop就好,确认下具体的调度参数是否合理

我这是一个kv一个服务器 不存在一个服务器2个kv的情况,缩容一个kv后各个kv的regin分布就不均衡了

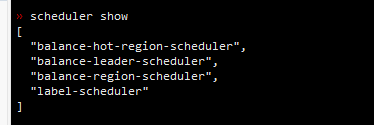

pd-ctl scheduler show

pd-ctl config show

pd-ctl store

拿上来看看

pd_show.txt (8.4 KB)

这个文件里有几个pd的参数

把 store 那个命令发下 。

store limit 后面 也可以对调度进行控制的。 您看下。

https://docs.pingcap.com/zh/tidb/stable/configure-store-limit#store-limit

pd_show.txt (8.4 KB)

结果在这个文件里