hanson

2023 年4 月 6 日 07:56

1

【 TiDB 使用环境】生产环境

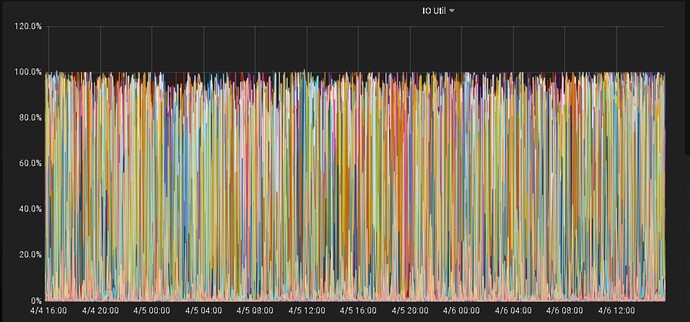

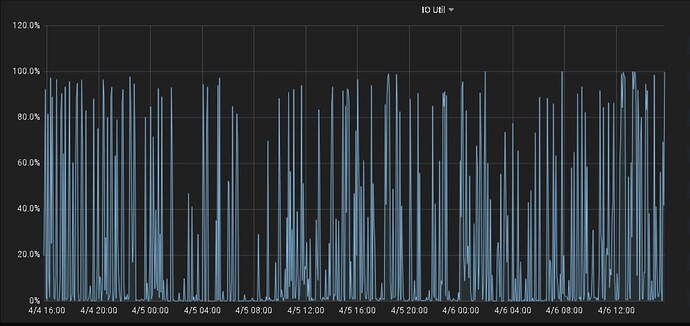

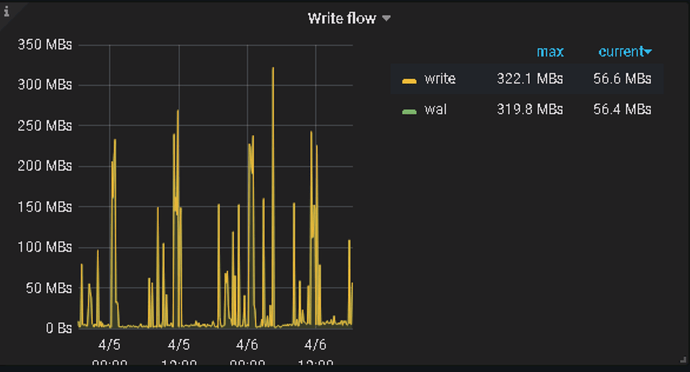

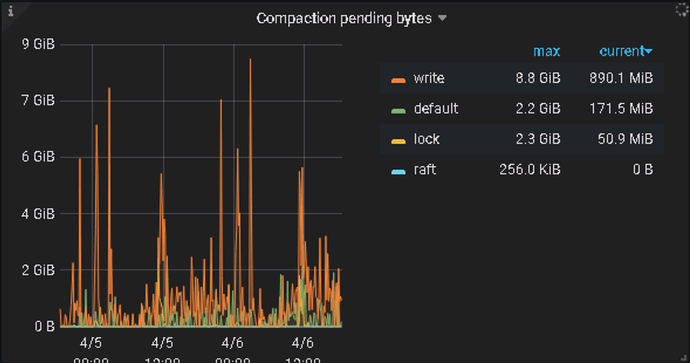

目前kv节点io一直占用很大。如第一张图,然后对应各台kv节点,就是第二张图这样。io占用是有高有低。

【资源配置】

dbaspace

2023 年4 月 6 日 08:31

2

1、检查下磁盘使用寿命情况,尤其是SSD

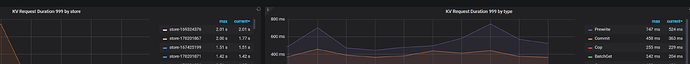

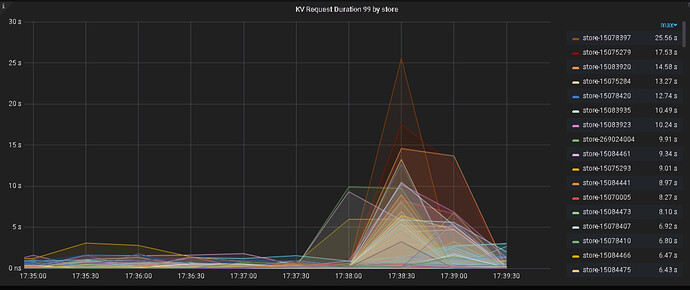

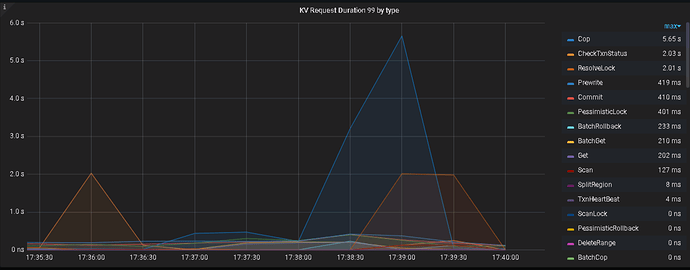

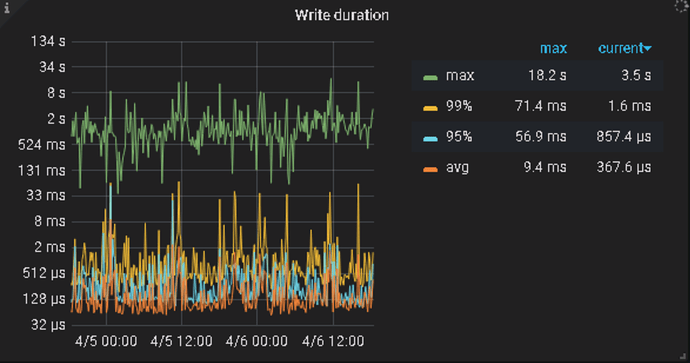

看下是否有TIKV duration值比较高

3、检查下磁盘具体的iops 或者吞吐情况

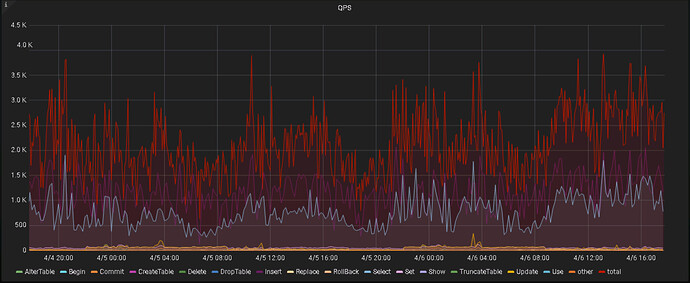

4、看看集群整体得QPS 情况

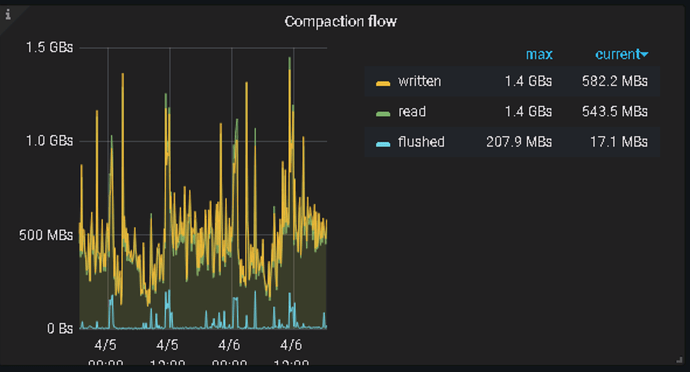

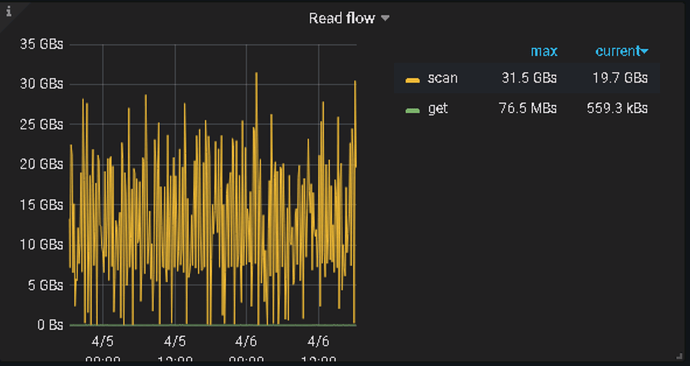

看看tikv-details->rocksdb-kv

hanson

2023 年4 月 7 日 06:42

8

节点部署跟官方手册有差异,文件系统是xfs,挂载方式也没加nodelalloc,noatime,不知道这两项对IO影响大吗?

dbaspace

2023 年4 月 11 日 02:37

11

看你这是读引起的,可以分析下几个TIDB-SERVER的那个点慢日志情况 ,及TIKV的慢日志,分析下慢日志和对应的REGION ,基本能够确定是哪个引起的

如果 TiKV 的磁盘 I/O 一直很高,可能是由于以下原因导致的:

热点读写:如果某个 TiKV 节点上的数据被频繁读写,就会导致该节点的磁盘 I/O 高。您可以使用 pd-ctl 工具来查看热点信息,具体命令为 pd-ctl hot read 和 pd-ctl hot write。如果发现某个 Region 的读写热点比较高,可以考虑对该 Region 进行拆分或者调整副本分布,以减轻该节点的负载。

大表写入:如果某个 TiKV 节点上的数据写入比较频繁,就会导致该节点的磁盘 I/O 高。您可以使用 pd-ctl 工具来查看 TiKV 节点的写入流量,具体命令为 pd-ctl store stats <store_id>。如果发现某个 TiKV 节点的写入流量比较高,可以考虑对该节点进行扩容,或者对数据进行分片,以减轻该节点的负载。

磁盘空间不足:如果 TiKV 节点的磁盘空间不足,就会导致磁盘 I/O 高。您可以使用 df -h 命令来查看磁盘空间使用情况。如果发现某个 TiKV 节点的磁盘空间不足,可以考虑对该节点进行扩容,或者清理磁盘上的无用数据。

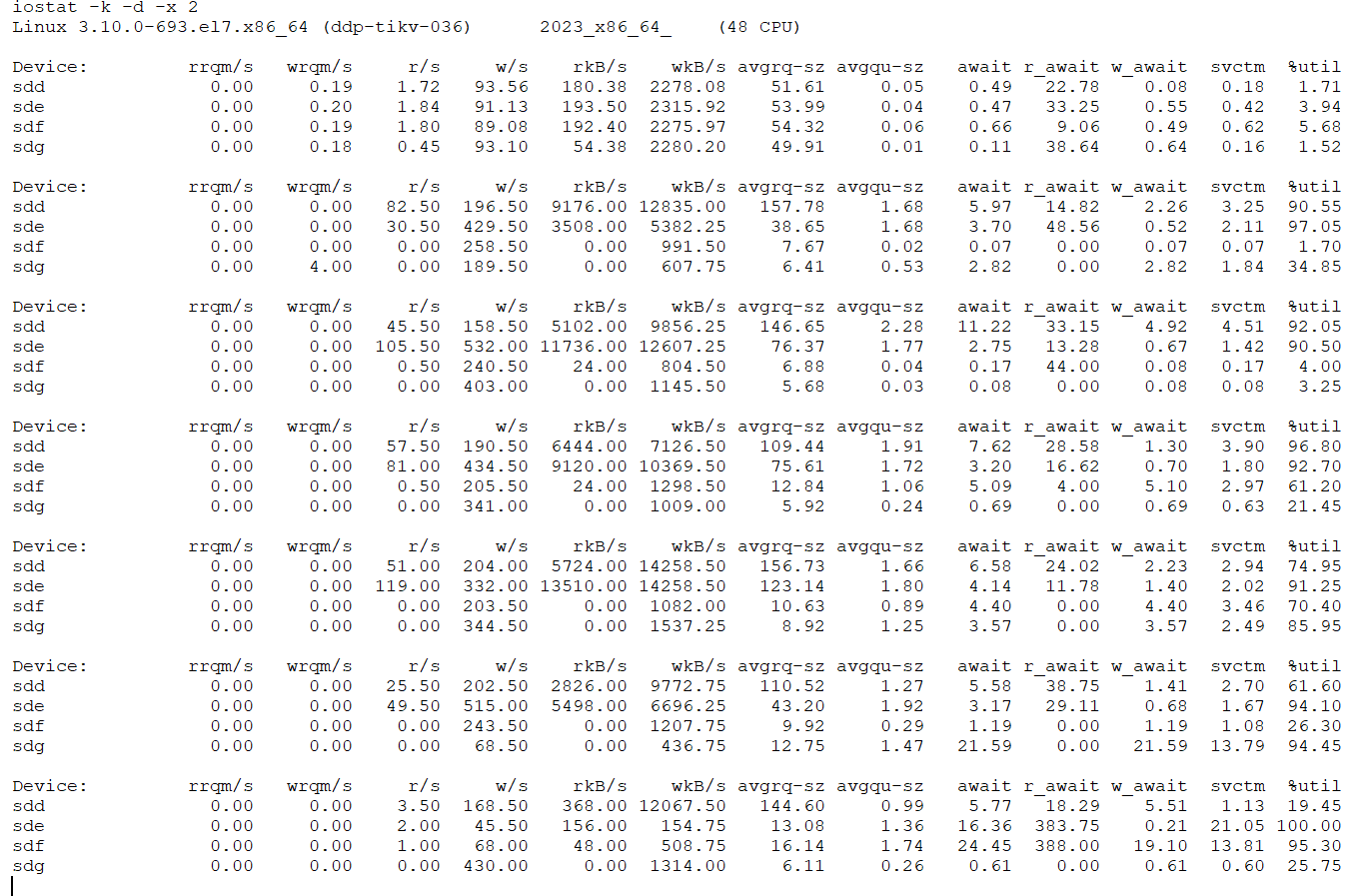

磁盘性能不足:如果 TiKV 节点的磁盘性能不足,就会导致磁盘 I/O 高。您可以使用 iostat 命令来查看磁盘的 I/O 性能。如果发现某个 TiKV 节点的磁盘性能不足,可以考虑对该节点进行升级,或者更换更快的磁盘。

1 个赞

hanson

2023 年4 月 20 日 01:18

13

感谢大家帮助,问题已定位。

system

2023 年6 月 19 日 01:19

14

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。