qhd2004

2023 年3 月 20 日 09:36

1

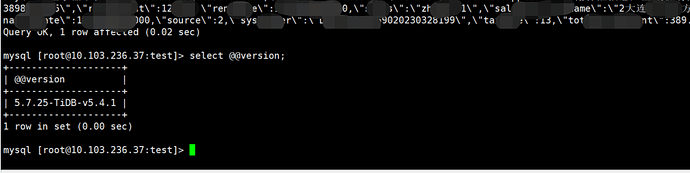

【 TiDB 使用环境】生产环境

【 TiDB 版本】

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】xxxx.xxx_xxxx_log(

表中有字段中有两个类型是text类型,我尝试把上游表mysqldump出来,然后导致到个人测试v6.5.1版本中是可以正常导入,

【资源配置】

qhd2004

2023 年3 月 20 日 09:49

3

统计信息相关在v5.3版本中做了修改。

我环境是v5.4.1与v6.5.0,我也查看了系统表表结构,三个列都已经是longblob类型了

qhd2004

2023 年3 月 20 日 10:22

4

在上游中查看,表中出现问题的id数据量时,发现为71797

mysqldump导出来后,手工导入个人测试环境v6.5.1中后查看,发现同样id大小为65535

因此是不是大v6.5.1版本中对text有某些限制呢?

xfworld

2023 年3 月 21 日 01:26

5

drainer 的支持性对于5.X 就有不兼容的地方, 至于6.X 就差太多了… 就没办法支持了

建议你切换成 ticdc…

qhd2004

2023 年3 月 21 日 02:40

6

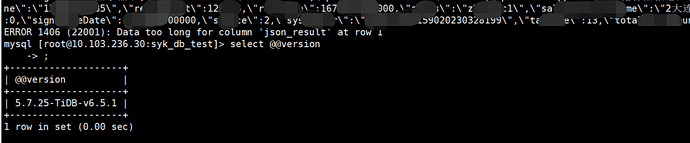

我把出问题的这条记录复制成insert语句,然后在两个环境中做了测试

在v6.5.1版本中,手要插入时报错,如下图

在文档中

那我要如何来调整数据类型的限制呢?把text调至大于6M

在https://docs.pingcap.com/zh/tidb/dev/tidb-configuration-file#txn-entry-size-limit-span-classversion-mark从-v50-版本开始引入span txn-entry-size-limit,此参数在v6.5.1中调整后,再次insert上面sql还是报错。

qhd2004

2023 年3 月 21 日 03:46

7

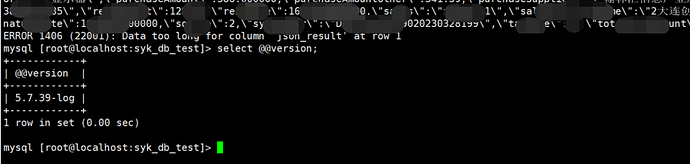

在v5.4.1中可以插入超过65535的这行记录,这个严格来说是bug。

我在mysql5.7.39中做了insert测试,发现也是data too long,跟v6.5.1中行为是一样的

说明:

下图是在mysql中的测试

qhd2004

2023 年3 月 22 日 01:24

10

跟这个参数关系不大,是text类型长度问题,v6.5.1版本跟mysql的行为一致了。而之前版本会把大于65535的成功插入。

system

2023 年5 月 21 日 01:25

11

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。