【 TiDB 使用环境】生产环境

【 TiDB 版本】

Cluster version: v4.0.9

【遇到的问题:问题现象及影响】

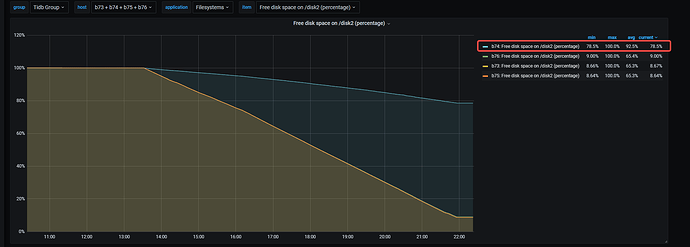

部署新TIDB集群,把老集群中的数据BR备份,然后restore到新集群。在restore过程中,发现某个tikv节点的数据存储和其他节点严重不均衡。

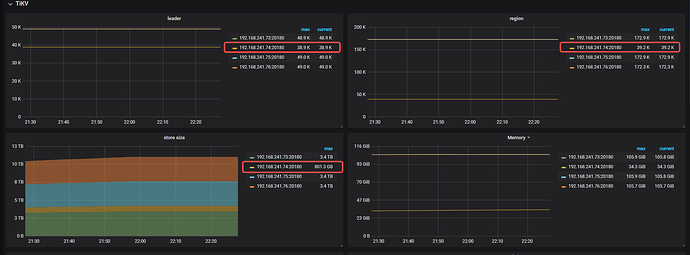

就是如下图:192.168.241.74节点的region数量非常少。 这几个tikv的硬件包括存储配置完全一样的。很奇怪为啥会出现这个问题,想请教下这问题怎么排查,谢谢~

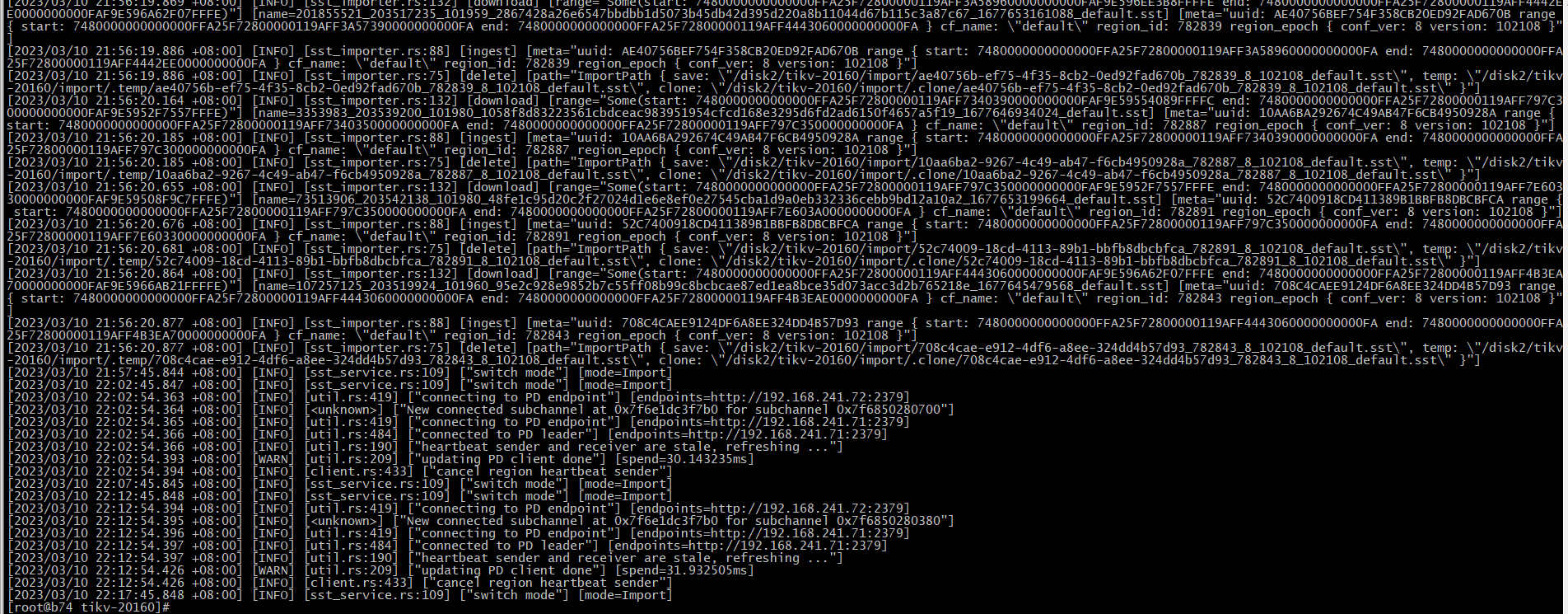

以下是这个节点的一点tikv 日志:

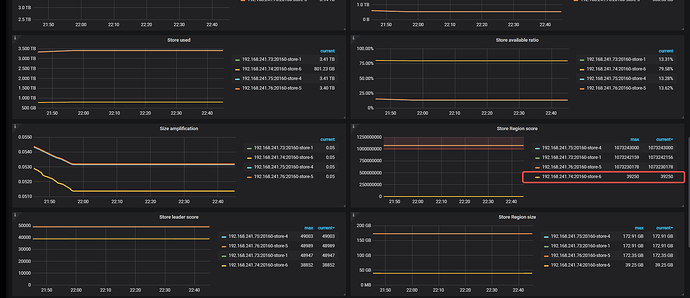

这几个TIKV节点是完全相同的配置,为啥打分会差这么多? 这说明了什么

看看调度设置吧,你这个感觉像是调度停了。

// Schedulers represent region/leader schedulers which can impact on performance.

Schedulers = map[string]struct{}{

“balance-leader-scheduler”: {},

“balance-hot-region-scheduler”: {},

“balance-region-scheduler”: {}

}

1 个赞

虽然不是很确定,但现在开始均衡数据了,可能是由于那些空region导致的。 那个异常的节点评分确实是低

我是用的4.0.9版本,默认是没有打开自动清理空region的。打开就好了

system

(system)

关闭

6

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。