【 TiDB 使用环境】生产环境 /测试/ Poc

生产环境

【 TiDB 版本】

v6.1.0

【复现路径】做过哪些操作出现的问题

region很小的节点是之前出过问题的节点,缩容后又重新扩容进来的

【遇到的问题:问题现象及影响】

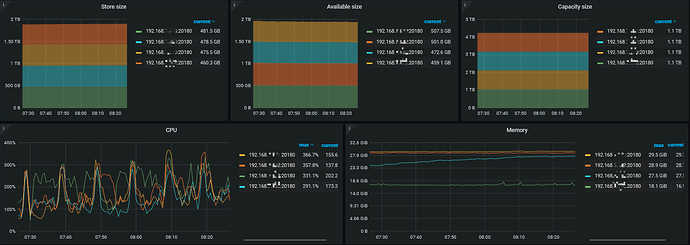

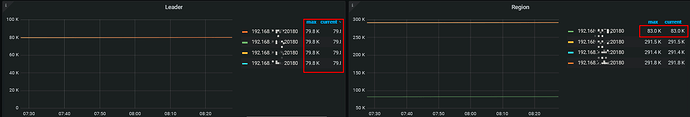

大家帮我分析下什么原因,怎么解决------让各节点比较均衡

【资源配置】

【附件:截图/日志/监控】

这个节点是什么时候扩容进来的?

10天左右了,这个状态也有一周左右了

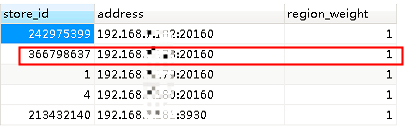

select store_id,address,region_weight from information_schema.tikv_store_status

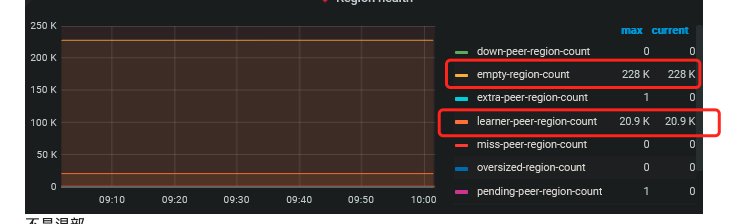

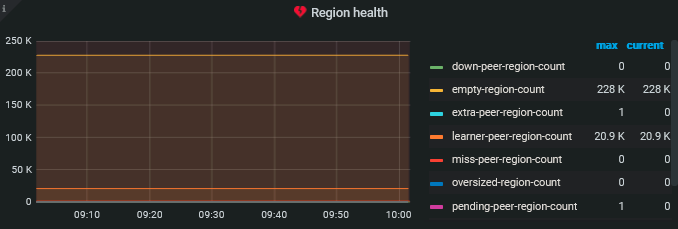

- PD–region health 监控贴下

- 是混部吗?有没有label

1 个赞

不是混部

pd-ctl store weight store_id xx xx 可以把少的那个的region weight 调高一些看看 ,具体命令–help看下。

从 可用空间看 空间占用大小是均衡的状态,region的均衡是调整的存储空间大小不是region数量。可能有些region比较大,可以看下 tikv troubleshoot页的huge region

我记得是哪个版本之前,计算score时只看存储

后来到了哪个版本,region数量过多也会影响score

记不清了 ![]()

tikv troubleshoot页的huge region是指监控还是官方文档?

我研究下

经常truncate drop吗 ,你把region health的时间拉长 看看是不是下降的趋势

有些计算数据表每天会truncate

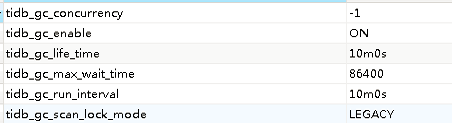

这样每天都会产生大量空region ,gc时间多久

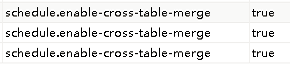

跨表合并region是不是关闭了?

enable-cross-table-merge

region health的时间范围拉长 看看是不是有下降的趋势或者下降上升的波动,如果有说明合并工作正常,每天truncate这问题没法避免,另外有tiflash的话会影响合并,因为tiflash是不能跨表共享region