DBRE

1

【 TiDB 使用环境】生产环境

【 TiDB 版本】5.1.1

【遇到的问题:问题现象及影响】

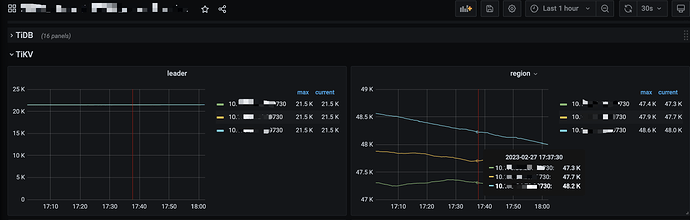

线上一套tidb集群有8个tikv,但是在Grafana overview页面只展示了3个tikv的region和leader, 如下图:

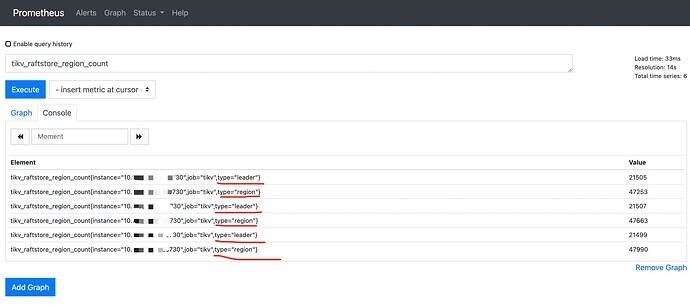

于是首先根据grafana里的metrics去对应的prometheus查询,实际上也只有3个tikv的metric,如下图:

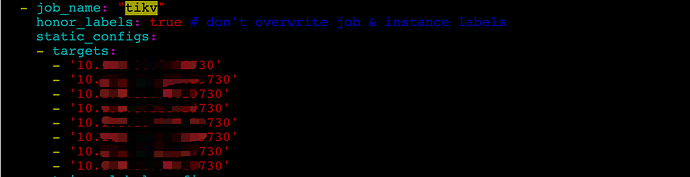

这说明Grafana的展示没有问题,于是看了下prometheus的配置,配置的是8个tikv,如下图:

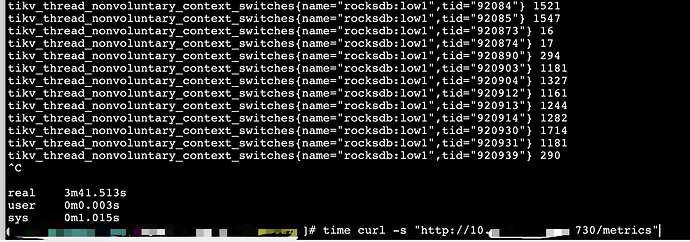

于是使用curl 对应的tikv api, 3m41秒还没有返回结果,怀疑是job超时了。找了其他tidb集群请求同样的tikv api,耗时在几十ms。

这种情况如何解决呢?

WalterWj

(王军 - PingCAP)

2

访问 Metrics api 用 3min41s啊,这个不是很预期。

DBRE

3

是的,tikv_thread_nonvoluntary_context_switches|tikv_thread_voluntary_context_switches|tikv_threads_io_bytes_total这3个metric输出巨多

curl 都要这么久,是不是 tikv 侧压力太大了,prometheus 去pull 数据的时候拉不到,导致的问题。

DBRE

5

压力还好,1.6w qps左右的insert,800qps的select, 可能与

tikv_thread_nonvoluntary_context_switches|tikv_thread_voluntary_context_switches|tikv_threads_io_bytes_total的输出很多有关系

WalterWj

(王军 - PingCAP)

6

输入到文本,如果文本很大,去反馈区反馈下。

以前有发生过类似问题,需要优化下 metrics

DBRE

7

找了一个tikv输出到了文本,耗时22秒(可能压力比昨天小的缘故),文本186M。

其中tikv_thread_nonvoluntary_context_switches有503907行,tikv_thread_voluntary_context_switches有503907行,tikv_threads_io_bytes_total有1007806行,我来反馈下

我是咖啡哥

8

请教下,这个怎么看的?哪个接口,能把地址发下吗?我去看看我的环境

DBRE

9

curl -s “http://${tikv_ip}:${tikv_status_port}/metrics”