【 TiDB 使用环境】生产环境

【 TiDB 版本】4.0

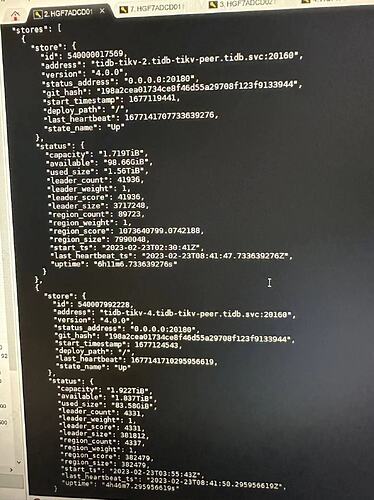

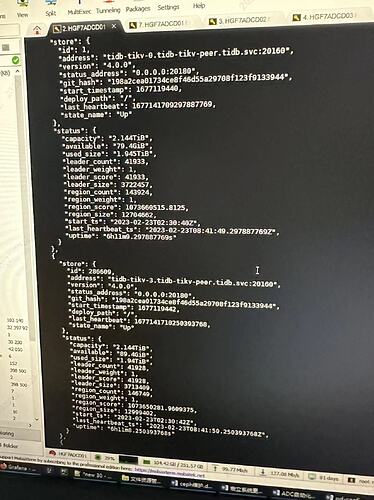

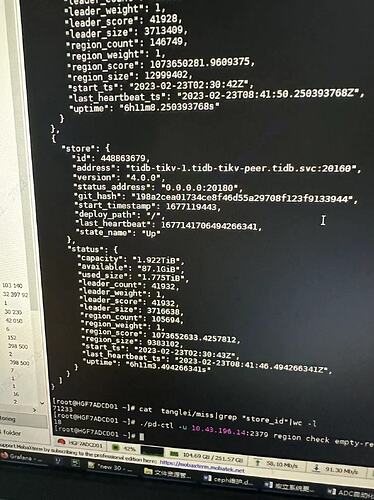

【复现路径】5个tikv节点,误删了2个节点tikv目录后,有个节点状态有问题所以,remove它变成offline。想它变成tomestone状态然后删掉。

【遇到的问题:问题现象及影响】

【资源配置】tikv 5节点 pd 三节点 tidb 2节点

tikv 2T/节点

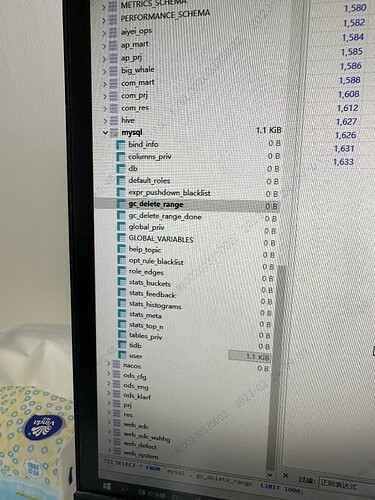

【复现路径】5个tikv节点,误删了2个节点tikv目录后,有个节点状态有问题,后来空间不够,truncate一个大表后,gc一直没有执行

【遇到的问题:问题现象及影响】

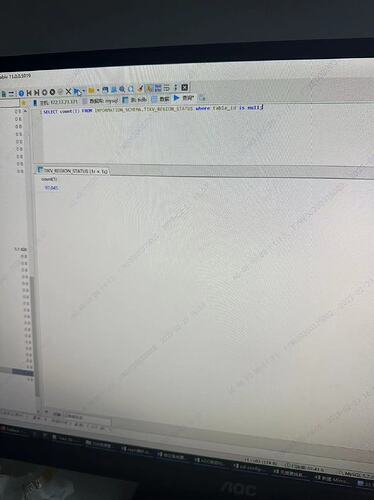

gc 到了 resolve locks 一直失败

[ERROR] [gc_worker.go:787] ["[gc worker] resolve locks failed"] [uuid=5cb549336b40001] [safePoint=417520979457343488] [error="loadRegion from PD failed, key: \""t\"\"x80\"\"x00\"\"x00\"\"x00\"\"x00\"\"x01m\"\"xcb_r\"\"xf8\"\"x00\"\"x00\"\"x00\"\"x01\"\"x8f\"\"xd7;\"", err: rpc error: code = Canceled desc = context canceled"] [errorVerbose="loadRegion from PD failed, key: \""t\"\"x80\"\"x00\"\"x00\"\"x00\"\"x00\"\"x01m\"\"xcb_r\"\"xf8\"\"x00\"\"x00\"\"x00\"\"x01\"\"x8f\"\"xd7;\"", err: rpc error: code = Canceled desc = context canceled\"ngithub.com/pingcap/tidb/store/tikv.(*RegionCache).loadRegion\"n\"tgithub.com/pingcap/tidb@/store/tikv/region_cache.go:621\"ngithub.com/pingcap/tidb/store/tikv.(*RegionCache).findRegionByKey\"n\"tgithub.com/pingcap/tidb@/store/tikv/region_cache.go:358\"ngithub.com/pingcap/tidb/store/tikv.(*RegionCache).LocateKey\"n\"tgithub.com/pingcap/tidb@/store/tikv/region_cache.go:318\"ngithub.com/pingcap/tidb/store/tikv.(

看了一个文章说是修改region-cache-ttl这个参数