玩具果冻

2023 年2 月 14 日 06:42

1

【 TiDB 使用环境】生产环境

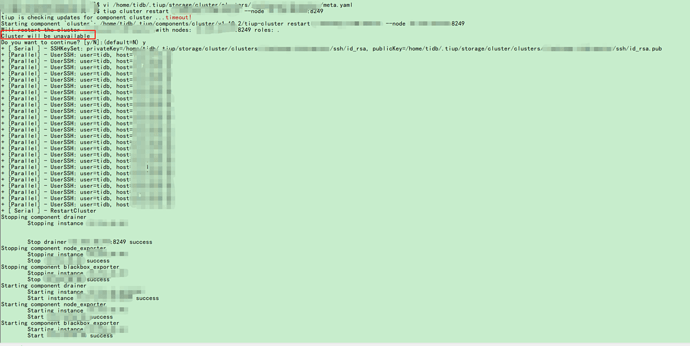

执行完tiup cluster restart tidb-name --node ********:8249这个命令后,出现了Cluster will be unavailable这个提示,想问下为什么restart指定节点会出现集群不可用的提示。之前我也经常会restart某个节点都很正常,集群都可用,这次不知道为什么会造成集群不可用,想请教一下各位老师,谢谢!

【资源配置】

【附件:截图/日志/监控】

你是meta文件改出问题了吧?你tiup cluster display cluster clustername看一下是不是报一样的错

玩具果冻

2023 年2 月 14 日 07:11

3

没有问题,重启之后集群都正常。就是重启的过程中,业务不可用。

玩具果冻

2023 年2 月 14 日 07:20

5

集群下游数据没有进行重做,下游的checkpoint表里有记录之前的ts值,官网上说了会优先去读取那个值的。

WalterWj

2023 年2 月 14 日 07:37

6

不推荐手动 vi meta 文件,使用 edit-config 语法去操作,会有格式等检查。

玩具果冻

2023 年2 月 14 日 08:12

9

就是把initial-commit-ts这个值改了一下。我想问一下 如果这个文件改的有问题,会导致集群不可用吗?但是重启之后集群都是正常的。为什么restart命令执行完就会有集群不可用的提示,这点不明白。

玩具果冻

2023 年2 月 14 日 08:13

10

嗯嗯,以后不会去改了。现在就是想知道为什么集群会不可用,所以才请教大家。不然后面再操作都不放心。

裤衩儿飞上天

2023 年2 月 15 日 00:26

11

现在是什么状态?集群可用吗?还是只是出现了那个报错(提示),没影响使用?

玩具果冻

2023 年2 月 15 日 02:33

12

drainer节点restart的过程中集群不可用。时间大概3分钟。重启成功之后,集群完全正常,都可用。现在的疑问点就是为什么restart drainer 的这个操作会报Cluster will be unavailable这个提示,造成restart的过程中集群不可用。因为之前也restart过其他节点多次,都没有影响到集群的可用性。

裤衩儿飞上天

2023 年2 月 15 日 06:57

13

没有手动 vi meta 文件,只要重启drainer集群就不可用吗?