【 TiDB 使用环境】生产环境

【遇到的问题:问题现象及影响】

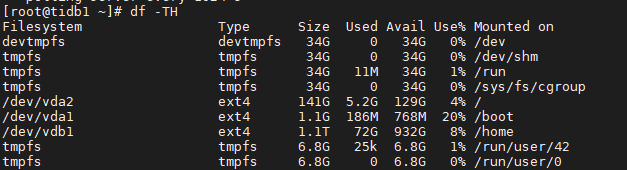

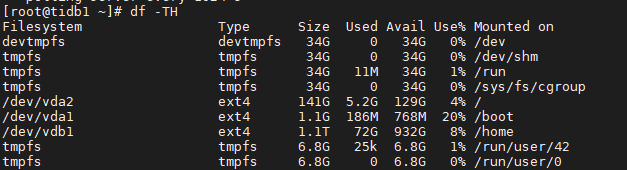

通过df -Th命令检查磁盘空间,占用最大是72G

在grafana中图表显示region大小是380G

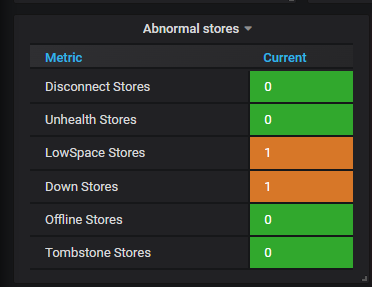

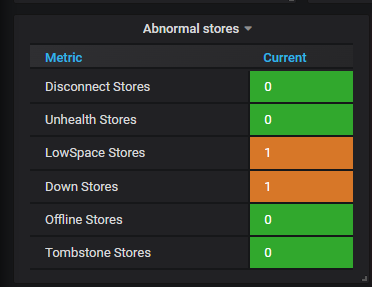

同时,还显示一个节点已经down,另外一个节点空间不足

剩余两个节点在不停balance,是因为都认为自己空间不足么?这是个bug么?

【 TiDB 使用环境】生产环境

【遇到的问题:问题现象及影响】

通过df -Th命令检查磁盘空间,占用最大是72G

在grafana中图表显示region大小是380G

同时,还显示一个节点已经down,另外一个节点空间不足

剩余两个节点在不停balance,是因为都认为自己空间不足么?这是个bug么?

可是目前实际物理环境有800G的可用空间,我担心tidb是按单副本300G去计算,如果按300G去计算就肯定空间不足了。

配置 capacity 了么?

pd_scheduler_store_status{tidb_cluster=“$tidb_cluster”, store=~“$store”, instance=“$instance”, type=“region_size”}

store_region_size应该不是实际的磁盘空间大小,我这里的一个集群每个tikv磁盘占用是400G,store_region_size是2T,感觉是5倍多一点,和你这个差不多

配置了,配置值为18G,按默认值应该是57G。这里调小有影响么?

我问的是 raftstore.capacity

这个没有单独配置,使用的默认值

那么理论上,默认值就是用的你 tikv data 目录的盘大小。

应该是和这个类似

你这监控也奇怪啊,2 T 总容量,用了 15G。region 数量却有 338336 个。然后正常的存储节点是 0.。

神仙了 ![]()

这个集群有做过什么操作么?比如 br 备份还原或者 lightning local 模式导入。

Dashboard里面的磁盘空间使用率呢?

做过br备份,应该没做过br还原。有大量的空region。

刚才升级到5.4.3了,升级后的一小会,这里显示的是正常的,过了一段时间,又变成300G了。就很奇怪

ui节点有问题,让我下线了,现在看不了dashboard