【 TiDB 使用环境】生产环境、测试

【 TiDB 版本】v5.1.0

【遇到的问题:问题现象及影响】生产环境目前6台Tikv服务器,先再扩容13台tikv,26日下午进行扩容的,当时一切正常,后面为加快速度调整部分参数,但是从昨天开始其中有二个节点反反复复重启一直到现在。

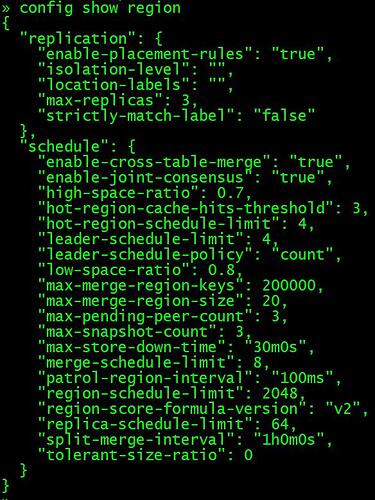

1、加速调整参数如下:

config set leader-schedule-limit 16

config set region-schedule-limit 8192

config set region-schedule-limit 8192

config set max-pending-peer-count 64

config set max-snapshot-count 64

config set replica-schedule-limit 96

2、恢复后参数如下

【附件:截图/日志/监控】二个有异常Tikv节点tikv日志如下:

139.rar (17.6 MB)

141.rar (17.6 MB)

二、2022年12月30日

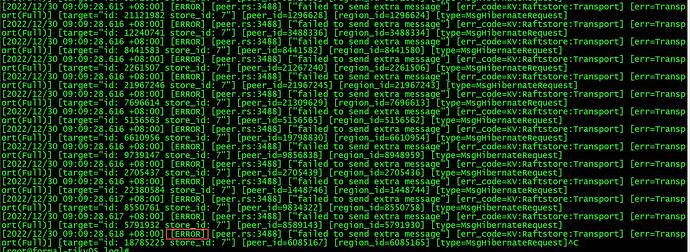

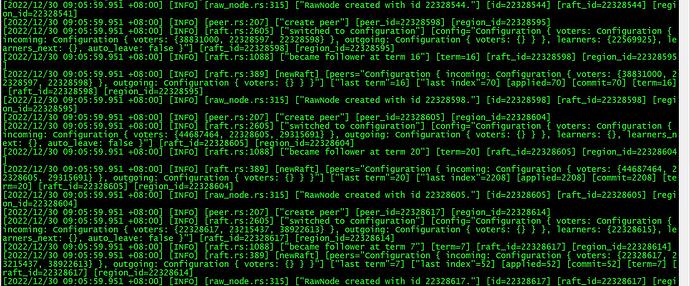

目前二个节点,141节点服务正常,但是tikv.log报如下错误(图一),不知可有影响。139节点服务down,但是tikv.log日志正常刷屏,我准备手动启动看看。

1、141 tikv.log日志

2、139 tikv.log日志