kuiper

1

【 TiDB 使用环境】生产环境

【 TiDB 版本】5.3.2

【复现路径】做过哪些操作出现的问题

【遇到的问题:问题现象及影响】

业务实际估算的空间占用大概在500GB,但是tikv已经占用了18TB了。整个集群开启了titan,都是大value,基本数据都在titan里,整个lsmtree数据非常小,所有sst文件数量加起来不到80个,但titan占用达到了18TB, 手动做过full compact,且把titan.discardable-ratio改成了0.1了,集群整体也只降低了1TB的大小,目前还占用17TB。

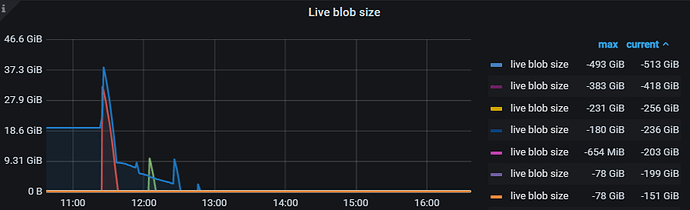

tikv的TitanDB-Kv中的Live Blob Size监控项有点古怪,全部是负数 都是-200GB的样子。

这个有什么办法排查吗,或者整体对titan做一次整理。

【资源配置】

【附件:截图/日志/监控】

查下 TiKV 的控制面板中,gc 的推进时间点是否正常

kuiper

4

TiKV监控面板的gc safepoint确实没动过, 但是tikv.log里的autogc里safepoint是有变化的。

tidb里代码确实有gc safepoint blocked by a running session的日志,但是这个怀疑是我们客户端连接不活跃导致的,这个集群目前确实没有什么访问,但是我看代码关于minstartTs的计算是有一个24小时的最大有效期判定逻辑的。

kuiper

5

gc safepoint blocked by a running session 虽然有刷这个日志,但是每天的safepoint是在变化的,但是tikv监控面板safepoint不变化。

tikv的日志也证实了这一点:

[2022/12/25 15:29:49.079 +08:00] [INFO] [gc_manager.rs:433] [“gc_worker: auto gc starts”] [safe_point=438275696821796872]

[2022/12/25 15:29:49.501 +08:00] [INFO] [gc_manager.rs:472] [“gc_worker: auto gc finishes”] [processed_regions=13666]

[2022/12/25 21:39:42.536 +08:00] [INFO] [gc_manager.rs:433] [“gc_worker: auto gc starts”] [safe_point=438291223833477130]

[2022/12/25 21:39:43.050 +08:00] [INFO] [gc_manager.rs:472] [“gc_worker: auto gc finishes”] [processed_regions=13666]

kuiper

6

刚确认了下,监控面板safepoint不变是监控grafana配置问题,promethus看safepoint是有在推进的,不过由于集群不够活跃,基本是每天safepoint推进一两次。但是我怀疑和这个关系不大,这个集群数据我们都是写入后就不做改动了,后续都是查询

live blob size监控统计的会有偏差,可以忽略。看一下 live blob file size,Blob file discardable ratio distribution 这个监控。以及配置是如何的

system

(system)

关闭

8

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。