【 TiDB 使用环境】测试

【 TiDB 版本】5.3.2

【复现路径】

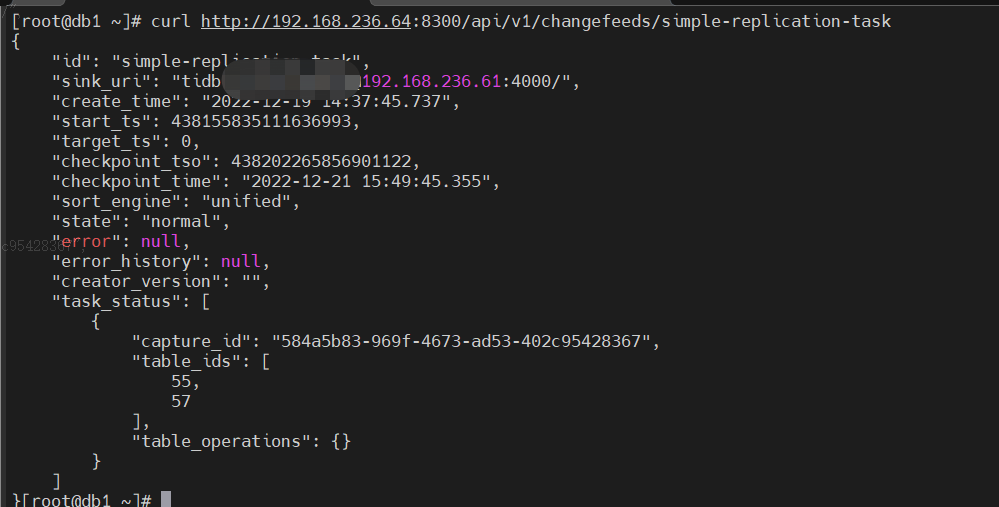

TiCDC在两个集群间进行单向同步

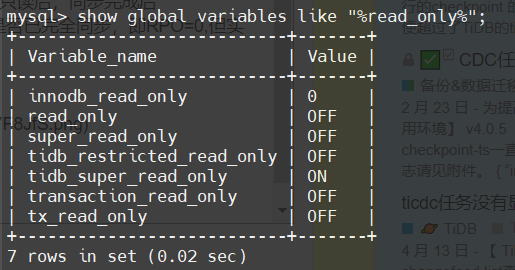

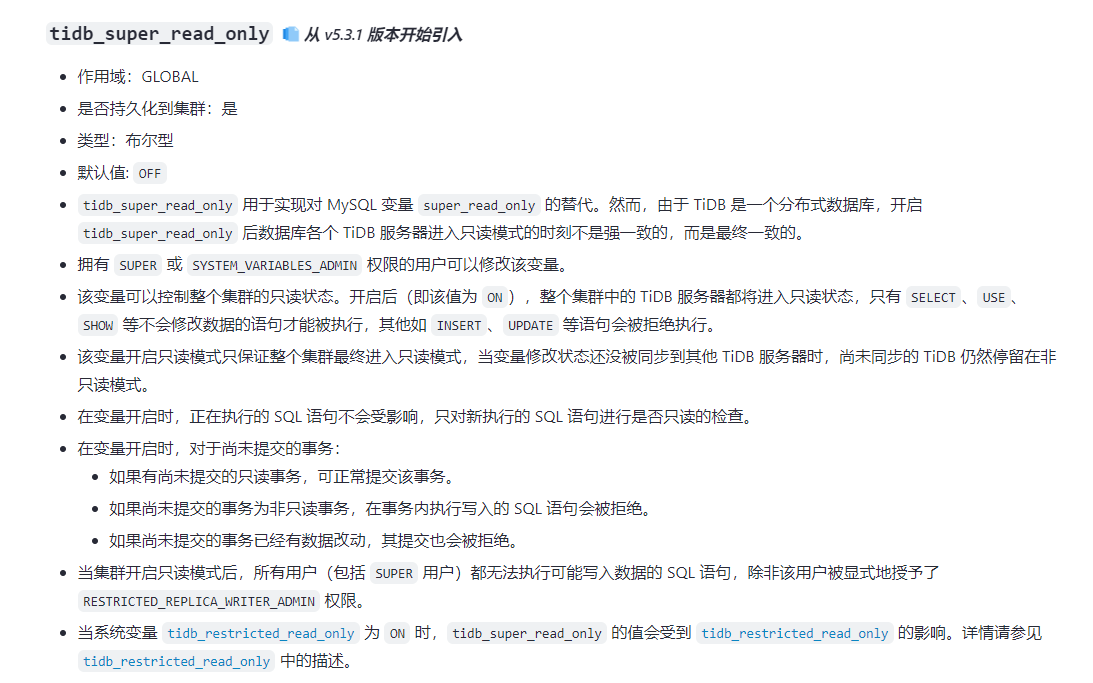

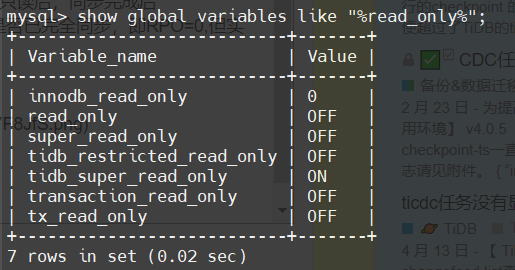

源端开启tidb_super_read_only参数,已无法读写

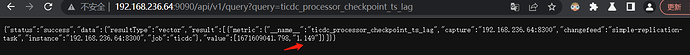

但ticdc_processor_checkpoint_ts_lag的指标仍然是>1s

【遇到的问题:问题现象及影响】预设想的是源端开启只读后,同步完成后ticdc_processor_checkpoint_ts_lag即可为0, 能判断是否已完全同步,即RPO=0,但实际上无法进行判断。

【资源配置】

【附件:截图/日志/监控】

源端 tidb_super_read_only 和 tidb_restricted_read_only 都开启的情况下,ticdc_processor_checkpoint_ts_lag指标依旧会大于1s,并且还会小范围波动,例如我现在的环境抽样取值,1.50,2.19,2.15,并没有变为0

1.开启只读的目的是为了使RPO变为0,用于两个tidb集群之间做容灾演练

2.下游任务连接tidb

3.开启只读后未查看日志是否有同步新信息

4.当前使用版本5.3.2,未使用6.2

neilshen

(Neil Shen)

6

processor lag 始终不为 0,是因为它的计算方式,如下

processor_lag = pd_leader_current_ts - ticdc_current_processor_checkpoint_ts

也就是 lag 是相对于 PD leader 上的物理时间的。

这种情况不需要依靠 lag 来判断,直接查看 changefeed checkpoint ts,当 checkpoint 时间戳超过开启只读的时间戳后,就说明已经完全同步了。

system

(system)

关闭

7

此话题已在最后回复的 60 天后被自动关闭。不再允许新回复。