没法拆呀,况且现在这个节点是leader,下次就不一定是leader了。看不出问题来吗?

1 个赞

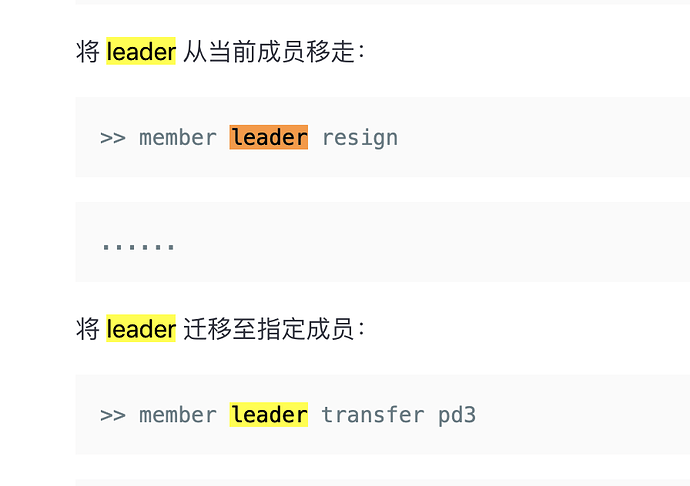

具体问题还没有思路,推测是因为混合部署影响的。下次就不一定是leader了 可以看下文档这里,可以指定 PD 的 leader https://docs.pingcap.com/zh/tidb/stable/pd-control#下载安装包

1 个赞

混合部署不是能够支持的吗?而且pd和tidb都是部署在单独磁盘上的。建议你们能不能从代码层面分析一下呢。

我们这个系统是核心系统。不能轻易的进行这么大的变更。

现在这种情况,对集群有什么影响吗?

我看了一下我们这所有的集群,包括测试环境,均有此报错。

这个报错频率跟业务量有关系吗?

请问这个还在继续分析原因吗?

这个报错是因为日志等级设置偏高打出来的 LOG 信息,不会影响集群使用,在 4.0.11 已经修复,具体 issue https://github.com/tikv/tikv/pull/9818 。另外出现报错的集群是什么版本?

v4.0.6版本,还请确认,谢谢

那么这个日志打印的问题在高版本已经修复,对业务是没有影响的。现在伴随着日志的输出,对线上有什么具体的影响吗?

暂时没有发现异常。谢谢!

![]() 好的

好的

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。