为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【概述】执行 scale in 缩容tiflash

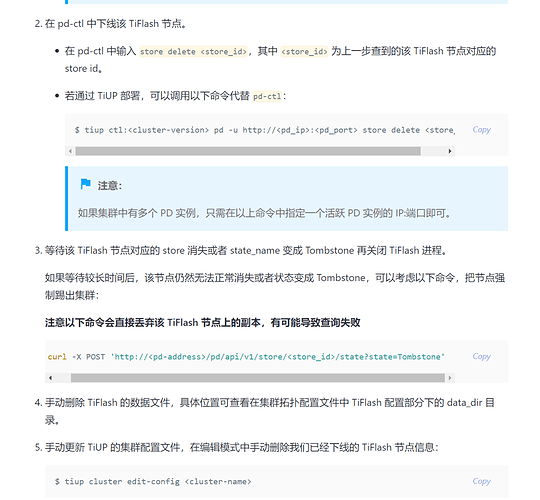

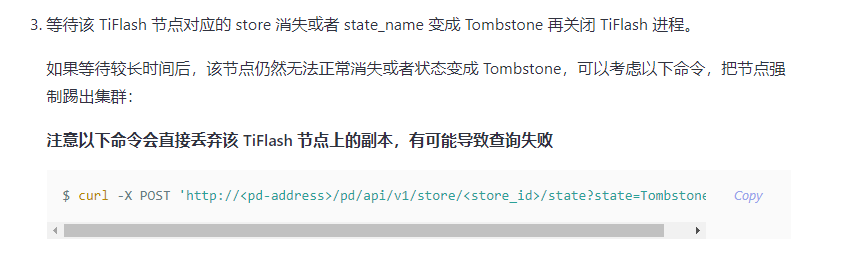

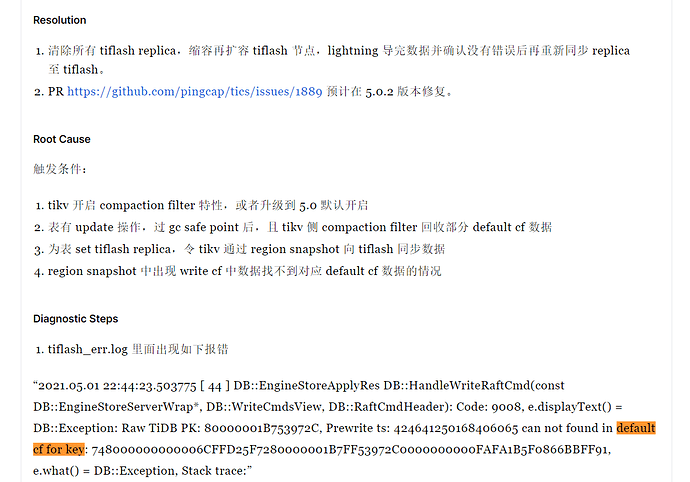

【背景】tiflash崩溃了,再也起不来,官方建议缩容然后重新做节点,按照文档执行了 set rep = 0 确认OK后,然后 scale in节点 ,节点数原来是 1,等于直接先关掉 tiflash了.现在的问题是,一直是 Offline ,然后 region 观察一直在上涨,现在,不敢按照官方的手动文档处理,那个文档本身描述就有问题,线上的,很重要不敢乱来

这个指令已经不能用 了

【现象】

[root@10_10_10_244 ~]# tiup ctl:v5.0.1 pd -u http://10.10.10.79:2379 store 2178519

Starting component ctl: /root/.tiup/components/ctl/v5.0.1/ctl pd -u http://10.10.10.79:2379 store 2178519

{

“store”: {

“id”: 2178519,

“address”: “10.10.10.58:3930”,

“state”: 1,

“labels”: [

{

“key”: “engine”,

“value”: “tiflash”

}

],

“version”: “v5.0.1”,

“peer_address”: “10.10.10.58:20170”,

“status_address”: “10.10.10.58:20292”,

“git_hash”: “1821cf655bc90e1fab6e6154cfe994c19c75d377”,

“start_timestamp”: 1622877183,

“deploy_path”: “/tidb-deploy/tiflash-9000/bin/tiflash”,

“last_heartbeat”: 1624748250562159830,

“state_name”: “Offline”

},

“status”: {

“capacity”: “3.436TiB”,

“available”: “1.823TiB”,

“used_size”: “1.613TiB”,

“leader_count”: 0,

“leader_weight”: 1,

“leader_score”: 0,

“leader_size”: 0,

“region_count”: 30132,

“region_weight”: 1,

“region_score”: 2217763,

“region_size”: 2217763,

“start_ts”: “2021-06-05T15:13:03+08:00”,

“last_heartbeat_ts”: “2021-06-27T06:57:30.56215983+08:00”,

“uptime”: “519h44m27.56215983s”

}

}

“region_size”: 2217763, 数量不降低,一直在增加,已经设置了所有表

SELECT * FROM information_schema.tiflash_replica 已经确认没有任何表了

【业务影响】

【TiDB 版本】 5.0.1

【附件】

- 相关日志 和 监控

-

TiUP Cluster Display 信息

-

TiUP Cluster Edit Config 信息

-

TiDB- Overview 监控

- 对应模块日志(包含问题前后1小时日志)

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。