为提高效率,请提供以下信息,问题描述清晰能够更快得到解决:

【概述】每天日志300G数据写入,求架构设计推荐

【背景】每天日志300G数据写入,求架构设计推荐

【现象】每天日志300G数据写入,求架构设计推荐

【TiDB 版本】v5.0.2

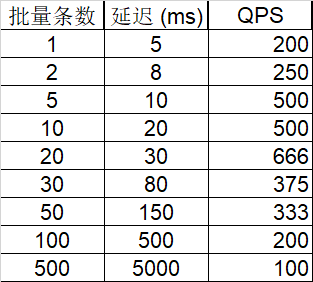

线上一日志业务(只有写入和查询),每天数据量大概300G,大佬们能否给个架构规划建议?几个pd,几个tidb,几个tikv,几个tiflash ?磁盘做raid 几?

【附件】

- 相关日志 和 监控

-

TiUP Cluster Display 信息

-

TiUP Cluster Edit Config 信息

-

TiDB- Overview 监控

- 对应模块日志(包含问题前后1小时日志)

若提问为性能优化、故障排查类问题,请下载脚本运行。终端输出的打印结果,请务必全选并复制粘贴上传。