[Critical bug] TiDB 并行aggregation spill 可能会导致结果出错

已打开 05:32AM - 08 Aug 24 UTC

已关闭 06:46AM - 12 Aug 24 UTC

type/bug

sig/execution

severity/critical

affects-8.0

affects-8.1

impact/wrong-result

affects-8.2

## Bug Report

Please answer these questions before submitting your issue. Tha… nks!

### 1. Minimal reproduce step (Required)

for a simple query like

```

select count(*), id from t group by id

```

if parallel spill is triggered, it will return wrong result.

### 2. What did you expect to see? (Required)

### 3. What did you see instead (Required)

### 4. What is your TiDB version? (Required)

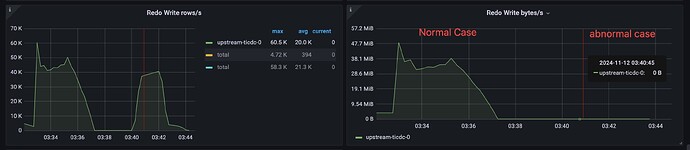

对于并行模式的 hash aggregation 算子(hash aggregation 算子默认即为并行模式),如果触发了 spil,对于特定的aggregation 函数(count 和 avg ),会返回错误的结果

根因

如果 hash aggregation 算子中带有 count 函数

如果 hash aggregation 算子没有被下推到 TiKV/TiFlash,且 hash aggregation 算子中带有 avg 函数

诊断步骤

这个判断主要依据是 explain analyze 的结果。在 explain analyze 结果中,对于 hash aggregation 算子,如果 partial_worker 或者 final_worker 的并发度大于 1,说明这个 aggregation 运行在 parallel 模式。如果 hash aggregation 算子的 disk usage 不是 N/A, 说明该 hash aggregation 触发了 spill。

以下面的 explain analyze 结果为例,该 query 中的 hash aggregation 触发了 parallel spill,因为:

partial_worker 和 final_worker 的并发度是 5

hash aggregation 算子的 disk usage 是 1.85 GB

mysql> explain analyze select count(), value from spill_test group by value having count( ) > 0;

这个判断主要基于 query 的 plan。如果一个 hash aggregation 被下推到了 TiKV/TiFlash,它会被转化成一个两阶段的 hash aggregation。其中一个 hash aggregation 算子的 task type 是 cop[tikv]/cop[tiflash]/batchcop[tiflash]/mpp[tiflash],另一个 hash aggregation 算子的 task type 是 root

以下面两个 query 的 plan 为例,plan 1 中 hash aggregation 被下推到了 TiKV,plan 2 中 hash aggregation 没有被下推到TiKV

plan 1

mysql> explain select count(), value from spill_test group by value having count( ) > 0;

mysql> explain select count(), value from spill_test group by value having count( ) > 0;

当 hash aggregation 触发了 parallel spill 时

如果 hash aggregation 被下推到 TiKV/TiFlash: count 函数会返回错误结果

如果 hash aggregation 没有被下推到 TiKV/TiFlash: count 和 avg 函数都会返回错误的结果

解决方法

这个 bug 会在 v8.1.1 中修复

绕过方法

set tidb_enable_parallel_hashagg_spill=0;

v8.1.0

v8.2.0

修复版本

v8.3.0

补充说明

在 v8.1.1 中我们会将 tidb_enable_parallel_hashagg_spill 的默认值改成 off。所以对于 v8.1.x(x != 0) 的新装集群,parallel hash agg spill 功能都会默认关闭。但是对于从 v8.0.0/v8.1.0 升级到 v8.1.x 的集群,tidb_enable_parallel_hashagg_spill 会保持集群的原有值(默认是 on),可以通过以下命令来显式关闭 parallel hash agg 的 spill

set @@global.tidb_enable_parallel_hashagg_spill=0;