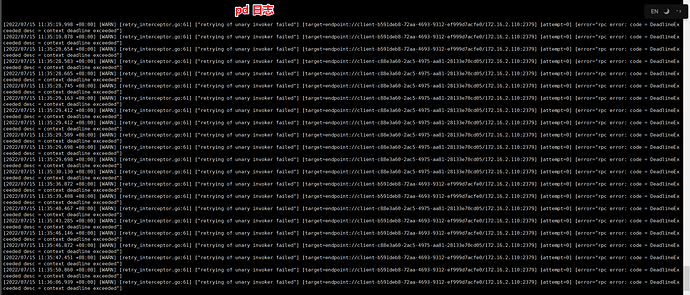

看 log 的感觉就是跟 pd 或者 tikv 的连接有问题![]() 如果您能提供一下完整的 log 可能可以看出是在哪个阶段报的错了

如果您能提供一下完整的 log 可能可以看出是在哪个阶段报的错了

现在30G都没导入成功, 如何优化呢?

现在还有个问题,数据库中看有部署数据是导入进去了,能查到数据,但是 SELECT COUNT(1) 行数为0

你换tidb server count 下看看

如果你有多个pd节点的话, pd-addr 换个其他的试试

没有详细的 pd 的日志吗?这两个日志都显示是 pd 有问题。我觉得导入之前先搞定这个吧,应该跟 Lightning 本身没有什么关系。但是 pd 我也不太懂,或许试一下重启一下集群之类的?

因为我单机部署了3个TIKV,系统会出现OOM情况。 通过限制tikv的内存使用率后,最终导入成功,tikv的增加如下配置参数:

[storage]

[storage.block-cache]

shared = true

capacity = “4GB”

rocksdb.defaultcf.block-cache-size = “4GB” #25% of system’s total memory

rocksdb.writecf.block-cache-size = “600MB” # or 15% of system’s total memory

rocksdb.lockcf.block-cache-size = “100MB” # 2% of system’s total memory

raftdb.defaultcf.block-cache-size = “100MB” # 2% of system’s total memory

1 个赞

忽略了 1个节点上 的多实例

就是说出现了OOM导致KV节点宕掉了,然后导入失败了?

该主题在最后一个回复创建后60天后自动关闭。不再允许新的回复。