【 TiDB 使用环境`】生产

生产环境现在需要将一套老的DM 集群迁移到新的DM集群上。有没有具体的操作步骤?

2、创建新集群数据库源

3、查看新集群数据源

4、停止老集群任务

5、查看任务是否正的停止

6、修改新集群任务

name: test5 # 任务名称,需要全局唯一

source-id: “mysql-replica-01”

7、检查新集群任务

8、启动新集群任务

9、查看新集群任务

10、清理老集群的数据源

小王同学Plus

2022 年5 月 31 日 03:00

2

weixiaobing:

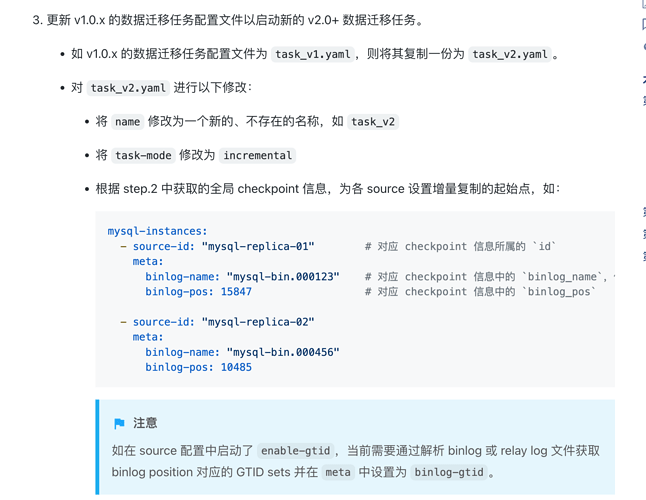

6、修改新集群任务

name: test5 # 任务名称,需要全局唯一

source-id: “mysql-replica-01”

主要注意点在第六步这块,下游 TiDB 中已经存在旧 task 的 checkpoint 信息。

看起来你是要创建新的增量同步任务,需要注意 task name 名字要和之前 task name 不一致。否则同步任务启动后,会以 dm-meta 中 checkpoint 开始复制,(虽然没啥大问题,不过还是谨慎一些好)

注意配置 task-mode: incremental 为增量同步模式,并且标注好增量同步的起始位点。

可以在测试环境测试下流程,翻了下暂时没有相关文档流程,如果顺利跑通,也可以分享给社区的小伙伴~

我就是要按照目前的checkpoint点同步,不然数据不就不一致了吗? 还是说我理解错了?

小王同学Plus

2022 年5 月 31 日 07:30

4

操作本身没问题啊,我记得低 DM 版本处理可能有点问题,所以建议你测试一下你的方式。

我说的方式是新建一个 增量同步任务,和之前任务名字区分开,增量同步的起始位点用之前 task 下游的 checkpoint 信息,这样操作也是可行的。

准备用5.4.0 的,换一个任务名字,这样更好是吧?

小王同学Plus

2022 年5 月 31 日 09:18

6

好的,我在测试环境模拟,用同样的名字也可以,还是换一个吧。谢谢!

小王同学Plus

2022 年5 月 31 日 09:21

8

嗯嗯,生产环境还是谨慎些,一旦出现问题,相同的 task 任务名会把原来的 checkpoint 覆盖掉了。

1 个赞

我看还可以这样操作 改变数据源与 DM-worker 的绑定关系

transfer-source 用于改变数据源与 DM-worker 的绑定关系。

Copy

help transfer-source

Transfers a upstream MySQL/MariaDB source to a free worker.

Usage:

dmctl transfer-source <source-id> <worker-id> [flags]

Flags:

-h, --help help for transfer-source

Global Flags:

-s, --source strings MySQL Source ID.

小王同学Plus

2022 年6 月 1 日 06:52

10

transfer source 这个适用于同一套 DM 集群内的操作,你这个场景下不适用的

可以用集群的导出导入功能,更简单https://docs.pingcap.com/zh/tidb/stable/dm-export-import-config

system

2022 年10 月 31 日 19:19

12

此话题已在最后回复的 1 分钟后被自动关闭。不再允许新回复。